Was wäre, wenn in Zukunft die AI eines Autos den emotionalen Zustand des Fahrers erkennen würde? Auf der Consumer Electronics Messe CES in LA wurde in diesem Jahr genau so ein Konzept vorgestellt. Es scannt biometrische Daten, erkennt und öffnet autorisierten Personen die Türen und passt automatisch die Musik an die Stimmung der Insassen an. Menschen sind emotionale Wesen und Computer werden immer besser darin, die Gefühle des Menschen zu verstehen und zu deuten. Affective Computing wird der – im Moment noch in vielen Fällen experimentelle – Bereich der Künstlichen-Intelligenz-Forschung genannt, bei dem Computer lernen, menschliche Grundemotionen zu erkennen und sogar selbst zu imitieren.

In unserem Überblickartikel erklären wir die grundlegenden Unterschiede der KI Begriffe, wie Künstlicher Intelligenz, künstlichen neuronalen Netzen, Machine Learning und Deep Learning.

Inhaltsverzeichnis

Wie Maschinen lernen, Menschen zu verstehen

Die Entwicklungen im Bereich der Künstlichen Intelligenz, genauer gesagt vor allem Machine Learning und Deep-Learning-Methoden führen dazu, dass intelligente Algorithmen Bilder immer besser erkennen und deuten können. Dies ist die Grundlage von Affective Computing, weil Bilder die Datenbasis zum Verständnis von Emotionen liefern.

Ein weiterer Schlüssel zum Verständnis menschlicher Emotionen und Mimik kommt aus der Psychologie bzw. der Semiotik. Forschungen aus diesem Bereich helfen dabei, die Codierungen von Gefühlsausdrücken zu systematisieren und anschließend zu entschlüsseln.

Der Bereich Machine Learning weckt Ihr Interesse? Werfen Sie einen Blick auf unsere Machine Learning Schulung

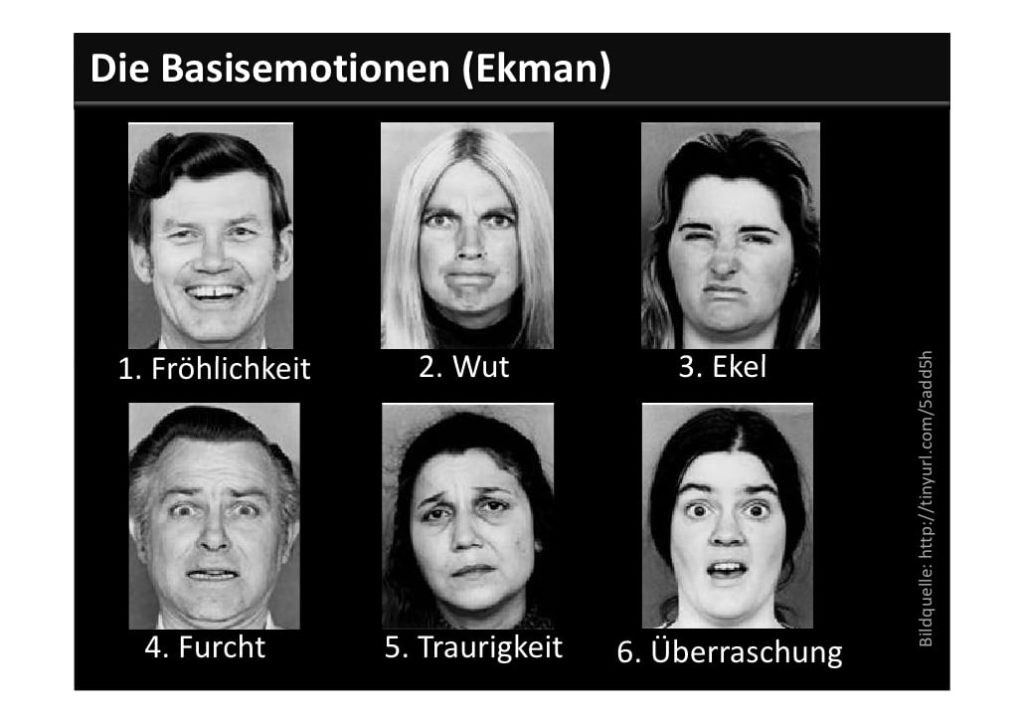

Beispielhaft dafür ist die Forschung von Paul Ekman. Ihm zufolge sind die sogenannten „Basisemotionen“ weltweit einheitlich codiert und universal verständlich. Entsprechend lassen sie sich einheitlich beschreiben, klassifizieren und sind auf diese Weise für intelligente Programme erkennbar.

Wenn intelligente Systeme mit Bilddatenbanken oder Bilderkennungssystemen ausgestattet sind, können sie auf ähnliche Weise viele weitere Gesichtsausdrücke anhand kleinster Unterscheidungsmerkmale systematisieren und kategorisieren. Für diesen Lernprozess benötigen Algorithmen Feedback. Dieses bekommen sie beispielsweise von den Mitarbeitern des MIT. Diese lassen jeden Tag beim Betreten ihres Arbeitsplatzes ihr Gesicht von einer AI scannen und geben an, in welcher Stimmung sie gerade sind. Auf diese Weise lernen intelligente Systeme immer mehr Gefühlsausdrücke zu verstehen.

Anwendungsbereiche von Affective Computing

Affecitve Computing kann für unterschiedliche Anwendungsbereiche genutzt werden. Ein Bereich, in dem sowohl das Verstehen von Affekten als auch die Simulation von menschlichen Emotionen notwendig ist, ist die Robotik. Dort lassen sich beispielsweise im Bereich Pflege und Rehabilitation beziehungsweise Ambient Assisted Living viel höhere Erfolgsquoten erzielen, wenn intelligente Roboter die Gefühlslage ihres Gegenübers verstehen und eine adäquate emotionale Reaktion darauf simulieren können. Das gleiche gilt für virtuelle Assistenten, die ihr menschliches Gegenüber dank Affective Computing besser verstehen können und durch die Simulation von Gefühlen menschlicher wirken.

Darüber hinaus gibt es jenseits des Robotics-Bereichs zahlreiche weitere Anwendungsbereiche, in denen Affective Computing eingesetzt werden kann. Dazu zählen vor allem alle möglichen Lern- und Bildungskontexte, da hier eine emotionale Komponente wesentlich zum Lernerfolg beiträgt. Aber auch die folgenden Bereiche werden von Affective Computing profitieren:

- Spieleindustrie: Auswertung des User-Feedbacks für mehr Sicherheit (z.B. Gewaltreduktion bei Videospielen).

- Service- und Healthcare-Bereich: Erkennung von Emotionen von Anrufern (z.B. in der Suizid-Hilfe).

- Chatbots: Verständnis der emotionalen Reaktion des menschlichen Gegenübers (Reduktion von Missverständnissen).

- Automotive: Analyse der Gefühlszustände der Fahrer (z.B. zur Individualisierung des Entertainments).

- Text-Mining: Verbesserung der Analysemöglichkeiten von Texten (z.B. bei Produktbewertungen).

Die Schnittstelle von Mensch und Maschine

Etwas allgemeiner formuliert ist Affective Computing an der Schnittstelle von Mensch und Maschine anzusiedeln. Schon heute ist es eines der zentralen Anliegen von Künstlicher Intelligenz, Menschen besser zu verstehen. Sei es durch Sprach- oder Bilderkennungssysteme. Affective Computing stellt in dieser Hinsicht eine logische Weiterentwicklung dieser Tendenz dar.

Bei der Entwicklung von Chatbots spielt Künstliche Intelligenz ohnehin eine tragende Rolle, wenn es beispielsweise darum geht, die natürliche, gesprochene Sprache des Menschen zu verstehen. Affective Computing bildet hier einen weiteren Baustein beim Versuch, die Schnittstelle zwischen Mensch und Maschine besser zu gestalten.

Künstliche emotionale Intelligenz als Weiterentwicklung der KI

Die Entwicklungen im Bereich Affective Computing lassen sich quasi als „natürliche“ Weiterentwicklung der KI-Forschung verstehen. Das Ziel ist es zunächst die kommunikativen Fähigkeiten von Maschinen zu verbessern. Gleichzeitig ergeben sich damit neue Spielräume etwa bei der Kollaboration von Mensch und Maschine. Wenn intelligente Maschinen wie Roboter die Gefühlslagen der Menschen in ihrer Umgebung besser verstehen lernen, steigt die Akzeptanz von computergestützten Systemen in unterschiedlichen Bereichen wie Pflege, Rehabilitation, Medizin, Bildung oder Spielindustrie.

Nicht zuletzt verspricht Affective Computing auch die Sicherheit in der Arbeitswelt zu verbessern. Besonders in kritischen Umgebungen wie im Krankenhaus oder in anderen gefährlichen Arbeitsumgebungen lassen sich Gefahrensituationen entschärfen. Indem Stresssituationen von Arbeitern oder emotionale Ausnahmezustände frühzeitig erkannt werden können, können auch bestimmte Arbeitsbereiche sicherer gemacht werden. Viele Entwicklungen im Bereich Affective Computing stehen noch am Anfang. Dennoch zeichnet sich das enorme Potenzial, das in dieser Entwicklung steckt, schon heute deutlich ab.

0 Kommentare