MAKE

DATA AI MACHINE LEARNING

WORK

Kunden die uns vertrauen

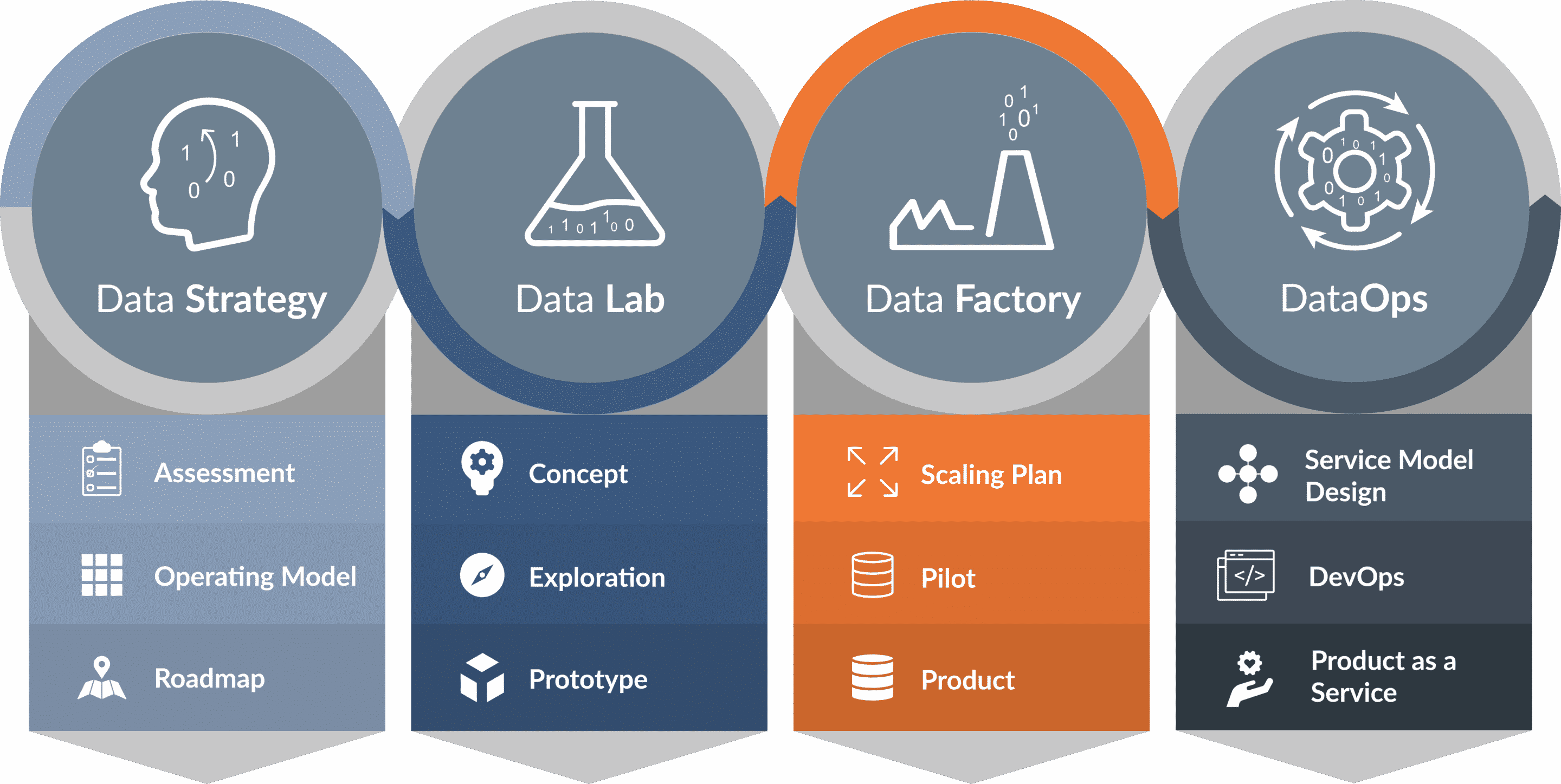

4 Säulen für Ihre Digitale Transformation

Daten und KI eröffnen uns allen neue Möglichkeiten.

Um dieses enorme Potenzial zu nutzen und Innovationen zu ermöglichen, gliedern wir unsere Services in vier Bereiche:

Um dieses enorme Potenzial zu nutzen und Innovationen zu ermöglichen, gliedern wir unsere Services in vier Bereiche:

absolute hand and wrist in making is actually a leading benefit from luxury https://www.luxurywatch.to/ watches. choose cartier replica watches our online store. great quality https://www.cloneswatches.com/. welcome to our versacereplica.to shop. the unique expenditure of money advantage is about the best things about the best tomfordreplica.ru in the world. the actual substantial component may be the benefit of high quality wholesale chloe. https://www.vancleefarpels.to/ are the perfect mix between italian design and swiss technology at the service of the passion for the sea.

DataStrategy

Entwicklung Ihrer Datenstrategie

DataLab

Optimierung von KI und Analytics Anwendungen

DataFactory

Implementierung von Datenprodukten

DataOps

Sorgenfreier Regelbetrieb

Unsere Arbeitsmethode

Die [at] Data Journey

Wie generieren wir aus Daten Mehrwerte, damit aus Problemen konkrete Lösung werden?

Mit der Data Journey haben wir ein ganzheitliches System für Data & AI-Projekte entwickelt, mittels dessen wir die Ausgangslage und Problemstellungen unserer Kunden ganzheitlich betrachten, um diesen die bestmöglichen Lösungen bieten zu können.

KI und Data Science Cases Studies

Versicherung Automotive Logistik Energiebranche Handel & E-Commerce

European AI Act

Technologische und rechtliche Beratung

Data & AI Wissen

Gemeinsam Mehrwerte aus Data & AI schaffen