Grundlagen der Datenvisualisierung

Was gute Datenvisualisierung ausmacht – und warum Tabellen nicht dazugehören

- Veröffentlicht:

- Autor: Dr. Kathrin Guckes

- Kategorie: Deep Dive

Inhaltsverzeichnis

Nach einem ersten Blick auf die Überschrift mag schnell die Frage aufkommen: Warum ist das eigentlich wichtig? Schließlich arbeiten viele längst routiniert mit Excel und großen Tabellen, während Visualisierungen oft nur als schmückendes Beiwerk für Präsentationen gesehen werden.

Ich kann Ihnen versichern: Visualisierungen besitzen Fähigkeiten, die sie für Datenanalyse und -präsentation unverzichtbar machen. Besonders ihre Stärke, Muster sichtbar zu machen, habe ich während meiner Zeit als Doktorand und später als Datenvisualisierungsexperte bei [at] schätzen gelernt. Genau deshalb sollten Visualisierungen in der Analyse den Mittelpunkt bilden, ergänzt durch Tabellen und nicht umgekehrt.

Dieser Blogbeitrag beleuchtet die Stärken und die zentrale Bedeutung der Datenvisualisierung und geht der Frage nach, welche Rolle Tabellen in der Datenanalyse und -darstellung einnehmen sollten.

Das Anscombe-Quartett

Als der Statistiker Francis Anscombe 1973 das berühmte Anscombe-Quartett veröffentlichte, zeigte er: Datensätze mit nahezu identischen statistischen Kennzahlen wie Mittelwert, Varianz und Korrelation können völlig unterschiedlich aussehen, sobald man sie grafisch darstellt. Damit stellte er die gängige Praxis infrage, sich allein auf zusammenfassende Statistiken zu stützen, und forderte, Visualisierungen als festen Bestandteil der Datenanalyse zu begreifen.

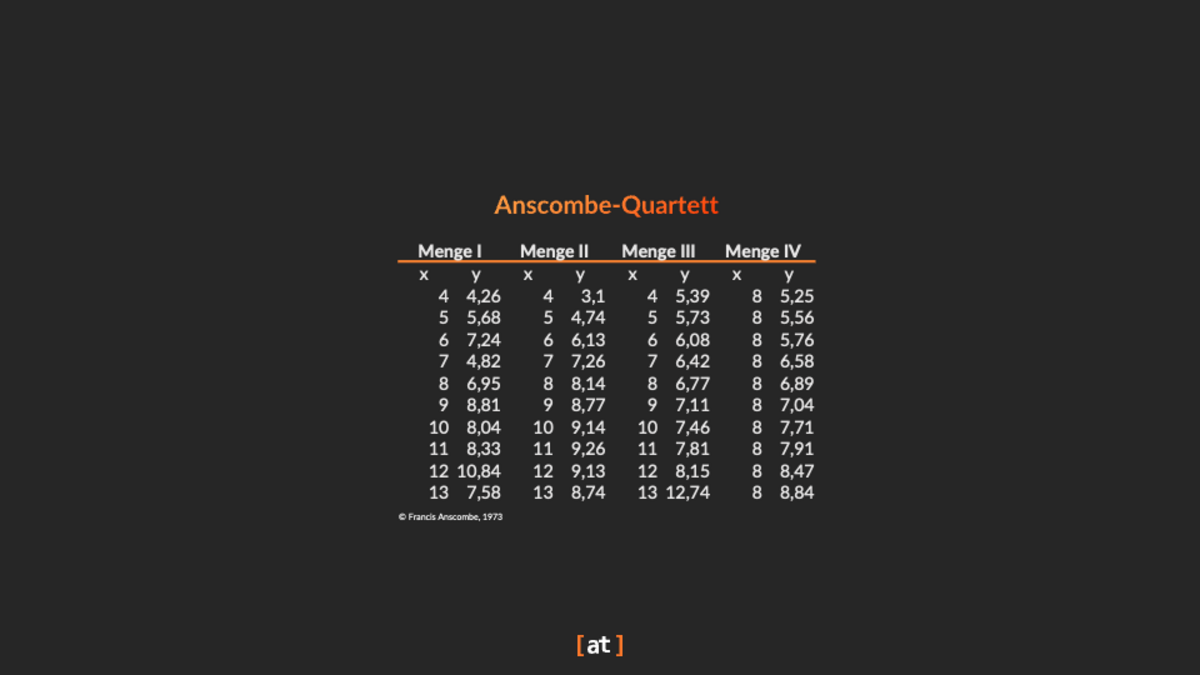

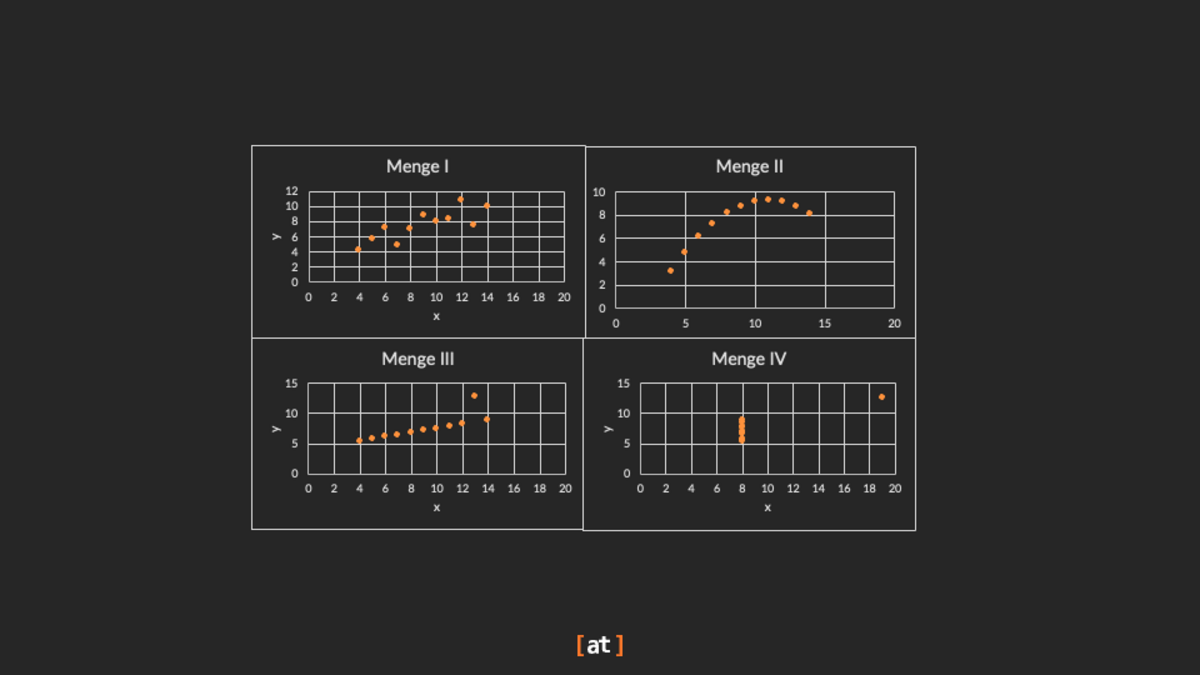

Das Anscombe-Quartett (siehe Tabelle1 und Abbildung 1) umfasst vier Datensätze mit jeweils 11 Paaren von x- und y-Werten. Obwohl sie fast identische statistische Eigenschaften teilen, offenbaren ihre visuellen Darstellungen höchst unterschiedliche Muster. Anscombes Beitrag machte damit eindrücklich deutlich, wie wichtig grafische Analysen sind – und wie stark Ausreißer oder ungewöhnliche Verteilungen die Interpretation von Daten verändern können (Anscombe, 1973).

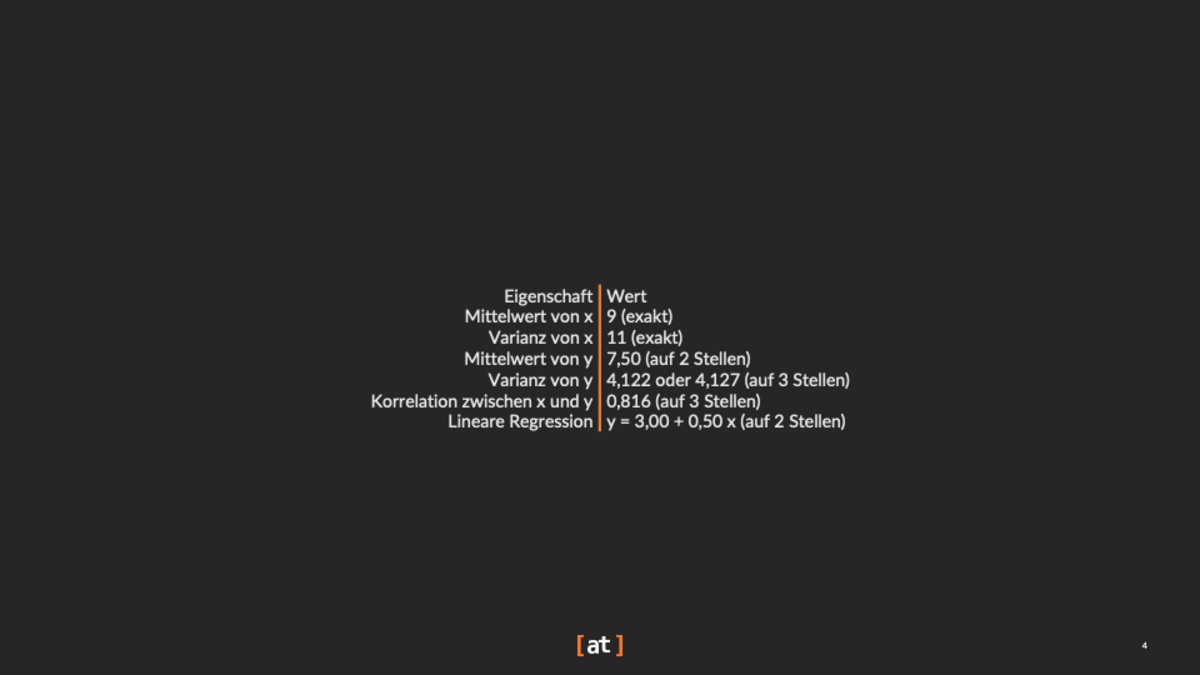

Die vier Datensätze weisen die folgenden deskriptiven statistischen Eigenschaften auf:

Das Streudiagramm (scatter plot) von Datensatz I zeigt eine klare lineare Beziehung zwischen den Variablen x und y. In Datensatz II ist zwar ebenfalls ein Zusammenhang erkennbar, allerdings nicht in linearer Form. Das Streudiagramm von Datensatz III weist ebenfalls auf eine lineare Beziehung hin, die jedoch durch einen deutlichen Ausreißer gestört wird. Im vierten Datensatz liegen die meisten Punkte eng beieinander, auch hier fällt jedoch ein einzelner Ausreißer ins Gewicht.

Nichts davon ist in den deskriptiven Statistiken der vier zweidimensionalen Sätze erkennbar. Noch schwieriger ist es, diese Muster in der Datentabelle (Anscombes Qaurtett, vgl. Tabelle 1).

Anscombes Botschaft ist bis heute relevant. Sein Quartett erinnert eindringlich daran, nicht allein auf zusammenfassende Statistiken zu vertrauen, sondern Daten stets auch zu visualisieren, bevor Schlussfolgerungen gezogen werden. Daran knüpfen viele moderne Arbeiten in der Datenvisualisierung an: So zeigen etwa Matejka und Fitzmaurice (2017) mit Streudiagrammen oder Chen et al. (2021) mit Netzwerkvisualisierungen, wie sich Datensätze erzeugen lassen, die zwar identische statistische Kennzahlen aufweisen, aber völlig unterschiedliche visuelle Muster.

Man könnte sich nun erneut fragen: Warum lassen sich solche Muster nicht einfach in einer Tabelle erkennen? Die Antwort ist einfach: Eine Tabelle ist keine Visualisierung.

Warum eine Tabelle keine Datenvisualisierung ist

Eine Tabelle kann zwar viele wertvolle Informationen enthalten, gilt jedoch nicht als Form der Datenvisualisierung. Per Definition umfasst Datenvisualisierung den Einsatz grafischer Mittel wie Diagramme, Plots oder Karten, um Erkenntnisse und Muster sichtbar zu machen (Few, 2009). Eine Tabelle dagegen ordnet Informationen vor allem in Zeilen und Spalten – ohne visuelle Kodierungen oder grafische Elemente, die Zusammenhänge sofort erkennbar machen.

Fehlende visuelle Einbettung

Ein wesentlicher Grund, warum Tabellen nicht als Datenvisualisierung gelten, liegt in ihrer geringen Nutzung visueller Kodierungen. Unter visuellen Kodierungen versteht man die grafische Darstellung von Datenpunkten durch Merkmale wie Position, Größe, Form oder Farbe (Ware, 2012). Tabellen greifen im Gegensatz zu Diagrammen oder Grafiken kaum auf solche Mittel zurück, was es deutlich erschwert, Informationen auf einen Blick zu erfassen und Muster intuitiv zu erkennen.

Schwierigkeiten, Muster zu erkennen

Tabellen verlangen vom Betrachter, einzelne Zahlen oder Texte bewusst zu lesen und geistig zu verknüpfen, um Trends, Zusammenhänge oder Ausreißer zu erkennen. Dadurch entsteht eine höhere kognitive Belastung. Visualisierungen hingegen lassen Muster und Entwicklungen durch grafische Darstellung schnell sichtbar werden, ohne bedeutende kognitive Anstrengung (Card, Mackinlay & Shneiderman, 1999).

Begrenzte räumliche Darstellung

Die räumliche Anordnung ist ein zentrales Mittel, um Beziehungen zwischen Datenpunkten sichtbar zu machen (Tufte, 2001). Visualisierungen nutzen diese räumliche Positionierung gezielt zur Verbesserung des Verständnisses, während Tabellen Daten meist in festen Zeilen und Spalten darstellen und dadurch nur wenig räumlichen Kontext bieten.

Stuart Card’s Visualisierungs-Pipeline

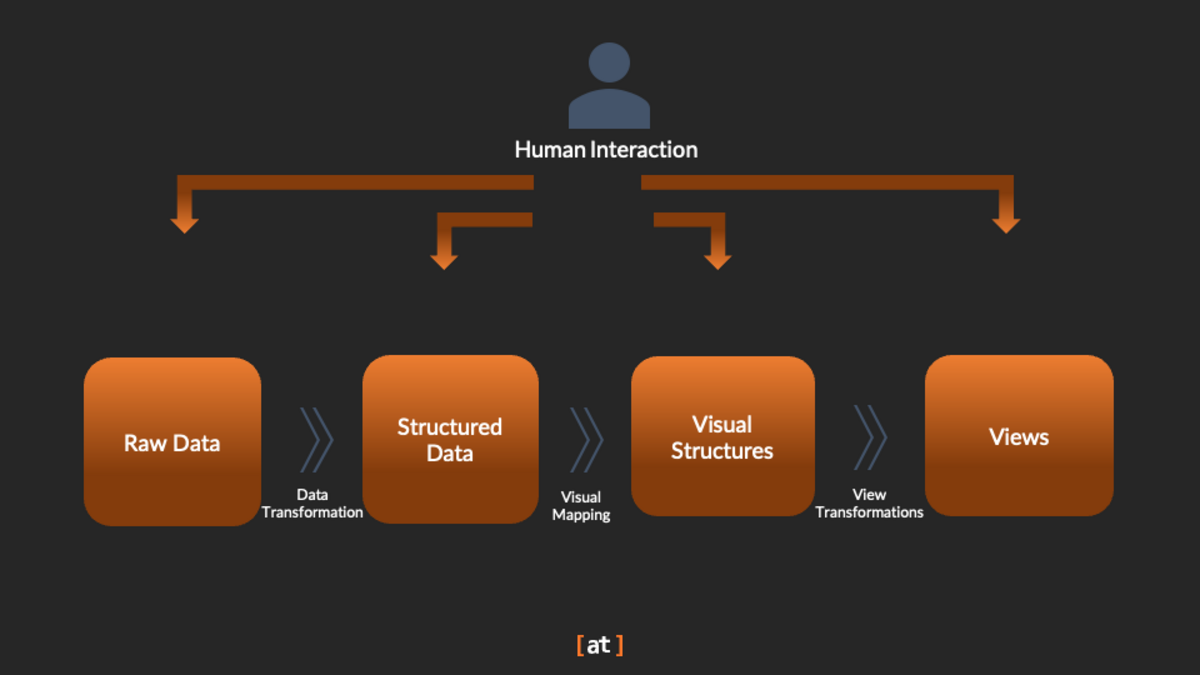

Um zu verstehen, warum Tabellen nicht als Datenvisualisierung gelten, lohnt sich auch ein Blick auf Stuart Cards Visualisierungspipeline (vgl. Abbildung 2). Sie beschreibt den systematischen Prozess, bei dem Rohdaten in verwertbare Erkenntnisse transformiert werden:

In der Anfangsphase werden Rohdaten aus verschiedenen Quellen gesammelt. Durch Datenumwandlungstechniken werden diese Rohdaten zu strukturierten Daten mit einer bestimmten Datenqualität umgewandelt. Die Datenumwandlung umfasst das Filtern und Aggregieren von Daten, oder das Ersetzen fehlender Werte. Tabellen eignen sich gut für diesen Schritt, da sie aufgrund ihrer Zeilen-Spalten-Struktur strukturierte Informationen effektiv speichern können. Jede Zeile kann eine bestimmte Entität darstellen, z. B. ein Auto, und jede Spalte kann einen bestimmten Leistungsindikator darstellen, z. B. einen bestimmten Sensor.

In der Phase der visuellen Strukturierung, in der Tabellenspalten in grafische Darstellungen übersetzt werden, wird deutlich, warum Tabellen nicht als Datenvisualisierung gelten. Sie nutzen keine visuelle Kodierung, sondern stellen Informationen rein numerisch oder textuell dar. Dadurch bleiben Muster verborgen, die Visualisierungen sichtbar machen könnten, und die kognitive Belastung für den Betrachter steigt.

Der nächste Schritt, die Ansichtstransformation, erlaubt es, visualisierte Daten interaktiv zu erkunden und unterschiedliche Perspektiven oder Detailstufen einzunehmen. Tabellen bieten diese Möglichkeit nur sehr eingeschränkt, da ihnen wesentliche grafische Elemente und visuelle Flexibilität fehlen.

Die letzte Phase, die Interpretation, besteht darin, visuelle Muster zu interpretieren und aus visuellen Darstellungen umsetzbare Erkenntnisse abzuleiten. Tabellen behindern eine schnelle Interpretation, da sie eine individuelle Überprüfung der Werte erfordern, was in starkem Kontrast zu grafischen Visualisierungen steht, die Muster sofort erkennen lassen.

Tabellen visuell aufwerten

Es gibt verschiedene Methoden, um klassische Tabellen anzureichern und so einige der Vorteile, die sonst nur durch Visualisierungen verfügbar sind, in eine Tabelle zu integrieren.

In-Cell-Diagramme (Sparklines, Balken, Aufzählungszeichen)

Kleine Diagramme direkt in Tabellenzellen – sogenannte In-Cell-Visualisierungen – ergänzen tabellarische Daten um voraufmerksame Kodierungen wie Position oder Länge. Dadurch lassen sich Werte deutlich schneller vergleichen, ohne den Kontext der Tabelle zu verlassen. Die Idee knüpft an Cleveland & McGills (1985) Rangordnung visueller Kodierungen sowie Tufte’s (2006) Konzept der „wortgroßen Grafiken“ an. Ein bekanntes Beispiel ist Rao & Card’s Table Lens (1994), das Tabellen mit In-Cell-Balken erweitert und so verborgene Muster sichtbar macht.

Visuelle Hervorhebungen mit Farben

Selektive Farbhervorhebungen reduzieren die Suchzeit in Tabellen. Wu & Yuan (2003) zeigten, dass Farbe die effektivste Hervorhebungsmethode für die Tabellensuche ist. Die Gestaltung der Farbpalette ist jedoch wichtig: Molina López et al. (2023) fanden heraus, dass Wahrnehmungsunterschiede bei Heatmap-Farbschemata die Genauigkeit und Geschwindigkeit stark beeinflussen.

Symbole und Piktogramme für (ISOTYPE-Stil)

Kleine, aussagekräftige Symbole können das Arbeitsgedächtnis und das Erinnerungsvermögen unterstützen, ohne die Genauigkeit zu beeinträchtigen. Bateman et al. (2010) und Borkin et al. (2013) zeigen, dass erkennbare bildliche Verzierungen die Einprägsamkeit von Diagrammen verbessern, was sich bei sparsamer Verwendung auch auf Tabellen ausweiten lässt.

Neuanordnung von Zeilen und Spalten

Durch einfaches Neuanordnen von Zeilen und Spalten, um ähnliche Werte zu gruppieren (oder nach einer Schlüsselkennzahl zu sortieren), werden Strukturen sichtbar. Behrisch et al. (2016) haben gezeigt, dass die Neuanordnung von Matrizen die Wahrnehmung von Mustern in Tabellen- und Netzwerkdaten verbessert.

Table Lens Interaktionen

Die Table Lens (Rao & Card, 1994) erweitert klassische Tabellen, indem sie kleine Balken direkt in die Zellen integriert. Ergänzt durch ein „Fischaugenobjektiv“ bleiben die Beschriftungen auch bei großen Datenmengen gut lesbar, während gleichzeitig globale Muster sichtbar werden. So lassen sich Ausreißer und Strukturen schneller erkennen. Um den Kontext zusätzlich zu stärken, können Zeilen sortiert oder gruppiert und mit passenden Überschriften versehen werden.

Beschriftungen und Farbkombinationen

Wenn Tabellen mit Text gepaart werden, verbessern Beschriftungen (nicht nur Farben) das Lernen. Clinton et al. (2016) fanden heraus, dass Beschriftungen bei Wahrscheinlichkeitstabellen effektiver waren als reine Farbakzentuierungen, wobei die besten Ergebnisse durch die Kombination beider Elemente erzielt wurden.

Design für Wahrnehmungseffizienz und Barrierefreiheit

Studien zeigen, dass visuelle Kodierungen wie Position und Länge deutlich präziser wahrgenommen werden als Fläche oder Winkel (Cleveland & McGill, 1985). Bei Heatmaps oder farbiger Schattierung ist zudem entscheidend, barrierefreie Farbpaletten zu verwenden und die Darstellungen auf Farbsehschwächen zu testen (Molina López et al., 2023).

Beispiele für gute Tabellen

Um zu zeigen, wie die vorgestellten Best Practices Tabellen in der Praxis verbessern, haben wir zwei Beispiele ausgewählt, die wir bei [at] in Kundenprojekten entwickelt haben (vgl. Abbildung 3). Die hintere Tabelle ist eher klassisch aufgebaut. Hier haben wir besonders auf die anfängliche Spaltenreihenfolge sowie auf Interaktionsmöglichkeiten wie das Ein- und Ausblenden von Spalten und das Anpassen der Spaltenbreite geachtet. Außerdem haben wir mit Icons gearbeitet. Besonders hervorgehoben sind die runden Symbole, die den Arbeitsfortschritt darstellen: Ein dünner schwarzer Kreis steht für eine noch nicht begonnene Aufgabe, und je weiter die Aufgabe in Prozent voranschreitet, desto stärker füllt sich der äußere blaue Kreis. Der Vorteil dieses Icons liegt darin, dass keine Zahlen gelesen und mental verarbeitet werden müssen. Auf einen Blick wird sofort deutlich, dass die ersten beiden Aufgaben bei 25 Prozent Fortschritt liegen und die dritte Aufgabe bei 50 Prozent.

Die vordere Tabelle arbeitet ebenfalls mit Icons. Sie ist jedoch vor allem durch die Gruppierung und Anordnung der Spalten geprägt. Die Gruppierung der Spalten über schwarze und weiße Überschriften bildet einen Workflow ab, den der Dashboard-Nutzer Schritt für Schritt durchlaufen soll. Durch diese visuellen Hinweise besteht keine Gefahr mehr, dass Informationen den falschen Prozessschritten zugeordnet oder der eigene Fortschritt falsch eingeschätzt wird. Ein kleines Liniendiagramm ergänzt die Tabelle zusätzlich und erhöht die Einprägsamkeit der dargestellten Informationen. Darüber hinaus ermöglicht es den Nutzern, bereits in der Tabelle zeitliche Muster zu erkennen. Das ist etwas, das in einer klassischen Datentabelle nicht möglich wäre.

Fazit

Tabellen sind grundlegende Werkzeuge zur Speicherung und Darstellung von Daten, unterscheiden sich jedoch klar von Visualisierungen. Ihnen fehlt die visuelle Kodierung und Interaktivität, die Stuart Cards Visualisierungspipeline als zentral herausstellt (Card, Mackinlay & Shneiderman, 1999). Visualisierungen übersetzen Daten in intuitive, leicht erfassbare Einsichten – etwas, das klassische Tabellen allein nicht leisten können.

Quellen

- Card, S. K., Mackinlay, J. D., & Shneiderman, B. (1999). Readings in Information Visualization: Using Vision to Think. Morgan Kaufmann.

- Few, S. (2009). Now You See It: Simple Visualization Techniques for Quantitative Analysis. Analytics Press.

- Tufte, E. R. (2001). The Visual Display of Quantitative Information (2nd ed.). Graphics Press.

- Ware, C. (2012). Information Visualization: Perception for Design (3rd ed.). Morgan Kaufmann.

- Bateman, S. et al. (2010). Useful Junk? The Effects of Visual Embellishment on Comprehension and Memorability of Charts.

- Behrisch, M. et al. (2016). Matrix Reordering Methods for Table and Network Visualization.

- Borkin, M. A. et al. (2013). What Makes a Visualization Memorable?

- Card, S. K., Mackinlay, J. D., & Shneiderman, B. (1999). Readings in Information Visualization: Using Vision to Think.

- Cleveland, W. S., & McGill, R. (1985). Graphical Perception and Graphical Methods for Analyzing Scientific Data.

- Clinton, V. et al. (2016). Color Coding and Labeling Learning about Probability from a Table and Text.

- Molina López, E. et al. (2023). Effect of color palettes in heatmaps perception.

- Rao, R. & Card, S. K. (1994). The Table Lens: Merging Graphical and Symbolic Representations in an Interactive Focus+Context Visualization for Tabular Information.

- Tufte, E. R. (2006). Beautiful Evidence.

- Wu, J.-H. & Yuan, Y. (2003). Improving searching and reading performance: the effect of highlighting and text color coding.

- F. J. Anscombe: Graphs in Statistical Analysis. In: American Statistician. 27, Nr. 1, 1973, S. 17–21

- Same Stats, Different Graphs: Generating Datasets with Varied Appearance and Identical Statistics through Simulated Annealing, Justin Matejka, George Fitzmaurice, ACM SIGCHI Conference on Human Factors in Computing Systems 2017

- H. Chen, U. Soni, Y. Lu, V. Huroyan, R. Maciejewski and S. Kobourov, "Same Stats, Different Graphs: Exploring the Space of Graphs in Terms of Graph Properties," in IEEE Transactions on Visualization and Computer Graphics, vol. 27, no. 3, pp. 2056-2072, 1 March 2021, DOI: 10.1109/TVCG.2019.2946558.

Diesen Beitrag teilen: