Von RAG zu GraphRAG

Der nächste Schritt für intelligente Wissensabfrage

- Veröffentlicht:

- Autor: Lenny Julien Klump

- Kategorie: Deep Dive

Inhaltsverzeichnis

![Von RAG zu GraphRaG Von RAG zu GraphRaG: Der nächste Schritt für intelligente Wissensabfrage, Deep Dive, Lenny Julien Klump, Alexander Thamm [at]](/fileadmin/_processed_/1/b/csm_von-rag-zu-graphrag-lenny-klump-alexander-thamm-at_f1d1715228.jpg)

GraphRAG ist eine Weiterentwicklung klassischer RAG-Ansätze und nutzt strukturierte Wissensgraphen anstelle isolierter Textabschnitte. So können Sprachmodelle nicht nur Informationen finden, sondern auch Zusammenhänge zwischen Begriffen und Themen erkennen. Dies führt zu fundierteren, kontextbezogenen und nachvollziehbaren Antworten. Für Unternehmen bietet GraphRAG damit einen vielversprechenden Ansatz, um komplexe Fragen effizient und skalierbar zu beantworten.

Was ist Retrieval-Augmented Generation?

Im Jahr 2022 erreichte ChatGPT in kürzester Zeit enorme Popularität: Fünf Tage nach Veröffentlichung zählte die Anwendung bereits über eine Million Nutzer und machte Large Language Models (LLMs) erstmals dem Mainstream bekannt. Heute sind LLMs weit verbreitet, und viele Unternehmen haben das Potenzial dieser Technologie schnell erkannt.

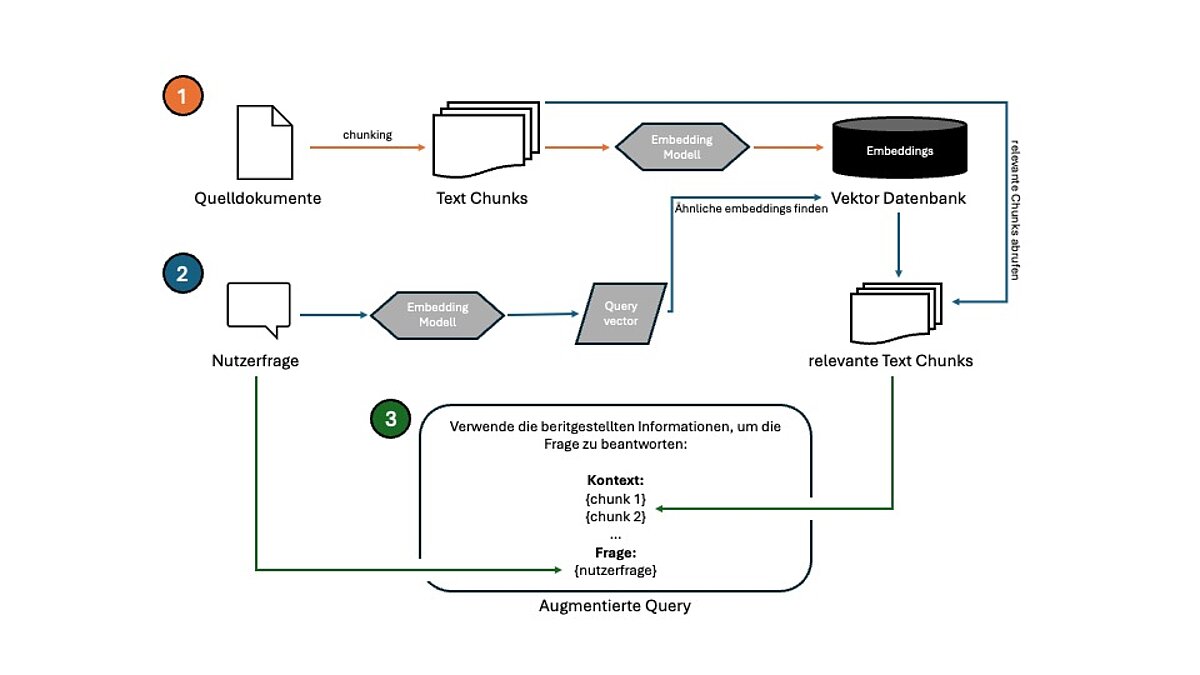

Klassische LLMs besitzen allerdings eine entscheidende Einschränkung für den Unternehmenseinsatz: Sie verfügen nicht über internes oder domänenspezifisches Wissen, das sich üblicherweise nur in unternehmenseigenen Dokumenten und Datenbanken befindet. Retrieval-Augmented Generation (RAG) wurde entwickelt, um diese Lücke zu schließen und ist bereits in verschiedensten Branchen und Anwendungsfällen erfolgreich im Einsatz. RAG erweitert LLMs, indem gezielter Kontext aus Wissensbasen bereitgestellt wird. Das klassische, vektorbasierte RAG funktioniert in drei wesentlichen Schritten:

- Vorbereitung (einmalig): Dokumente werden zunächst in kleine, verarbeitbare Textabschnitte (Chunks) aufgeteilt. Diese Chunks werden anschließend in numerische Vektoren (Embeddings) umgewandelt und in einer Vektordatenbank gespeichert.

- Retrieval (Abruf): Wenn ein Benutzer eine Anfrage an das System stellt, wird diese ebenfalls in eine numerische Darstellung umgewandelt. So können semantische Ähnlichkeiten zwischen der Anfrage und den Textabschnitten berechnet werden. Relevante Textstücke, die thematisch eng mit der Benutzeranfrage verknüpft sind, werden dann aus der Vektordatenbank abgerufen.

- Generierung: Die gefundenen Textabschnitte (oder der gesamte logische Abschnitt, aus dem diese stammen) dienen dem LLM als zusätzlicher Kontext. Geleitet von einem Prompt, synthetisiert das Modell diese Kontexte, um eine präzise, wissensbasierte Antwort zu erzeugen.

Die beschriebenen Schritte sind in Abbildung 1 visualisiert.

Wo stößt RAG an seine Grenzen?

Moderne RAG-Systeme haben den schnellen Zugang zu Wissen grundlegend verändert und funktionieren in bestimmten Anwendungsbereichen bereits sehr gut. In komplexeren Umgebungen, wie beispielsweise bei verteiltem Wissen, mehrschichtigen Anfragen oder wachsendem Datenvolumen, stößt dieser Ansatz jedoch an seine Grenzen. Zu den Schwächen des klassischen RAG-Ansatzes zählen unter anderem:

- Kein tiefgehendes Verständnis: Vektorbasierte RAG-Systeme finden Text hauptsächlich anhand der Übereinstimmung mit der Nutzerfrage. Das kann dazu führen, dass Informationen übersehen werden, zum Beispiel, wenn das gleiche Konzept anders formuliert wurde, Bedeutungen implizit sind oder Hierarchien eine Rolle spielen. Diese Einschränkung ergibt sich aus der Tatsache, dass vektorbasiertes RAG, Dokumente als unstrukturierten Text behandelt, ohne sich der Beziehungen oder des Gesamtkontexts bewusst zu sein.

- Fragmentierte Informationen: Die semantisch passenden Chunks werden unabhängig voneinander abgerufen, oft aus verschiedenen Quellen. Dies kann zu fragmentierten und/oder widersprüchlichen Antworten führen.

- Schwaches globales Reasoning: RAG ist für globale Abfragen wie „Was sind die Hauptthemen in diesem Datensatz?“ nicht gut geeignet. Dies liegt daran, dass das System auf spezifische Textabschnitte angewiesen ist und keine kohärente globale Repräsentation der Daten erzeugt.

- Herausforderungen bei der Skalierbarkeit: Wenn die Menge der Informationen in der Vektordatenbank wächst, kann RAG relevante Informationen übersehen, da es nur eine feste Anzahl der „besten“ Ergebnissen abruft. Außerdem verfügen die meisten RAG-Systeme über keinen effizienten Mechanismus zur strukturierten Indizierung.

Was ist GraphRAG und wie adressiert es die Schwächen von RAG?

GraphRAG wurde von Microsoft Research in dem Artikel „From Local to Global: A GraphRAG Approach to Query-Focused Summarization“ (2024) vorgestellt und beschreibt einen weiterentwickelten Retrieval-Ansatz, der die Schwächen der oben genannten traditionellen Methode gezielt adressiert.

Vektorbasierte RAG-Systeme funktionieren vor allem bei strukturierten FAQs oder hierarchielosen Dokumenten gut. Die Stärke von GraphRAG liegt allerdings darin, globale Suchen wie „Was sind die wichtigsten Informationen zu Thema X?“ zu beantworten und vor allem narrative oder zusammenhängende Daten zu interpretieren. Das wird dadurch möglich, dass zentrale Entitäten und ihre Beziehungen zueinander explizit modelliert werden.

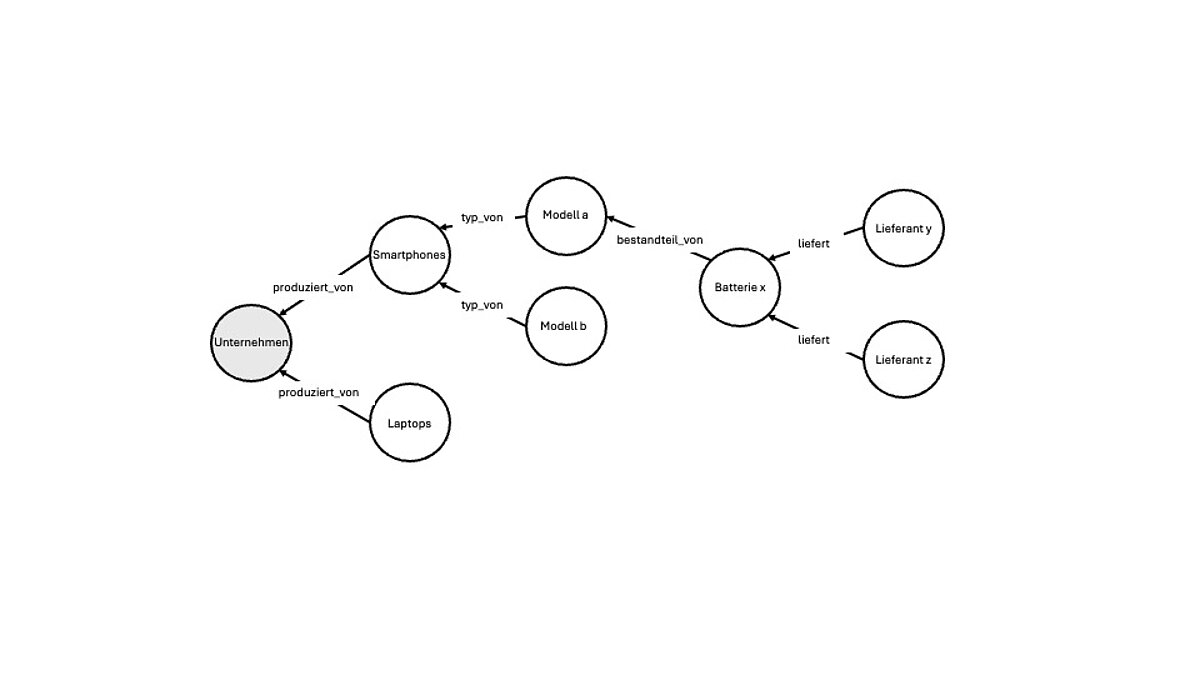

Das Kernkonzept von GraphRAG besteht darin, die Fähigkeiten von Graphen G = (V, E) zu nutzen. Diese bestehen aus Knoten (Vertices/Nodes) V, die über (gewichtete/gerichtete) Kanten (Edges) E miteinander verbunden sind. In GraphRAG repräsentieren Knoten die Entitäten und Kanten deren Beziehungen. Für ein Technologieunternehmen könnte ein solcher Graph beispielsweise so aussehen:

GraphRAG wurde entwickelt, um Schlussfolgerungen über miteinander verbundene Datenpunkte zu ziehen. Das folgende Beispiel veranschaulicht den Unterschied zu herkömmlichen RAG und basiert auf dem fiktiven Unternehmen, das in Abbildung 1 dargestellt ist.

Szenario: Ein Tech-Unternehmen untersucht inkonsistente Akkulaufzeiten bei einem Smartphone-Modell.

Ein traditionelles RAG-System würde in diesem Fall Dokumente wie Support-Tickets, einen FAQ-Eintrag zur Akkuleistung und eine Lieferantenrechnung abrufen. Obwohl jedes dieser Dokumente für sich genommen, relevant und thematisch passend ist, bleiben sie isoliert. Das System erkennt keine inhaltlichen Zusammenhänge, was die Ursachenanalyse erschwert.

GraphRAG hingegen strukturiert dieselben Informationen in Form eines Wissensgraphen, also einer Darstellung, die Entitäten und deren Beziehungen zueinander abbildet. Produkte, Komponenten, Lieferanten oder Händler werden dabei als Knoten erfasst, verbunden durch Relationen wie „hergestellt von“ oder „gehört zu“ (siehe Abbildung 1).

Bei einer entsprechenden Anfrage kann GraphRAG die Beziehungen gezielt analysieren und verknüpfen, mit dem beispielhaften Ergebnis, dass alle betroffenen Geräte denselben Batterietyp von Lieferant Y enthalten. So entsteht ein klarer, nachvollziehbarer Hinweis auf eine mögliche Ursache des Problems.

Wie funktioniert die GraphRAG Pipeline?

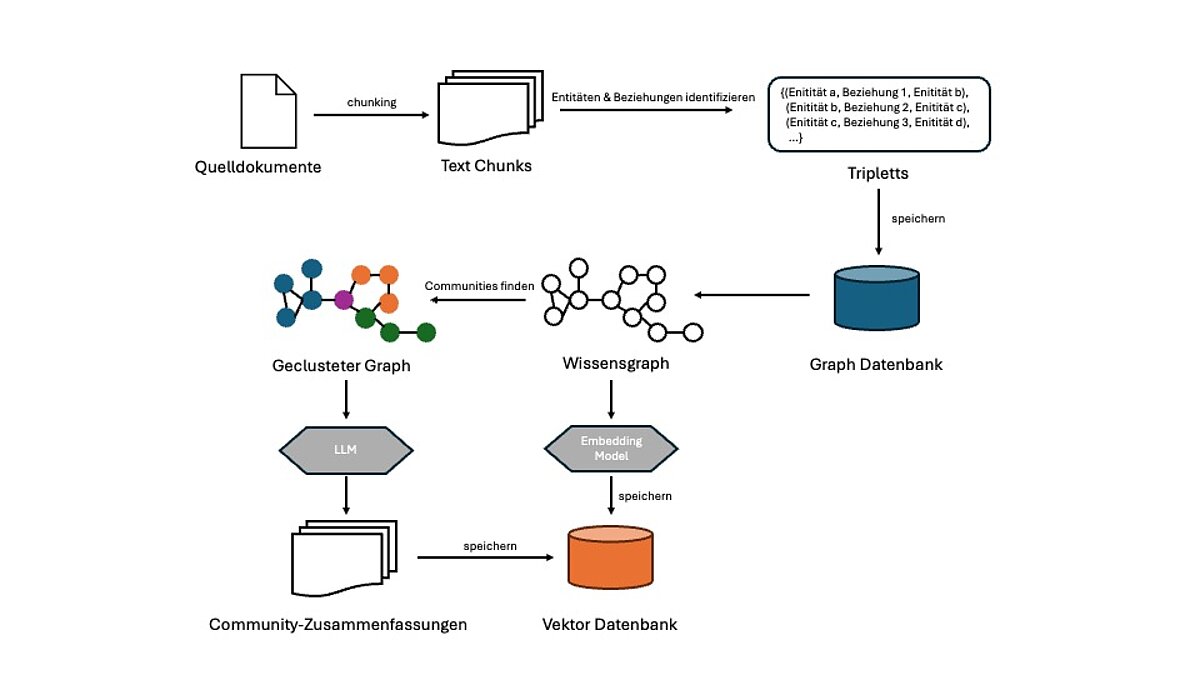

Text Chunking

Wie beim klassischen RAG besteht der erste Schritt bei GraphRAG darin, große Textdokumente in kleinere, verarbeitbare Stücke aufzuteilen. Diese Textabschnitte können Sätze, Absätze oder andere logische Einheiten sein.

Extrahieren von Entitäten und Beziehungen

Im nächsten Schritt werden relevante Entitäten (z.B. Abteilungen, Lieferanten, Produkte) und deren Beziehungen (z.B. „Produkt A wird von Lieferant B produziert“) identifiziert und extrahiert.

Dies erfolgte früher über klassische NLP-Techniken wie Named Entity Recognition (NER) und Relation Extraction. Mittlerweile werden LLMs ausreichend leistungsfähig, diese Aufgabe direkt über passende Prompts und Output-Schemas zu lösen. Neue Tools und Libraries wie der LLMGraphTransformervon LangChain vereinfachen diesen Prozess zusätzlich und machen die Extraktion strukturierter Wissensgraphen deutlich effizienter.

Die extrahierten Ergebnisse können dann in Tripletts G = {(h, r, t)} organisiert werden, bestehend aus Head-Entity, Relation und Tail-Entity z. B. (Berlin, Hauptstadt von, Deutschland).

Graph-Konstruktion und Speicherung

Die extrahierten Triplets lassen sich anschließend in einem Wissensgraphen abbilden: Entitäten werden dabei als Knoten dargestellt, die über Kanten miteinander verbunden sind. Diese Kanten repräsentieren die jeweiligen Beziehungen.

Zur Speicherung, Visualisierung und effizienten Abfrage solcher Graphstrukturen kommen spezialisierte Graphdatenbanken wie Neo4j, Amazon Neptune oder Memgraph zum Einsatz.

Optional: Node Embeddings

Semantic Search ermöglicht den Abruf von Inhalten auf der Grundlage ihrer Bedeutung, anstatt sich auf die exakte Übereinstimmung von Schlüsselwörtern zu verlassen, wie dies bei Abfragen von Graph Datenbanken üblich ist. Dadurch kann das System inhaltlich verwandte Ergebnisse finden, auch wenn der Wortlaut abweicht. So kann beispielsweise eine Abfrage wie „Wer stellt die Batterie in Modell A her?“ auch dann das richtige Ergebnis liefern, wenn der Graph nur das Triplett (Lieferant Y, liefert, Batterie X) enthält.

Um solch eine Suchfunktionen zu ermöglichen, können Graphenknoten mit Modellen wie Node2Vec oder GraphSAGE als Vektoren kodiert (embedded) werden.

Zwar nutzt das traditionelle RAG auch embeddings, um eine semantische Suche über Textabschnitte zu ermöglichen, jedoch fehlt hier das Verständnis für die Zusammenhänge zwischen einzelnen Konzepten.

GraphRAG ermöglicht dies, indem die verwendeten Embeddingmodelle nicht nur die textuellen Eigenschaften der Knoten erfassen, sondern auch die Beziehungen und Inhalte zu benachbarten Knoten im Graphen (struktureller Kontext).

Optional: Erkennung von „Communities“ und Zusammenfassung

Um die Suchqualität weiter zu verbessern und einen noch reichhaltigeren Kontext bereitzustellen, können Clustering-Methoden wie der Leiden-Algorithmus eingesetzt werden. Diese Verfahren identifizieren eng miteinander verbundene Knotengruppen, sogenannte Communities, die häufig Subthemen im Wissensgraphen repräsentieren (z. B. eine bestimmte Abteilung).

Nach der Identifikation solcher Communities kann ein LLM dazu verwendet werden, prägnante Zusammenfassungen zu generieren, die zentrale Entitäten, Beziehungen und weitere relevante Informationen innerhalb der jeweiligen Cluster enthalten. Die erstellten Zusammenfassungen können dann auch für die semantische Suche embedded und/oder als Nachschlagetabelle mit IDs in Knotenattributen gespeichert werden.

Informationsabruf durch Graph-Traversal

Sobald der Wissensgraph erstellt und in einer Datenbank abgelegt wurde, ist das System bereit, Benutzeranfragen zu beantworten. Dabei erfolgt der Abruf relevanter Informationen in mehreren Schritten:

- Identifizierung von Entitäten in der Anfrage: Zunächst identifiziert das System die Entitäten, die in der Anfrage des Benutzers erwähnt werden, z. B. „Was sind die Features von Modell a?“ In diesem Fall ist die Entität Modell a.

- Semantische Suche: Wenn die Knoten des Graphen in einen Vektorraum embedded wurden, kann das System auch bei abweichender Formulierung relevante Entitäten oder Zusammenfassungen abrufen.

- Graphentraversal (lokale Suche): Bei gezielten Anfragen startet das System bei der gefundenen Entität und durchläuft den Graphen, um mehrere benachbarte Knoten und deren Beziehungen zu sammeln.

- Community-Zusammenfassungen (globale Suche): Bei weiter gefassten Fragen wie „Was ist die Struktur der Marketingabteilung?“ nutzt das System die vorgenerierte Zusammenfassung der entsprechenden Community, um fundierte Antworten zu liefern.

- Kontext-Aggregation und Ranking: Alle abgerufenen Informationen wie Fakten, Pfade im Graphen, Zusammenfassungen usw. werden auf ihre Relevanz bewertet, und nur die wesentlichsten Inhalte werden dann zur Generierung einer Antwort an das LLM zurückgegeben.

Antwortgenerierung

Schließlich werden die Informationen zusammen mit der ursprünglichen Benutzerfrage an das LLM übergeben. Das Modell generiert basierend darauf eine fundierte, kontextualisierte und informierte Antwort.

Ein beispielhafter Workflow ist in Abbildung 3 dargestellt, wobei Abweichungen davon möglich sind. So können zum Beispiel Node-Embeddings oder die Zusammenfassungen der Communitys direkt als Knotenattribute in der Graphdatenbank gespeichert werden. Manche Systeme verzichten auch ganz auf Embeddings und arbeiten stattdessen ausschließlich mit der Struktur des Graphen, etwa durch das Durchlaufen von Knoten (Graph Traversal), das Filtern auf Basis eines Schemas oder mit vordefinierten Abfragepfaden, die speziell auf domänenspezifische Zusammenhänge zugeschnitten sind.

Wie profitieren Unternehmen durch GraphRAG?

GraphRAG kombiniert die Stärken von LLMs und Wissensgraphen, um besonders bei komplexen, vielschichtigen Fragestellungen deutlich präzisere und umfassendere Antworten zu liefern. Im Unternehmenskontext ergeben sich daraus folgende konkrete Vorteile.

Entscheidungen können leichter und auf einer fundierteren Grundlage getroffen werden, da die bereitgestellten Informationen sowohl inhaltlich korrekt als auch kontextuell nachvollziehbar sind.

Darüber hinaus trägt die Fähigkeit, auch anspruchsvolle Anfragen präzise zu beantworten, zur höheren Kundenzufriedenheit bei und stärkt das Vertrauen in KI-gestützte Systeme.

Ein weiterer wesentlicher Vorteil von GraphRAG liegt in der Nachvollziehbarkeit: Da die Informationen strukturiert über den Wissensgraphen abgerufen werden, lässt sich der Weg zur Antwort transparent nachvollziehen. Diese Erklärbarkeit ist besonders relevant für die Einhaltung, regulatorische Anforderungen und Compliance-Vorgaben.

Neben Genauigkeit und Transparenz bietet GraphRAG auch hervorragende Skalierbarkeit. Graphen lassen sich effizient indexieren und organisieren, auch bei wachsenden Datenmengen. In klassischen RAG-Systemen die Präzision mit zunehmender Datenmenge oft ab, GraphRAG reduziert die Menge irrelevanter Ergebnisse durch gezielte Abfragen im Graphen und senkt so den Ressourcenverbrauch. Das bedeutet für Unternehmen: geringere Betriebskosten durch effizientere Datenverarbeitung und geringeren Rechenaufwand.

Wo kann GraphRAG effektiv eingesetzt werden?

Während der klassische RAG-Ansatz gut für die Beantwortung von Fragen auf Basis hierarchieloser Dokumente geeignet ist, wurdeGraphRAG speziell für komplexere Datenlandschaften konzipiert. Zum Beispiel Umgebungen mit stark vernetzten Informationen, die aus verteilten Datenquellen stammen.

Durch die Integration von Wissensgraphen ist das System in der Lage, Zusammenhänge zu erkennen und fundierte Schlussfolgerungen über verknüpfte Inhalte zu ziehen. Damit eignet sich GraphRAG besonders für Anwendungsfälle, in denen Nachvollziehbarkeit und ein bewusstesVerständnis von Beziehungen zwischen Informationen von zentraler Bedeutung sind. Typische Anwendungsbeispiele aus verschiedenen Branchen sind:

- Finanzdienstleistungen:Konten, Banken und Personen können als Entitäten modelliert werden, die über Beziehungen, wie besitzt oder überweist, als Kanten miteinander verbunden sind. GraphRAG kann relevante Teile des Netzwerks analysieren, zusammenfassen und interpretieren, um z. B. bei Fraud Prevention oder Risikoanalysen zu unterstützen.

- Fertigung:Ursachenanalyse und Wartungsplanung können mit relevanten Erkenntnissen aus verteilten Quellen wie Lieferantenprotokollen, Wartungsaufzeichnungen oder Systemabhängigkeiten unterstützt werden.

- Wissensmanagement im Unternehmen: Interne Assets wie Dokumente, Präsentationen und Code können nach Thema, Abteilung oder Projekt in einem Graphen organisiert werden. GraphRAG ermöglicht dann präzise, kontextbezogene Einblicke über Silos hinweg.

- Gesundheitswesen: Die Verknüpfung von Patientendaten wie Symptomen, Laborergebnissen und Anamnese mit relevanten Forschungsergebnissen und klinischen Richtlinien ermöglicht das Abfragen von vertrauenswürdigem Kontext, zur fundierten Unterstützung bei Diagnosen.

Wo liegen die Herausforderungen für eine erfolgreiche GraphRAG Implementierung?

Die Implementierung von GraphRAG im Unternehmen kann zahlreiche Vorteile mit sich bringen, darunter ein tieferes kontextuelles Verständnis, eine höhere Präzision beim Informationsabruf sowie mehr Transparenz in Entscheidungsprozessen.

Allerdings können bei der Umsetzung auch bestimmte Herausforderungen auftreten, die es zu berücksichtigen gilt:

Graph Aufbau und Wartung

Die Leistung des Systems hängt in hohem Maße von der Qualität und Konsistenz des erstellten Wissensgraphen ab. Unternehmen verfügen in der Regel über unterschiedlichste Datenquellen (Dokumente, Präsentationen, Datenbanken, Lieferantenprotokolle, Support-Tickets, ...). Die Integration all dieser Quellen in einen kohärenten Wissensgraphen kann eine komplexe Aufgabe sein, die eine umfangreiche Datenbereinigung, -umwandlung und -standardisierung erfordert.

Außerdem ist es entscheidend, den Graphen auf dem neuesten Stand zu halten. Neue Daten müssen ordnungsgemäß integriert werden, und bestehende Beziehungen sollten bei der Weiterentwicklung des Systems korrekt bleiben. Ohne kontinuierliche Kontrolle und Wartung kann der Graph schnell veraltet sein, was die Qualität der Ergebnisse beeinträchtigt.

Leistung und Skalierbarkeit

Mit wachsendem Datenvolumen im Wissensgraphen kann die Abfrageleistung zunehmend beeinträchtigt werden. Grund dafür ist, dass Traversierungen durch ein komplexes Netz in Echtzeit zu spürbaren Latenzen führen können.

Um eine hohe Systemleistung sicherzustellen, ist daher eine sorgfältige Gestaltung von Schemas und Indizierungsstrategien notwendig.

Ein vielversprechender Ansatz zur Optimierung besteht zudem in hybriden Architekturen, die Graph-Traversierung mit Vektorsuche kombinieren. Dadurch lassen sich präzise Ergebnisse mit einer schnellen Antwortzeit vereinigen.

Sicherheit und Compliance

Wie jedes System im Unternehmenskontext muss auch GraphRAG strenge Sicherheits- und Compliance-Anforderungen erfüllen.

Abhängig vom Anwendungsfall können im Graphen Personen mit Transaktionen, Gesundheitsdaten oder anderen sensiblen Informationen verknüpft werden. Dadurch besteht die Möglichkeit, implizite Zusammenhänge sichtbar zu machen, die zuvor nicht offengelegt wurden.

Dies erfordert eine strenge Zugangskontrolle sowie datenschutzkonforme Prozesse bei der Erfassung, Verarbeitung und Abfrage der Daten.

Erfordernis von Fachwissen

Die erfolgreiche Implementierung eines GraphRAG-Systems erfordert ein Team mit Fachwissen in verschiedenen Disziplinen: NLP, Graphmodellierung, Prompt-Engineering, Software-Engineering und Datenbankmanagement.

Als führendes Daten- und KI-Beratungsunternehmen bündelt [at] dieses Fachwissen und unterstützt Unternehmen aktiv bei der Entwicklung und dem Einsatz maßgeschneiderter Lösungen von der Frühphase der Strategie bis zur produktionsreifen Implementierung.

Warum ist GraphRAG der nächste Schritt für intelligente Wissensabfrage?

Da Unternehmen zunehmend versuchen, den Wert ihrer Daten besser zu nutzen, hat Microsoft ResearchmitGraphRAG ein innovatives Framework vorgestellt, das die Fähigkeiten von Large Language Models (LLMs) hin zu echtem kontextuellen Reasoning erweitert.

Der klassische, vektorbasierte RAG-Ansatz verbessert bereits die Leistungsfähigkeit von LLMs, indem er externes oder unternehmensspezifisches Wissen zugänglich macht und so quellengestützte Antworten auch in regulierten Umgebungen ermöglicht.

GraphRAG baut auf diesem Prinzip auf, wurde jedoch speziell für Umgebungen entwickelt, in denen Beziehungen zwischen Entitäten, Kontextverständnis und Transparenz eine zentrale Rolle spielen. Wissen wird in einem Graphen strukturiert, wodurch LLMs vernetzte Entitäten „verstehen“ und damit präzisere, kontextualisierte und erklärbare Ergebnisse liefern können.

Mit wachsender Reife der Technologie werden heutige Limitierungen wie die aufwendige Erstellung von Graphen zunehmend reduziert. Der LLMGraphTransformer von LangChain ist ein Beispiel für diese Entwicklung. Zusätzlich bieten agentische KI-Systeme Potenzial, Aufgaben wie die Datenverarbeitung oder die Aktualisierung des Graphen zu automatisieren oder stark zu vereinfachen.

Seit der ersten Veröffentlichung von GraphRAG gab es rasante Fortschritte in der Forschung: Neue Modelle wie LightRAG, PathRAG, PolyG und E2GraphRAG wurden in den letzten Monaten vorgestellt. All diese Ansätze nutzen Graphstrukturen auf unterschiedliche Weise, und bieten jeweils spezifische Vorteile wie dynamische Updates, Token-Effizienz, schnellere Retrievals oder bessere Skalierbarkeit.

Die Verbindung von LLMs mit in Graphen strukturierten Wissen bietet einzigartige Vorteile und ist der nächste logische Schritt für moderne Wissensabfrage im Unternehmenskontext. GraphRAG eröffnet Unternehmen neue Möglichkeiten, Wissen gezielt, nachvollziehbar und effizient zu nutzen.

Sind Sie daran interessiert zu erfahren, ob Ihr Unternehmen für GraphRAG bereit ist und wie es davon profitieren kann? Kontaktieren Sie uns noch heute für eine unverbindliche Beratung!

Quellen

Papers:

From Local to Global: A Graph RAG Approach to Query-Focused Summarization (https://arxiv.org/abs/2404.16130)

LightRAG: Simple and Fast Retrieval-Augmented Generation (https://arxiv.org/abs/2410.05779)

PathRAG: Pruning Graph-based Retrieval Augmented Generation with Relational Paths (https://arxiv.org/abs/2502.14902)

PolyG: Effective and Efficient GraphRAG with Adaptive Graph Traversal (https://arxiv.org/abs/2504.02112)

E2GraphRAG: Streamlining Graph-based RAG for High Efficiency and Effectiveness (https://arxiv.org/html/2505.24226v1)

Anwendungsbeispiele:

https://python.langchain.com/docs/how_to/graph_constructing/

https://python.langchain.com/docs/integrations/retrievers/graph_rag/

https://neo4j.com/docs/neo4j-graphrag-python/current/user_guide_rag.html#graphrag-configuration

https://github.com/microsoft/graphrag/blob/main/RAI_TRANSPARENCY.md#what-is-graphrag

Blogs:

https://www.chitika.com/uses-of-graph-rag/

https://memgraph.com/docs/deployment/workloads/memgraph-in-graphrag

https://atos.net/en/blog/graphrag-transforming-business-intelligence-retrieval-augmented-generation

https://machinelearningmastery.com/building-graph-rag-system-step-by-step-approach/

Videos:

GraphRAG Explained: AI Retrieval with Knowledge Graphs & Cypher: https://www.youtube.com/watch?v=Za7aG-ooGLQ

Graph RAG Evolved: PathRAG (Relational Reasoning Paths) https://www.youtube.com/watch?v=oetP9uksUwM

Graph RAG: Improving RAG with Knowledge Graphs: https://www.youtube.com/watch?v=vX3A96_F3FU

Diesen Beitrag teilen: