Zunächst klingt es trivial, wenn betont wird, dass eine gute Datenqualität entscheidend für Unternehmen und Organisationen ist. Einerseits kann dadurch die Zuverlässigkeit von Prozessen gewährleistet werden. Andererseits können Fehler in den Datenbeständen tatsächlich unter Umständen enorme finanzielle Folgekosten nach sich ziehen.

Ganz unabhängig davon führt eine schlechte Datenqualität dazu, dass Daten die Realität nicht mehr korrekt abbilden können und dadurch ihren Wert verlieren. Nur wenn eine optimale Datenqualität sichergestellt ist, können Modelle zutreffende Aussagen über bestimmte Gegebenheiten beispielsweise in der vernetzten Fabrik oder in anderen betrieblichen Bereichen treffen.

Lesetipp: Lesen Sie in folgendem Artikel, wie jede Fabrik ein Teil der Industrie 4.0 werden kann.

Inhaltsverzeichnis

Definition von Datenqualität und warum sie wichtig ist

Für Entscheidungsträger ist Datenqualität wichtig, weil sie auf Basis von Datenanalysen Entscheidungen treffen oder Marktchancen bewerten. Datenqualität und Entscheidungsqualität stehen also in einem direkten Verhältnis. Die Datenqualität lässt sich folgendermaßen definieren: Datenqualität zeichnet sich dadurch aus, dass Daten den Zweck in einem bestimmten Zusammenhang erfüllen können müssen.

Dabei lassen sich fünf Hauptkriterien identifizieren, die im Zusammenspiel die Datenqualität sicherstellen: Korrektheit, Relevanz und Verlässlichkeit aller Daten, sowie ihre Konsistenz und zuletzt ihre Verfügbarkeit auf verschiedenen Systemen.

Neben dieser eher engen Definition, lassen sich eine ganze Reihe von Begriffen nennen, die ebenfalls die Datenqualität beeinflussen:

- Genauigkeit

- Vollständigkeit

- Aktualität

- Relevanz

- Zusatznutzen

- Konsistenz über mehrere Quellen hinweg

- Repräsentation

- Interpretierbarkeit

- Verständlichkeit

- Zugänglichkeit

- Zuverlässigkeit des Systems

Wir haben diese Vielfalt an Aspekten zu den 5 wichtigsten Maßnahmen gebündelt, die unserer Erfahrung nach zu einer besseren Datenqualität führen.

1. Datenkatalog einführen

Schon vor dem eigentlichen Prozess der Datenerfassung kann die Datenqualität sichergestellt werden. Durch die vorab konzeptionierte Definition eines Datenkatalogs von Eigenschaften – sogenannten Metadaten –, mit dem alle Datenobjekte ausgestattet werden. Dieser Datenkatalog ist ein wichtiges Mittel, um Daten später für die Analyse zu identifizieren und erfüllt zugleich den Zweck, Daten auf ihre Vollständigkeit und ihre Konsistenz sicherzustellen.

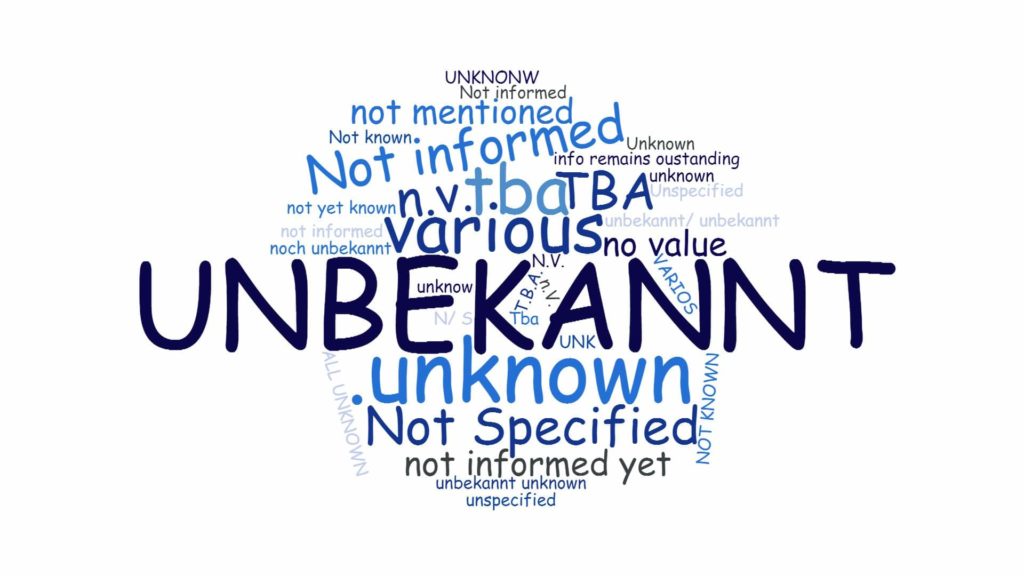

Der gesamte Datenbestand lässt sich auf diese Weise einheitlich strukturieren und sowohl von Redundanzen als auch von Dubletten schützen. Die folgende Abbildung zeigt die Visualisierung eines Datensatzes, der ohne Datenkatalog erstellt wurde. Alle Attribute, die nicht vorhanden waren, wurden im Datensatz mit den unterschiedlichsten Werten ausgefüllt wie „unbekannt“, „unknown“, „various“ oder „N/S“. In einem Datenkatalog wären für alle unbekannte Werte ein einheitlicher Wert wie beispielsweise „unbekannt“ verwendet worden.

2. Das First-Time-Right-Prinzip

Unverständliche, ungenaue oder unvollständige Eingaben sind eine Fehlerquelle, die sich schnell potenziert und deren Behebung sehr mühsam und aufwändig ist. Anstatt im Nachhinein Daten auf Korrektheit zu überprüfen, ist es darum ratsam, direkt bei der Erstellung bzw. Erhebung darauf zu achten, dass alle Daten korrekt sind. Diese Maßnahme nennt sich auch „First-Time-Right-Prinzip“. Direkt beim Data Entry bzw. der Dateneingabe muss auf Korrektheit geachtet und diese sichergestellt werden. In sensiblen Fällen lässt sich diese Regel durch das Vier-Augen-Prinzip ergänzen.

Das First-Time-Right-Prinzip betrifft alle Mitarbeiter, aber auch automatisch erhobene Datenerfassungssysteme, die falsch kalibriert sind oder aus anderen Gründen falsche Messwerte liefern. Überall wo Daten angelegt werden, müssen die zuständigen Personen darauf achten, dass Daten direkt beim ersten Mal korrekt gespeichert werden. Das Ziel des First-Time-Right-Prinzips ist es, die Aktualität, die Vollständigkeit und den Informationsumfang von Daten sicherzustellen.

3. Data Cleansing & Data Profiling

Auch von privaten Systemen kennt man das Phänomen: Datenmüll verlangsamt Systeme und Prozesse. Darum müssen Datenträger regelmäßig bereinigt werden. Dazu stehen eine Reihe von Anwendungen und Algorithmen zur Verfügung. Diese überprüfen Datentypen und konvertieren sie, erkennen und löschen Dubletten oder vervollständigen lückenhafte Daten. Data Cleansing wird aufgrund der großen Datenbestände kaum noch manuell gemacht – auch wenn dies in bestimmten Fällen immer wieder vorkommt.

Mit bereits vorhandenen Programmen und Algorithmen lässt sich die Bereinigung effizient durchführen. Im Rahmen des Data Profiling werden Daten systematisch nach Fehlern, Inkonsistenzen und Widersprüchen hin untersucht. Die Ziele von Data Cleansing und Data Profiling sind:

- Widersprüchlichkeiten innerhalb von Datenbeständen vermeiden

- Interpretierbarkeit der Daten erhalten

- Manipulationsgefahr der Daten verhindern

- Integrität der Daten sicherstellen

4. Datenqualitätsmanagement für permanenten Zugang zu Daten

Ein systematisches Datenqualitätsmanagement trägt dauerhaft dazu bei, eine hohe Datenqualität zu erhalten. Eine strategische Möglichkeit, die sich anbietet, um Datenqualitätsmanagement zu betreiben, ist: Data Governance. Es finden sich zahlreiche unterschiedliche Definitionen des Begriffs Data Governance.

Der für diesen Zusammenhang wichtige Aspekt ist, dass der Zugang zu allen relevanten Daten permanent sichergestellt werden muss. Dies gelingt durch die Klärung der Verantwortlichkeiten und die Vergabe von Zugriffsrechten, die überlegt und aktuell sein muss. Das Ziel von Datenqualitätsmanagement ist es, stets den Systemzugang sicherzustellen und auch die Systemsicherheit zu gewährleisten. Zum Datenqualitätsmanagement gehört darum auch die Integration aller Daten, sprich: der Abbau von Daten-Silos.

Lesetipp:Lesen Sie in unserem Grundlagenartikel, warum Data Analytics bzw. Data Science ein Schlüssel für die digitale Transformation ist.

5. Das Closed-Loop-Prinzip

Für eine optimale Datenqualität zu sorgen ist keine singuläre Herausforderung, sondern ein iterativer Prozess, der fest in Unternehmen und Organisationen verankert werden muss. Weil sich dieser Prozess immer wieder wiederholt, spricht man auch vom Closed-Loop-Prinzip, das ihm zugrunde liegt. Das Optimieren der Datenqualität ist darum ein dynamischer, kontinuierlicher Verbesserungsprozess, der in alle zentralen Geschäftsprozesse integriert werden sollte. Um eine gleichbleibend hohe Qualität sicherzustellen, empfiehlt es sich in regelmäßigen Abständen Schulungen und Workshops durchzuführen, um nachhaltig Erfolg sicherzustellen.

Auf dem Weg zu besseren Daten: Verantwortlichkeiten erkennen und zuordnen

Eine der entscheidenden Fragen, die zu einer besseren Datenqualität führen, ist: „Wer ist für die einzelnen Maßnahmen verantwortlich?“ Treiber für Datenqualität ist oft die IT-Compliance bzw. die Prozessintegration, weil gerade hier die Beachtung der bestehenden Gesetze wie dem Datenschutzrecht und das Einhalten von Standards relevant ist. Unternehmen, die eine „ganzheitliche“ Antwort auf die immer komplexer werdenden Herausforderungen suchen, können im Rahmen eines Data Custodianship auf allen Ebenen verschiedene Rollen definieren und die Verantwortlichkeiten eindeutig verteilen.

Dieser Schritt lohnt sich allein deswegen, weil die Ursachen für mangelnde Datenqualität neben den fehlenden Verantwortlichkeiten oft Fehleingaben oder doppelte Eingaben (Dubletten), regionale Interpretationsunterschiede oder redundante Informationen sind, also auf den unterschiedlichsten Ebenen passieren können.

Um Aufgaben klarer zu definieren, können Datenqualitätsinitiativen durchgeführt werden, in denen datenqualitätskritische Bereiche identifiziert und Datenqualitäts-Review-Prozesse definiert werden. Dieser Aufwand lohnt sich vor dem Hintergrund des übergeordneten Ziels einer besseren Datenqualität: Der Steigerung des Return on Investment und dem langfristigen Erhalt des Werts der Daten.

0 Kommentare