AI Agents: Im Dialog mit Ihren Daten

- Veröffentlicht:

- Autor: Dr. Hedda Gressel, Dr. Philipp Schwartenbeck

- Kategorie: Deep Dive

Inhaltsverzeichnis

Die Entwicklung von Agentic AI gehört zu den spannendsten Fortschritten der jüngeren Vergangenheit in der Künstlichen Intelligenz (KI). Sie verspricht, eine neue Ära von LLM-Agenten einzuleiten (siehe unseren Blog Die Zukunft ist Agenten-Basiert: Ein Überblick über Multi-Agenten-LLM-Systeme, sowie unser Webinar und unseren Podcast für eine ausführliche Einführung). Herkömmliche LLM-Chatbots sind darauf beschränkt, Aufgaben über Sprachverständnis oder genauer gesagt über die Vorhersage des nächsten Wortes zu lösen. Das bedeutet, dass jegliches faktisches, mathematisches, programmierbezogenes oder domänenspezifisches Wissen nur ein Nebenprodukt des Trainings auf großen Textmengen aus dem Internet ist, mit dem Ziel, zu lernen, wie Sätze fortgesetzt werden. Multiagentensysteme hingegen verankern LLM-Chatbots in der realen Welt.

In diesem Blogpost werden wir die spannenden Möglichkeiten aufzeigen, die durch AI Agents ermöglicht werden. Wir beleuchten verschiedene Branchen und zeigen potenzielle Anwendungsfälle auf, mit einem Fokus darauf, wie Agentic AI eingesetzt werden kann, um mit Ihren Daten ausschließlich in natürlicher Sprache zu interagieren. Dabei präsentieren wir im Detail eine erfolgreiche Anwendung, die wir entwickelt haben: ein auf AI Agents gestütztes Supportsystem, das Nutzern ohne Vorkenntnisse in Graphdatenbanken hilft, mühelos Abfragen zu schreiben und Analysen mit den zugrunde liegenden Daten durchzuführen.

Was sind AI Agents?

Multiagentensysteme bestehen aus Gruppen von „Agenten“, die miteinander interagieren können. Dabei besteht jeder AI Agent aus drei Komponenten: Ihrer „Intelligenz“ (meistens ein LLM, aber es kann jedes Basis-Modell sein), ihrer „Rolle“ (meistens ein System-Prompt, der ihr allgemeines Verhalten festlegt) und ihren „Fähigkeiten“. Entscheidend ist, dass diese Fähigkeiten jede Funktionalität umfassen können, von Websuche über Programmieren, Codeausführung, Retrieval-Augmented Generation, mathematische Schlussfolgerungen bis hin zu benutzerdefinierten Funktionen. Auf diese Weise kann Ihr LLM-Chatbot auch Funktionen ausführen und Werkzeuge nutzen, wodurch er praktisch jede Aufgabe bewältigen kann, die als Funktion beschrieben werden kann (also jede Aufgabe).

Zum Beispiel könnte ein Websuche-Agent mit einem Codegenerierungs- und einem Codeausführungs-Agenten zusammenarbeiten, um effizientes Web-Scraping durchzuführen. Ein Content-Generierungs-Agent könnte von einem Sicherheits-Agenten überprüft werden, um sensible Informationen zu schützen. Technisch gesehen bietet dies einen Rahmen für interaktive Werkzeuge oder Funktionen, die miteinander kommunizieren können. Diese Agenten interagieren über natürliche Sprache, rufen Funktionen auf und interpretieren die Ausgaben in natürlicher Sprache, um fundierte Entscheidungen zu treffen. Zum Beispiel, ob ein Programmierproblem gelöst wurde oder der generierte Code überarbeitet werden muss.

Das verdeutlicht ein wichtiges Konzept der Agentic AI: das menschzentrierte Design (human-in-the-loop). Indem die Interaktion über natürliche Sprache ermöglicht wird, können Nutzer aktiv mit diesen Agenten kommunizieren, die Diskussion lenken und die Ergebnisse bewerten. Im Gegensatz zu herkömmlichen KI-Systemen erlaubt dieser Ansatz Nutzern, am analytischen Prozess teilzunehmen, ohne tiefgehende Kenntnisse über die zugrunde liegenden Algorithmen oder Programmierfähigkeiten zu besitzen. Angesichts all dieser Aspekte wird erwartet, dass Agentic AI eine neue Generation künstlicher Intelligenz einleitet und uns möglicherweise einen Schritt näher an allgemeine künstliche Intelligenz (AGI) bringt.

Erste Erfolgsgeschichten von AI Agents

Obwohl sich die Nutzung von AI Agents noch in einem frühen Stadium befindet, gibt es bereits Erfolgsgeschichten aus verschiedenen Daten- und KI-Anwendungsfällen. So wurden sie erfolgreich im Bereich der Inhaltserstellung eingesetzt, bei der unterschiedliche fiktionale Charaktere zusammenarbeiten, um eine Marketingkampagne zu erstellen, sowie in der Softwareentwicklung, bei der Agenten Code generieren und automatisch testen, oder bei personalisierten Empfehlungssystemen. Besonders hervorzuheben ist ihre Nutzung zur Datenanalyse. Solche Anwendungen können von komplexen Optimierungsproblemen über grundlegende Analysen wie kausale Entdeckungen bis hin zum Abrufen und Verbinden von Daten aus verschiedenen Datenbanken reichen.

Use Cases für AI Agents aus verschiedenen Branchen

AI Agents sind besonders im Fertigungs- und Produktionssektor prominent. Herausforderungen wie die Optimierung komplexer Systeme – sei es eine Lieferkette, ein Steuerungssystem oder eine Produktionslinie – sind von Natur aus vielschichtig und beinhalten zahlreiche miteinander abhängige Komponenten. Sie bieten jedoch großes Potenzial für Optimierung und Kosteneinsparungen durch eine effizientere Ressourcennutzung und optimiertes Zeitmanagement. Allerdings ist es sehr schwierig, solche Probleme mit einem einzigen, allgemeinen Algorithmus zu optimieren. Stattdessen können wir Experten-Agenten definieren, die spezifische Komponenten einer Lieferkette oder Produktionslinie analysieren und miteinander kommunizieren. Dies ermöglicht gezielte Analysen des Zeiteinsparungspotenzials durch Änderungen bestimmter Parameter, die wiederum mit Einblicken und Analysen zu Qualitätsveränderungen an einem Produktionsstandort verknüpft werden können. Das formt eine Grundlage für eine smarte Fabrik, in der Prozesse hochgradig automatisiert optimiert werden, während die menschliche Kontrolle und Beteiligung dort gewährleistet bleibt, wo sie notwendig oder gewünscht ist.

Ein weiterer wichtiger Aspekt von Anwendungen der AI Agents ist die Idee des „Dialogs mit Ihren Daten“. Unternehmen müssen oft enorme Datenmengen verarbeiten. Wertvolle Erkenntnisse aus diesen Daten zu gewinnen ist eine Herausforderung, da oft Ressourcen, Zeit oder das nötige Fachwissen fehlen, um die Daten effizient zu verarbeiten und gezielte Analysen durchzuführen. Wichtige Fragen im Bereich der Fertigung und Produktion beziehen sich beispielsweise oft auf die Kausalerkennung. Wäre es nicht großartig, herauszufinden, warum ein kleiner Prozentsatz von Teilen am Ende einer Produktion ausfällt, und idealerweise frühzeitig einzugreifen, um Zeit und Geld zu sparen? In der Praxis ist das schwer zu erreichen, da für solche kausalen Analysen große Datenmengen verarbeitet und viele kausale Interventionsstudien durchgeführt werden müssen („Wenn ich Maßnahme X am Anfang der Produktionslinie manipuliere, wie wirkt sich das auf Produkt Y am Ende der Linie aus?“). Multiagentensysteme führen diese Analysen für Sie durch. Sie können ein System aus AI Agents entwerfen, das aus einem Code-Generierungs-Agenten, einem Codeausführungs-Agenten, Agenten mit spezifischem Fachwissen über den Produktionsprozess und einem menschzentrierten Agenten besteht. Dieses System kann, wenn es mit Daten versorgt wird, Tests gemäß den Anfragen eines menschlichen Nutzers durchführen und mehrere Analysen zur Untersuchung kausaler Zusammenhänge mit einem hohen Grad an Automatisierung durchführen. Die Anfrage „Finde heraus, warum Teil Y manchmal ausfällt“ könnte beispielsweise einen Experten-Agenten dazu veranlassen, Schätzungen zu potenziellen Ursachen bereitzustellen, die anschließend von den Code-Generierungs- und Ausführungs-Agenten getestet und zur Interpretation an die Experten-Agenten zurückgesandt werden. Solche Anwendungen bieten enormes Potenzial für Kosteneinsparungen und Optimierung, und wir haben solche Projekte erfolgreich mit verschiedenen Partnern umgesetzt.

Ein weiteres Beispiel, das viele Unternehmen im Rahmen ihrer Digitalisierung betrifft: Ein großes Problem sind riesige Datenmengen, die in verschiedenen Data Lakes und Data Warehouses gespeichert werden. Fragen wie „Wo speichern wir welche Daten?“ oder „Wie können wir auf diese Daten zugreifen?“ sind zunehmend schwer zu beantworten. AI Agents können auch diese Aufgabe übernehmen: Sie untersuchen automatisch relevante Datenbanken, finden die richtige Verbindungsmethode zu diesen Datenbanken, können relevante Daten abrufen, verschiedene Datenquellen zusammenführen und deskriptive Analysen dieser Daten durchführen. Ein häufiger Hinderungsgrund beim Zugriff auf Daten ist, dass dies Kenntnisse einer Programmiersprache erfordert, die Nutzern möglicherweise nicht vertraut ist. Während ein herkömmlicher Ansatz zum Abrufen von Daten aus einer Datenbank von den Nutzern verlangen würde, eine Sprache wie SQL zu erlernen und Abfragen zu formulieren, können Nutzer, die mit AI Agents arbeiten, ihre Abfrage in natürlicher Sprache formulieren. Diese wird dann in die korrekte Abfrage übersetzt und von den KI-Agenten ausgeführt. Die Nutzer erhalten anschließend ihre Daten und mögliche zusätzliche Analysen, ohne eine (oft veraltete) Programmiersprache lernen zu müssen, wodurch die Zugänglichkeit von Daten für die Nutzer erheblich gesteigert wird.

Und was ist mit Nutzern, die nicht einmal wissen, welches Tool oder welche Programmiersprache sie verwenden müssen, um ihre Datenbank abzufragen? Kein Problem: AI Agents können diese Informationen finden, indem sie auf das Wissen der LLM zurückgreift, eine Websuche durchführt oder relevante Dokumentationen analysiert.

Von Neo zu AI Agents: Ein Praxisbeispiel

Im Folgenden bieten wir eine vertiefte Illustration des vorherigen Beispiels. In einem kürzlich durchgeführten Anwendungsfall haben wir eine graphbasierte Darstellung eines Produktionsprozesses implementiert. Graphbasierte Darstellungen sind zunehmend beliebt geworden, da sie effiziente Darstellungen von relationalem Wissen ermöglichen, beispielsweise zwischen verschiedenen Teilen einer Baugruppe oder zwischen verschiedenen Knotenpunkten eines Produktionsstandorts. Wir haben diesen Graphen in einer beliebten Graphdatenbank namens Neo4j implementiert. Trotz der vielen Vorteile und Möglichkeiten einer solchen Graphdarstellung gibt es auch einen Nachteil: Abfragen müssen in einer Programmiersprache Cypher geschrieben werden, mit der viele Nutzer möglicherweise nicht vertraut sind.

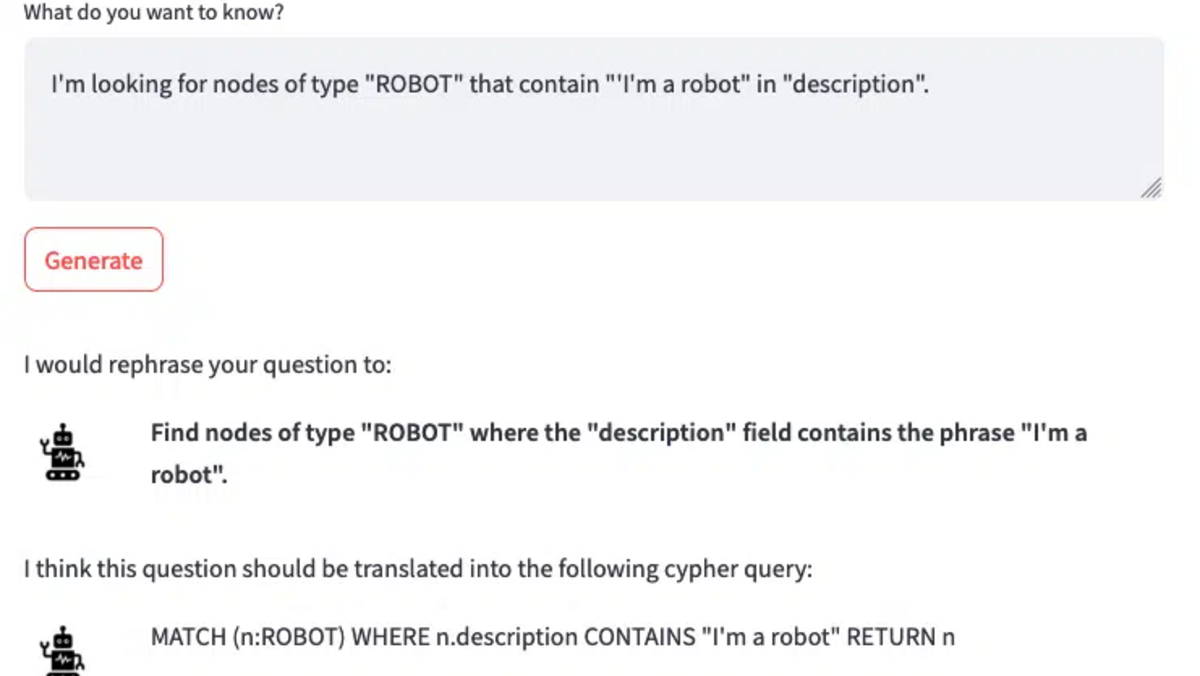

Bedeutet das, dass alle potenziellen Nutzer sich hinsetzen und Cypher lernen müssen, bevor sie die Daten und die zugrunde liegenden Beziehungen abfragen können? Nicht im Zeitalter der Agentic AI: Abbildung 1 veranschaulicht den Schritt „Von Neo zu AI Agents“. Nutzer können eine Frage zu den Graphdaten in natürlicher Sprache stellen, die dann von KI-Agenten verarbeitet wird. Da Nutzer nicht immer den richtigen Ton oder die Spezifität einer Frage treffen (wie in diesem Beispiel veranschaulicht), reformuliert ein Einstieg-Agent namens „Smith“ die Frage, um sie leichter in eine Cypher-Abfrage übersetzen zu können. Solche Eingabeverarbeitungen sind gängige Praxis mit AI Agents. Ein weiteres Beispiel hierfür wäre ein Agent, der bewertet, ob ein Thema in einer bestehenden Datenbank gefunden werden kann oder im Web gesucht werden muss.

Sobald Agent „Smith“ die natürliche Sprachabfrage reformuliert und verbessert hat, was in diesem Beispiel zu „Wie viele Knoten gibt es im System?“ führt, wird die Cypher-Abfrage von Agent „Jones“ generiert und von Agent „Brown“ ausgeführt. Schließlich übersetzt Agent „White“ die Abfrageergebnisse zurück in natürliche Sprache.

Abbildung 1. Darstellung des Prozesses zur Nutzung einer AI Agents, um Daten in einer Graphdatenbank (hier: Neo4j) abzufragen und zu beschreiben. Ein Einstiegs-Agent reformuliert und verbessert die Frage eines menschlichen Nutzers, die dann an einen weiteren Agenten weitergegeben wird, der die Nutzeranfrage in die erforderliche Programmiersprache (Cypher) übersetzt. Ein dritter Agent führt die Abfrage aus und erhält ein Ergebnis, das von einem vierten Agenten in natürliche Sprache zurückübersetzt wird.

Dieses Multiagentensystem kann Benutzeranfragen mit hoher Effizienz bearbeiten und auf deren Grundlage korrekte Analysen der Graphdaten liefern. Abbildung 2 zeigt eine realistischere Art von Abfrage, die zu einem komplexeren Cypher-Befehl und umfangreicheren Ergebnissen führt (Ergebnisse aus Vertraulichkeitsgründen nicht dargestellt). Natürlich könnten die AI Agents auch so eingerichtet werden, dass sie als Gruppenchatsystem fungieren, in dem die Agenten verschiedene Abfragen testen und die Ergebnisse analysieren, bis ein bestimmtes Qualitätskriterium erreicht ist. Wichtig ist, dass dieser Ansatz nicht nur dazu dient, ausgefallene, Matrix-inspirierte Gespräche zwischen Neo-Agenten zu führen oder den ersten Preis bei einem Hackathon zu gewinnen, sondern auch in realen Anwendungsfällen erheblichen Einfluss und Wert schaffen kann.

Abbildung 2. Das Multiagentensystem kann problemlos in seiner Komplexität erweitert werden. Es kann komplexere und realistischere Abfragen sowie Programmierherausforderungen bewältigen (Ausgaben aus Datenschutzgründen nicht dargestellt) und auch komplexere Kommunikationsmuster wie hierarchische Gruppenchats oder Feedback-Schleifen unterstützen.

Wie sich LLM durch Multi-Agenten-Systeme weiterentwickeln lassen: Einschränkungen, Herausforderungen und Entwicklungen

Die Zukunft ist Agenten-Basiert: Ein Überblick über Multi-Agenten-LLM-Systeme

Fazit

Agentic LLM-Systeme werden den Weg für eine neue Generation künstlicher Intelligenz ebnen, die sowohl unser tägliches Leben als auch traditionelle Geschäftsprozesse tiefgreifend transformiert. Wir sehen enormes Potenzial für Anwendungen von AI Agents in verschiedenen Bereichen und haben insbesondere erfolgreiche Anwendungen in der Fertigung und Produktion beobachtet, die es (nicht-technischen) Nutzern ermöglichen, mit ihren Daten zu sprechen. Die Architektur der human-in-the-loop ist ein Schlüsselelement solcher Ansätze und ermöglicht es Nutzern, in natürlicher Sprache mit diesen Systemen zu interagieren und die Ausführung eines Algorithmus aktiv zu begleiten und zu steuern. Wir glauben, dass solche Anwendungen den Beginn einer neuen Ebene smarter Fabriken markieren, die Arbeitsabläufe durch den Einsatz von AI Agents automatisieren und komplexe Analysen basierend auf natürlicher Sprache durchführen.

Diesen Beitrag teilen: