Das Sprachmodell GPT-3 hat eindrucksvoll gezeigt, wie KI unsere Sprache versteht und selbst Texte schreiben, analysieren oder zusammenfassen kann. Neuerdings sorgen Text-to-Image Transformer für Schlagzeilen und zeigen bildgewaltig, was neue KI-Modelle können: Text-to-Image Transformer sind in der Lage aus Text Bilder zu erstellen, die menschengemachten Kunstwerken und Fotos erschreckend nahekommen. Wie nah? Wir haben 2 Bilder zusammengestellt (s.u.) – ein Foto ist echt, ein Foto durch ein Text-To-Image-Model wie Midjourney oder Stable Diffusion erzeugt. Also zunächst ein kleines Quiz: Welches der beiden Bilder ist ein echtes Foto? Die Auflösung folgt im Laufe des Artikels.

Benötigen Sie Unterstützung bei Ihren Generative AI-Projekten? Vom unserem Use Case Workshop über unsere Führungskräfte Schulung bis hin zur Entwicklung und Pflege von GenAI-Produkten bietet die Alexander Thamm GmbH seinen Kunden ein weites Spektrum von Dienstleistungen im Bereich Generative AI an. Informieren Sie sich auf unserer Dienstleistungsseite und kontaktieren Sie uns jederzeit für eine unverbindliche Beratung:

Inhaltsverzeichnis

Von richtig realistisch bis völlig skurril

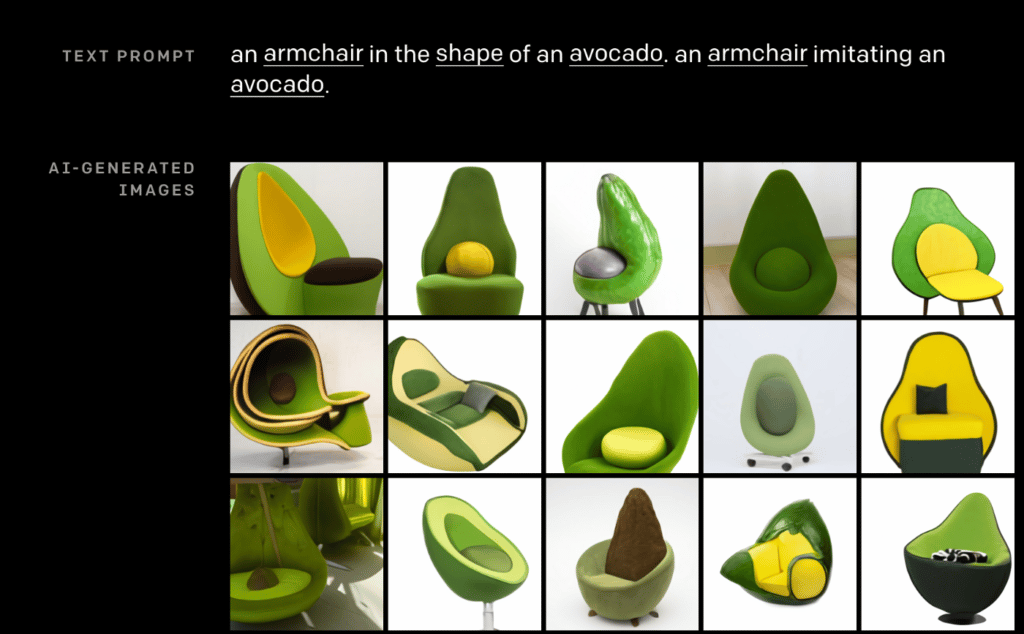

Im Januar 2021 brachte das US-Unternehmen OpenAI ein bisher in dieser Qualität nicht da gewesenen Text-to-Image-Transformer Modell heraus: DALL:E. Basierend auf dem Sprachmodell GPT-3 kann DALL:E mithilfe der Eingabe einer Anweisung (sog. Prompt) ein Bild ausgeben. Das künstlich erstellte Bild basiert auf den Elementen, die in der Anweisung gefordert sind. Der Clou an der Sache: Es handelt sich dabei nicht um Art Suchmaschine, die aus bestehenden Bilder ein passendes auswählt, sondern es wird ein neues eigenständiges, bislang nicht existierendes Bild kreiert. Außerdem ist es dabei völlig egal, ob es das Objekt auch in der Realität gibt – man kann der Fantasie freien Lauf lassen. Einen Sessel in Form einer Avocado kann man sich beispielweise schlecht vorstellen. DALL:E schon:

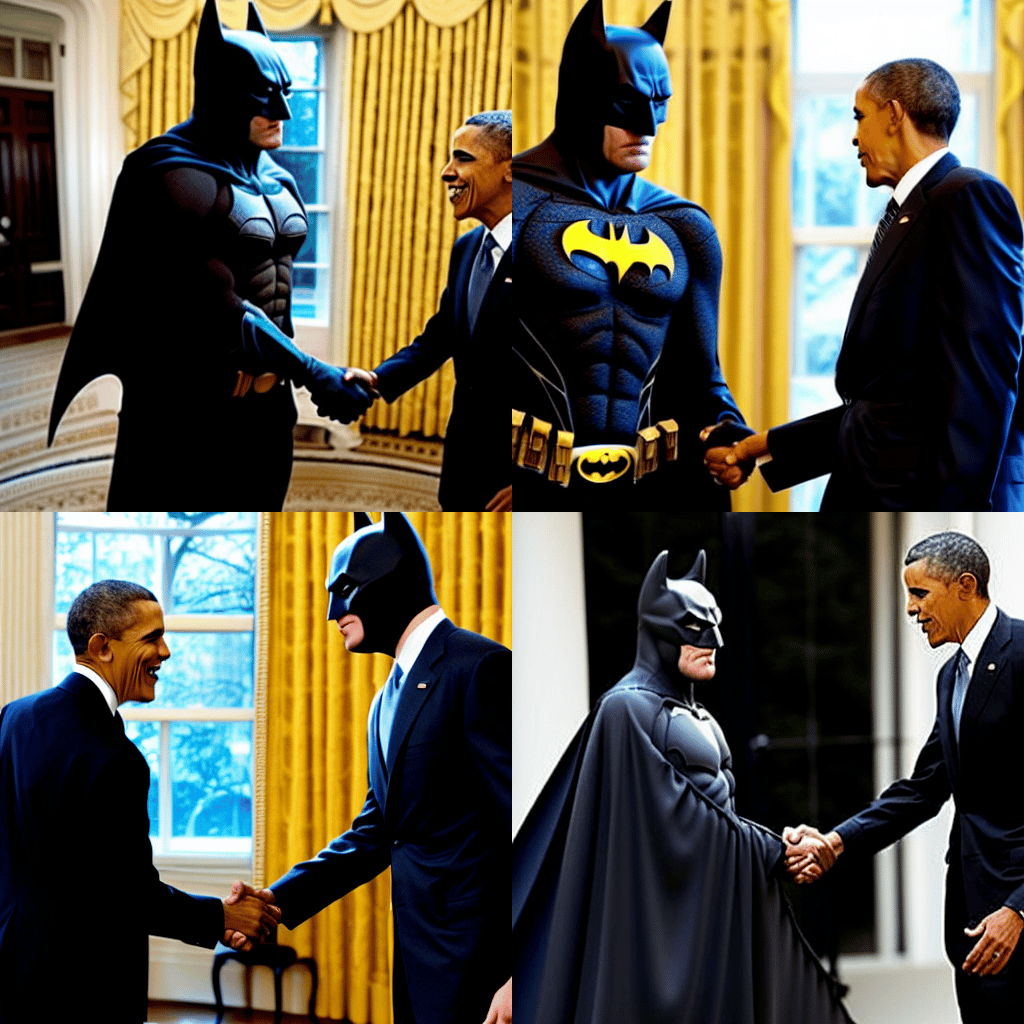

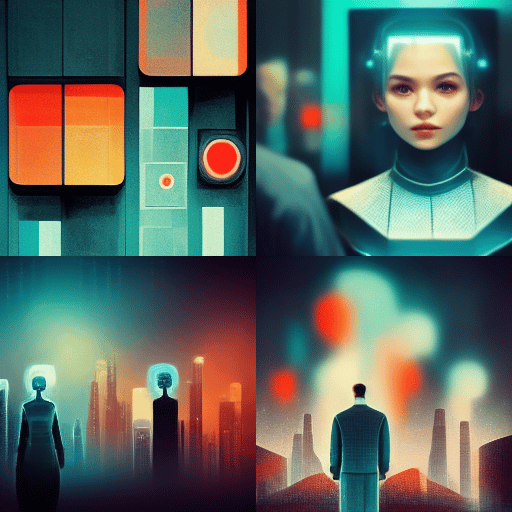

Zunächst waren nur Bilder nur mit recht niedriger Auflösung und Genauigkeit erstellbar. Das hat sich innerhalb der letzten eineinhalb Jahre jedoch massiv verändert. Neuere Transformer-Modelle von privatwirtschaftlichen Unternehmen wie OpenAI (DALL:E 2) oder Google (Imagen) aber auch Entwicklercommunities wie dem Zusammenschluss aus CompVis (Forschungsgruppe der LMU München), Stability.ai und LAION oder Forschungslaboren wie Midjourney können mehr: Sie generieren kaum von der Realität unterscheidbare Fotos, generieren atemberaubende Kunstwerke oder bringen total unterschiedliche und unrealistische Situationen auf einem Bild zusammen.

Stable Diffusion von Stabilty.ai, veröffentlicht im August 2022, ist Open-Source, unzensiert und lässt sich von jedem verwenden. Je nach verfügbarer Rechenleistung lassen sich damit interessante Bilder generieren und mit etwas Experimentieren fantastische Fantasiewelten sowie hyperrealistische Fotos erzeugen. Aber wie?

Text-to-Image Transformer funktionieren mithilfe sogenannter Prompts. Dabei gilt es, das Bild, das man erstellen möchte, so genau wie möglich zu beschreiben inklusive der darauf abgebildeten Charaktere, des Kunststils, der Kamera, mit der das Bild “geschossen” wurde, sowie dem Künstler. Stable Diffusion kennt bekannte Filmfiguren, Brühmtheiten, Fantasiecharaktere und Marken – also nahezu alles, wovon es Bilder im Internet gibt.

Was steckt dahinter?

Solche Modelle entstehen mit einem riesigen Datensatz aus Bildern und deren textuelle Beschreibung. Mithilfe von NLP (Natural Language Processing) werden die Beschreibungen der Bilder interpretiert und den Bildern zugeordnet. Im Fall von Stable Diffusion kommen diese Bilder aus der LAION-5B Datenbank, einer Sammlung von 5,85 Milliarden Bildern mitsamt Textbeschreibungen.

Das Training der Modelle mithilfe dieser Bilder kann dabei mitunter lange Zeit in Anspruch nehmen, je nachdem auf welcher Hardware es abläuft. Die erste Version von Stable Diffusion wurde auf einem Ultracluster mit 4.000 A100 GPUs trainiert. Um das Modell zu nutzen, ist ebenfalls ein gewisser Grad an Hardware nötig: Wer Stable Diffusion lokal ausrobieren möchte, sollte laut Stability.ai jedenfalls mindestens 10GB VRAM in seiner Grafikkarte zur Verfügung haben (in unseren Tests funktioniert es sogar auch mit nur 6GB auf einer GTX2060). Stable Diffusion ist darauf ausgerichtet, dass es auch auf dem eigenen Heim-Computer funktionieren soll und nicht nur in Rechenzentren und auf GPU-Clustern.

Ist das Kunst oder wer hat Recht?

Die möglichen Anwendungsgebiete von Stable Diffusion, Midjourney & Co. sind vielfältig, denn: Der Prompt unterliegt zwar je nach Länge und Komplexität dem Urheberrecht des „Erfinders“, die Bilder jedoch nicht. Laut dem U.S. Copyright Office lässt sich das Bildrecht nicht auf ein KI-generiertes Kunstwerk übertragen, weil es keinen menschlichen Autor oder Urheber hat. Daher lassen sich diese, zumindest nach aktuellem Stand, für jegliche Zwecke verwenden.

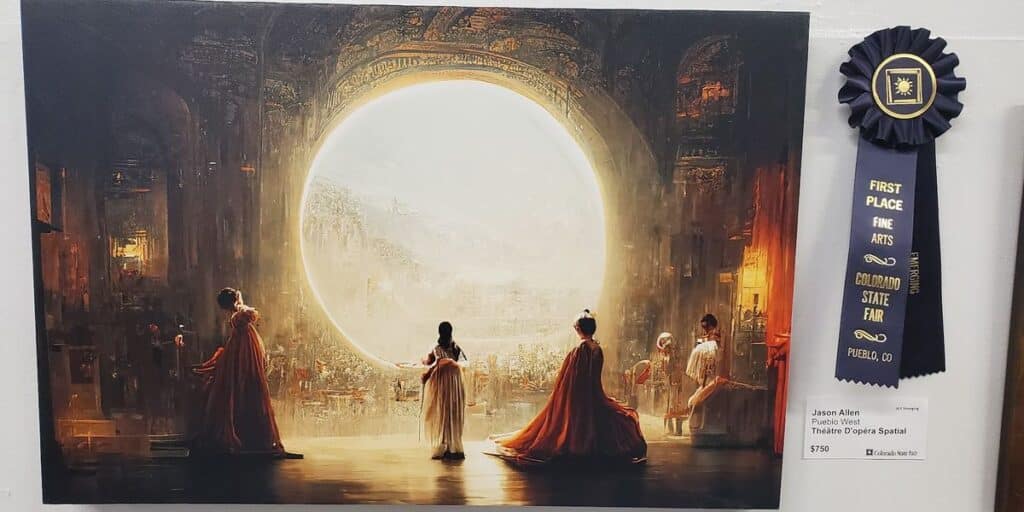

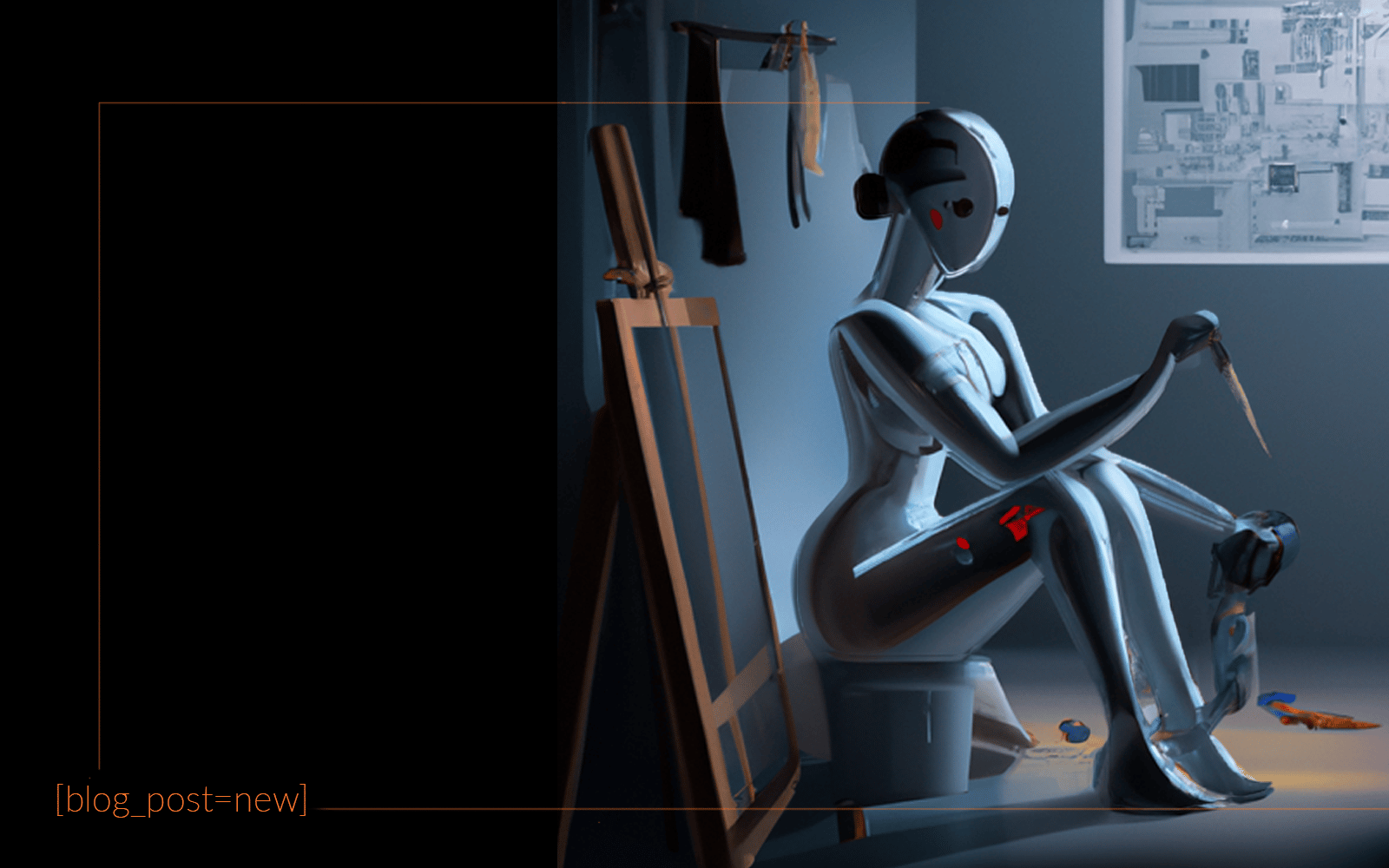

In der Kunstszene finden die Modelle jetzt schon Anklang und viele User nutzen sie auf kreative Weise. Mit Bildern, Fantasiewelten, Comics & Co. kann jeder ganz individuelle Kunstwerke erschaffen. Auf dem Kunstwettbewerb der Colorado State Fair konnte der Künstler Jason Allen mit seinem via Midjourney generiertem Kunstwerk “Théâtre D’opéra Spatia” sogar die Jury überzeugen, gewann mit der KI-Schöpfung prompt den ersten Platz und sorgte damit für Furore in der Kunstszene und darüber hinaus.

Die Modelle lassen sich aber auch kreativ für Illustrationen nutzen: Durch Img-to-Img Funktionen können bestehende Bilder bearbeitet, bisher nicht da gewesene Elemente eingefügt oder störende gelöscht werden.

Stable Diffusion & Co. können beispielsweise bei Produktdesign, Innenarchitektur, Logos oder Illustrationen zur Bearbeitung oder zum Sammeln von Inspirationen genutzt werden. Die möglichen Anwendungsbereiche sind vielfältig und bislang nicht ansatzweise ausgeschöpft.

Aber was können die Modelle denn wirklich? Nachdem wir hier schon einige Beispiel gezeigt haben, folgt die Auflösung zum Quiz oben. Die Richtige Antwort: Beide Bilder sind durch eine KI erzeugt worden – das Eine durch Midjourney, das Andere durch Stable Diffusion. Nach Hochskalierung und Farbkorrektur sehen die Bilder mittlerweile täuschend echt aus. Das Interessante: Die beiden Personen auf den Bildern existieren nicht, sie sind lediglich von den beiden Modellen nach Eingabe des Prompts erstellt worden.

Wie wird man KI-Künstler?

Wer Stable Diffusion oder Midjourney (die beiden “kostenlos” nutzbaren Modelle) selbst testen will, kann dies völlig ohne Programmiererfahrung tun. Mittlerweile gibt es frei herunterladbare Anwendungen – und weil Stable Diffusion Open-Source ist kann man sich hier sogar mit etwas Python-Programmiererfahrung am Modell selbst austoben (erhältlich über HuggingFace). Wer aber keinen GPU-Cluster im Haus hat, wählt besser folgende Optionen:

Midjourney lässt sich am einfachsten über die Website nutzen. Hier kann man dem offiziellen Discord-Kanal beitreten und dort kostenlos ausprobieren, ob ein “Prompt-Künstler” in einem steckt. Weiter besteht dann die Möglichkeit Upscaling (Hochskalieren) der Bilder zu betreiben. Durch Upscaling wird die Auflösung der Bilder mittels KI künstlich erhöht.

Stable Diffusion lässt sich am einfachsten ebenfalls über deren offizielle Plattform nutzen. Mit der Beta der Webapp Dreamstudio kann man online eigene Prompts schreiben und daraus von Stable Diffusion interessante Bilder kreieren lassen. Aber: Nativ sind die Bilder des Modells in einer Auflösung von 512×512 erhältlich. Die Auflösung lässt sich hier zwar künstlich erhöhen – damit erhöht sich aber auch die benötigte Anzahl an Tokens zur Erstellung.

KI, quo vadis?

Stable Diffusion ist als erstes Open-Source Text-to-Image Modell noch nicht lange auf dem Markt (22. August 2022). Dennoch entwickeln sich rapide erste Anwendungen, Integrationen und Apps zur Nutzung – Tendenz stark steigend. Theoretisch lassen sich auf der Basis solcher Modelle auch Weitere trainieren, beispielsweise zum Vorlesen von Sprache oder Generierung von Musik.

Zu bedenken ist, dass Videos aus mehreren Bildern pro Sekunde bestehen. Mithilfe adäquater Rechenpower, Hochskalierung sowie der Kombination aus Text-to-Image und Image-to-Image Modellen lassen sich Animationen oder Videos erstellen, wie beispielsweise hier gezeigt.

Und was sagt die KI dazu? Wir haben Midjourney gefragt, wie die Zukunft aussieht: Was uns diese Bilder sagen sollen, wissen wir selbst noch nicht so ganz – aber vielleicht bald. 😉

0 Kommentare