Fraud Detection und KI-Agenten im Bankensektor

Herausforderungen, Trends und Lösungen

- Veröffentlicht:

- Autor: Dr. Nicholas Drude, Dr. Till Plumbaum

- Kategorie: Deep Dive

Inhaltsverzeichnis

Im Bankensektor hat der finanzielle Schaden durch Betrug in den letzten Jahren deutlich zugenommen – allein in Deutschland beläuft er sich jährlich auf einen zweistelligen Milliardenbetrag. Professionelle Täter nutzen gezielt digitale Kanäle und setzen auf immer ausgefeiltere Angriffsmuster, während Banken mit bestehenden Systemen versuchen, eine effektive Abwehr zu gewährleisten. Gleichzeitig wachsen die regulatorischen Anforderungen, etwa durch die EU-Zahlungsdiensterichtlinie (PSD2), die Geldwäsche-Richtlinie (AMLD) und den EU AI Act. Angesichts dieser Herausforderungen rückt ein ganzheitliches und leistungsfähiges Betrugsmanagement zunehmend in den Mittelpunkt. Im Folgenden erhalten Sie einen Überblick über die häufigsten Betrugsfälle im Bankensektor, aktuelle Methoden zur Betrugserkennung sowie bestehende Schwachstellen und technologische Entwicklungen – sowohl auf Seiten der Täter als auch der Verteidigung. Zudem beleuchten wir neue Anforderungen an moderne Betrugserkennungstools.

Fraud Detection im Bankenwesen: Eine Herausforderung von wachsender Komplexität

Betrugsstrategien reichen von Identitätsdiebstahl bei Kontoeröffnungen über Phishing und Vishing (Voice Phishing) bis hin zu komplexen Geldwäschemethoden und nutzen zunehmend neue Technologien, wie etwa Deepfake-Videos, um ihre Aktivitäten zu verschleiern und zu verschärfen. Fraud Detection bzw. viele herkömmliche Betrugserkennungssysteme arbeiten regelbasiert und reagieren auf bekannte Auffälligkeiten, wie ungewöhnliche Transaktionsbeträge oder Login-Versuche aus unbekannten Regionen. Solche Ansätze stoßen jedoch zunehmend an ihre Grenzen: Sie sind leicht zu umgehen, schlagen oft Alarm, obwohl alles in Ordnung ist, und erkennen neue Betrugsarten meist nicht rechtzeitig.

Vor diesem Hintergrund liegt die zentrale Herausforderung für Banken darin, bestehende Systeme und Ansätze in eine integrierte, ganzheitliche Lösung zu überführen. Die bislang fragmentierten Datenströme aus verschiedenen Kanälen – wie Online-Banking, Kreditvergabe oder Filialgeschäft – müssen in einer konsolidierten, kanalübergreifenden Plattform zusammengeführt werden. Erst durch diese Integration wird ein konsistentes Echtzeit-Scoring möglich, das auch komplexe Betrugsmuster zuverlässig erkennt. Zudem ist eine solche zentrale Plattform zur Datenaggregation und -analyse entscheidend, um gravierende Anomalien frühzeitig aufzudecken und die notwendige Datenqualität sicherzustellen, die Machine-Learning-Modelle benötigen, um präzise, vollständige und verlässliche Vorhersagen zu treffen. So entsteht ein umfassender, kontextbezogener Blick auf Kundenaktivitäten über alle Berührungspunkte hinweg – die essenzielle Grundlage für eine adaptive und nachhaltige Betrugsabwehr.

Bestehende Schwachstellen und Risiken

Trotz der Fortschritte in der Integration von Daten und Systemen bleiben im Bankensektor erhebliche Sicherheitslücken bestehen.

Betrüger reagieren zunehmend agil auf technische Innovationen und nutzen gezielt verbleibende Schwachstellen, etwa in Prozessabläufen oder neu eingeführten Technologien. Gerade bei der Implementierung neuer, komplexer Betrugserkennungsmodelle besteht das Risiko, dass diese nicht schnell genug an veränderte Angriffsmuster angepasst werden können.

Ein weiteres Risiko liegt darin, dass sich Banken möglicherweise zu stark auf rein technische Lösungen verlassen und dabei das notwendige Zusammenspiel aus KI-gestützten Modellen und menschlicher Expertise vernachlässigen. Gerade komplexe oder neuartige Betrugsszenarien erfordern nach wie vor menschliches Urteilsvermögen, um Algorithmen richtig zu kalibrieren, Ergebnisse kritisch zu bewerten und letztlich eine nachhaltige und verlässliche Betrugsabwehr zu gewährleisten.

KI-Agenten, Generative KI, XAI: Trends und technologische Entwicklungen

Moderne Betrugsstrategien sind dynamisch und nutzen neue Technologien, was herkömmliche, regelbasierte Systeme an ihre Grenzen bringt. Eine fortgeschrittene Antwort auf diese Herausforderung sind Agentic AI-Ansätze. Agentic AI bezeichnet eine neuartige Kategorie von KI-Systemen, die nicht nur auf Probleme reagieren, sondern autonom agieren können. Im Gegensatz zu traditionellen KI-Modellen, die festen Regeln folgen oder menschliche Eingaben erfordern, sind agentische Systeme zielgerichtete "Agenten", die in der Lage sind, wahrzunehmen, zu schlussfolgern und in Echtzeit Maßnahmen zu ergreifen. Man kann sie sich als digitale Detektive vorstellen, die Systeme überwachen, Anomalien erkennen und sofort auf Bedrohungen reagieren, ohne auf menschliche Genehmigung zu warten.

KI-Agenten ermöglichen es auf die neuen Herausforderungen zu reagieren, indem sie bewährte Regeln mit selbstlernenden Algorithmen kombinieren, und so in der Lage sind, Anomalien frühzeitig zu identifizieren – auch ohne explizite Vorgabe. Sie lassen sich auch in bestehende Systeme, wie Big-Data-Plattformen, integrieren und können so große Mengen an Transaktions- und Kundendaten performant und in Echtzeit verarbeiten.

Durch den Einsatz von Graphtechnologien in Kombination mit GenAI und Agenten lassen sich Beziehungen und Netzwerke zwischen Akteuren dynamisch analysieren – ein entscheidender Vorteil beim Aufdecken koordinierter Betrugsnetzwerke. Gleichzeitig schaffen Explainable-AI-Ansätze Transparenz über die Entscheidungslogik der Modelle, was nicht nur Vertrauen fördert, sondern auch regulatorische Anforderungen erfüllt.

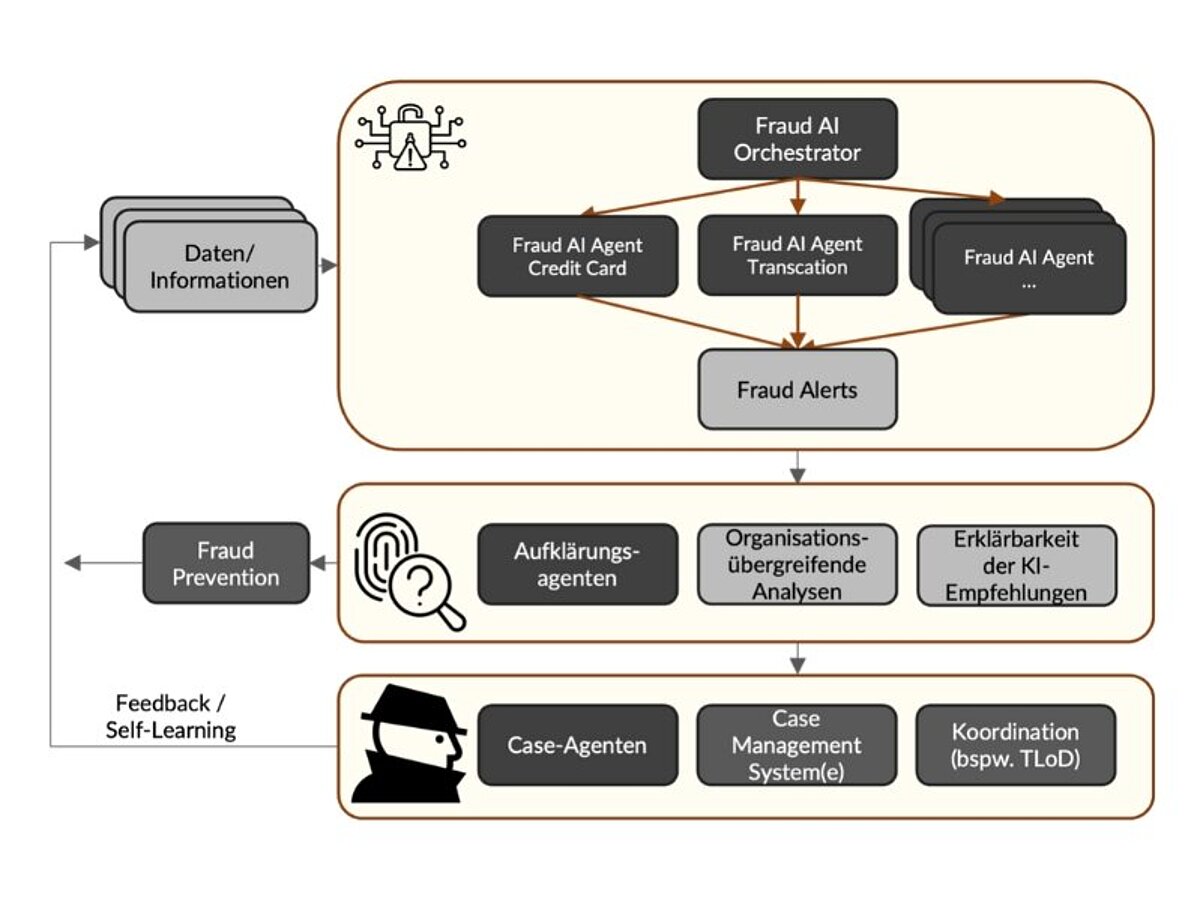

Abbildung 1 zeigt eine agentenbasierte Betrugsplattform. Diese besteht aus spezialisierten KI-Agenten, die entlang definierter Produkt- und Typologiematrizen Betrugswarnungen erzeugen. Ergänzend dazu analysieren Aufklärungsagenten diese Alerts, um Fehlalarme zu minimieren und die Entscheidungsgrundlage nachvollziehbar zu machen, während Case-Agenten die strukturierte Dokumentation und Fallbearbeitung übernehmen. Der gesamte Prozess wird durch einen zentralen Orchestrator gesteuert, der eine effiziente Zusammenarbeit der Agenten sowie die Integration in bestehende Case-Management- und Präventionssysteme sicherstellt. Auch im Know-Your-Customer-(KYC)-Umfeld kommen vermehrt KI-basierte Textverarbeitungsmodelle (Large Language Models) zum Einsatz. Sie ermöglichen eine automatisierte Prüfung externer Dokumente wie Geschäftsberichte oder Online-Quellen und decken dabei Auffälligkeiten und Widersprüche deutlich schneller auf als manuelle Prüfprozesse.

Anwendungsbeispiele von Fraud Detection

Wie solche Technologien konkret zum Einsatz kommen können, zeigen zwei von [at] durchgeführte Projekte:

Fraud Prevention mit Big Data für Banken

Eine Digitalbank möchte ihre Methoden zur Prävention und Erkennung von Betrugsfällen gezielt weiterentwickeln. Bislang fehlte jedoch eine effektive Möglichkeit, Netzwerkanalysen durchzuführen – also Beziehungen zwischen Kunden, Produkten und Transaktionen auf verdächtige Muster und Zusammenhänge hin zu untersuchen.

Um dies zu ändern, haben unsere [at]-Experten eine Big-Data-Datenbasis aufgebaut, die verschiedenste Datenquellen und Systeme automatisch miteinander verknüpft. Diese konsolidierte Datenbasis ermöglicht es, Netzwerkanalysen effizient und zuverlässig durchzuführen. Ergänzt wird sie durch einen Mustererkennungsalgorithmus, der ungewöhnliche Verbindungen, Transaktionen oder Verhaltensweisen automatisch identifiziert.

Die Lösung ermöglicht es der Bank, Betrugsfälle frühzeitig zu erkennen oder sogar präventiv zu vermeiden. Darüber hinaus liefert das System wertvolle Einblicke in die Interaktionen zwischen Produkten, Kunden und Transaktionen – auch jenseits von Fraud Detection. So entstehen neue Potenziale zur Serviceoptimierung und zur gezielten Weiterentwicklung der Serviceleistungen.

Fraud Prevention mit Advanced Analytics bei Kreditvergaben

Ein Finanzierungsinstitut möchte den manuellen Aufwand bei der Prüfung von Finanzierungsanfragen im Fahrzeugbereich deutlich reduzieren, ohne jedoch die Anzahl von Betrugsfällen zu erhöhen. Bislang erfolgt die Prüfung von Gehaltsnachweisen der Antragstellenden lediglich stichprobenartig und manuell – ein zeitintensiver Prozess mit begrenzter Skalierbarkeit.

Um diesen Vorgang zu beschleunigen und gleichzeitig die Betrugserkennung zu verbessern, haben unsere [at]-Experten ein Machine-Learning-Modell entwickelt, das für jeden einzelnen Finanzierungsvorgang eine Betrugswahrscheinlichkeit berechnet. Liegt ein Verdacht vor, wird der Fall automatisch zur manuellen Prüfung weitergeleitet.

Das Ergebnis: Der manuelle Bearbeitungsaufwand konnte um 56 % reduziert werden – bei gleichbleibend hoher Betrugserkennungsrate. Darüber hinaus bietet das System vielversprechende Potenziale für eine zukünftige Weiterentwicklung, beispielsweise durch die Integration zusätzlicher Datenquellen oder die Optimierung der Modelle mithilfe von MLOps-Prozessen.

“Das Ergebnis: Der manuelle Bearbeitungsaufwand konnte um 56 % reduziert werden […]”

Anforderungen an moderne Betrugserkennungstools

Wie die beschriebenen Use Cases zeigen, liegt der Schlüssel für eine wirksame Fraud Detection in der intelligenten, vernetzten Nutzung relevanter Daten. Dies reicht von der Kontoeröffnung über das Transaktionsverhalten bis hin zu externen Risikoinformationen. Nur wenn diese Informationen zentral gebündelt und in Echtzeit ausgewertet werden, lassen sich Risiken frühzeitig erkennen und fundierte Entscheidungen treffen.

Wichtig dabei ist, dass verdächtige Aktivitäten sofort erkannt und nur tatsächlich relevante Fälle zur Nachprüfung weitergeleitet werden. Das reduziert nicht nur den manuellen Aufwand, sondern schützt auch vor Alarmmüdigkeit in den Fachabteilungen.

Die Modelle müssen aber auch fortlaufend an neue Betrugsmuster angepasst werden – idealerweise durch den Einsatz von MLOps-Workflows, die eine automatisierte Modellüberwachung (Monitoring), Aktualisierung (Retraining und Finetuning) und Ausbringung (Deployment) gewährleisten. Gleichzeitig sind Transparenz und Nachvollziehbarkeit entscheidend, um regulatorische Anforderungen zu erfüllen und das Vertrauen der Nutzer zu stärken. Explainable-AI-Ansätze (XAI) helfen dabei, die Entscheidungslogik der Modelle nachvollziehbar darzustellen. Um diese Anforderungen zu erfüllen, braucht es agentische Systeme, die nicht nur auf vordefinierte Regeln reagieren, sondern eigenständig Anomalien erkennen und situativ handeln können. Solche autonomen Agenten sind in der Lage, Datenströme kontinuierlich zu beobachten, Entscheidungen in Echtzeit zu treffen und sich dynamisch an neue Bedrohungslagen anzupassen.

Darüber hinaus müssen moderne Fraud-Detection-Systeme flexibel in bestehende Prozesse und IT-Landschaften integrierbar sein – sowohl in digitale Kanäle als auch in stationäre Infrastrukturen. Offene Schnittstellen (z. B. APIs oder Webhooks) sorgen dafür, dass Informationen systemübergreifend verfügbar und effizient nutzbar sind.

Nicht zuletzt braucht es eine skalierbare und performante Architektur, die auch bei wachsenden Datenmengen und neuen Angriffsmustern zuverlässig funktioniert – idealerweise cloudbasiert, containerisiert und MLOps-ready.

Fazit

Wer auf integrierte Plattformen, verlässliche Datenqualität und intelligente KI-Prozesse setzt, legt den Grundstein für eine wirksame und zukunftssichere Betrugserkennung. So lassen sich nicht nur finanzielle Schäden minimieren, sondern auch das Vertrauen der Kunden nachhaltig stärken. Fraud Detection wird damit nicht nur zum Schutzmechanismus, sondern gleichzeitig zu einem strategischen Erfolgsfaktor für Kundenbindung und nachhaltiges Wachstum.

Entscheidend dafür ist die intelligente Verknüpfung aller relevanten Datenquellen – von Transaktions- über Geräte- bis hin zu Onboarding-Daten. Nur durch diese ganzheitliche Sicht auf das Kundenverhalten lassen sich Betrugsmuster frühzeitig erkennen und gezielt unterbinden.

Sie wollen wissen, wo Ihre Organisation in puncto Fraud Detection steht und wie moderne KI-gestützte Ansätze in Unternehmen zum Einsatz kommen können? Kontaktieren Sie uns noch heute für ein unverbindliches Beratungsgespräch oder ein maßgeschneidertes Use Case Assessment.

Diesen Beitrag teilen: