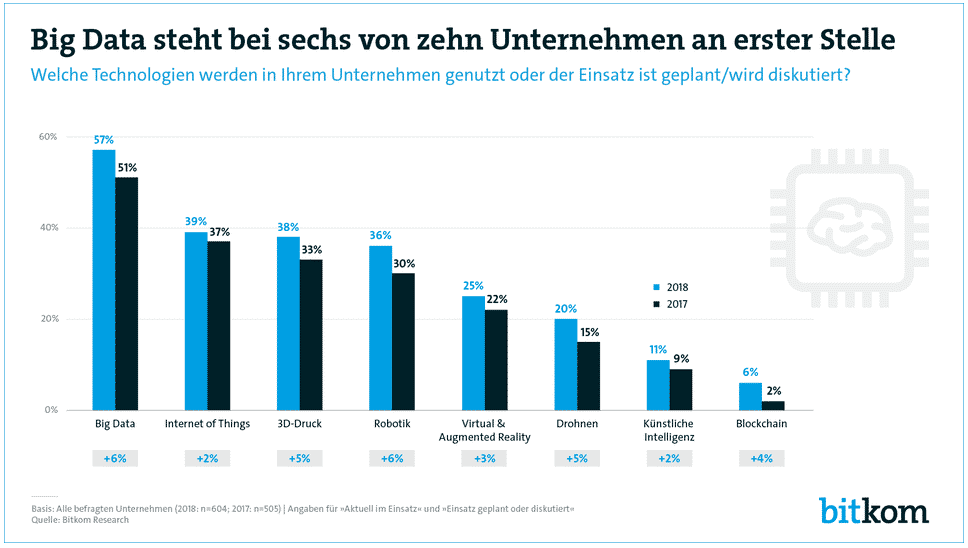

Big Data ist längst aus dem berühmten Hype-Cycle von Gartner verschwunden und gehört vielleicht auch nicht mehr zu den beliebtesten Buzzwords. Dennoch ist es nach wie vor eines der wichtigsten Themen in Data-Science-Projekten. Umso wichtiger ist es, immer wieder nach aktuellen Technologien, den Chancen sowie den Erfolgs- und Risikofaktoren zu fragen. Laut Bitkom priorisieren deutsche Unternehmen das Thema Big Data inzwischen mehrheitlich und stufen es neben Robotics und dem Internet of Things als wichtig für ihre Wettbewerbsfähigkeit ein.

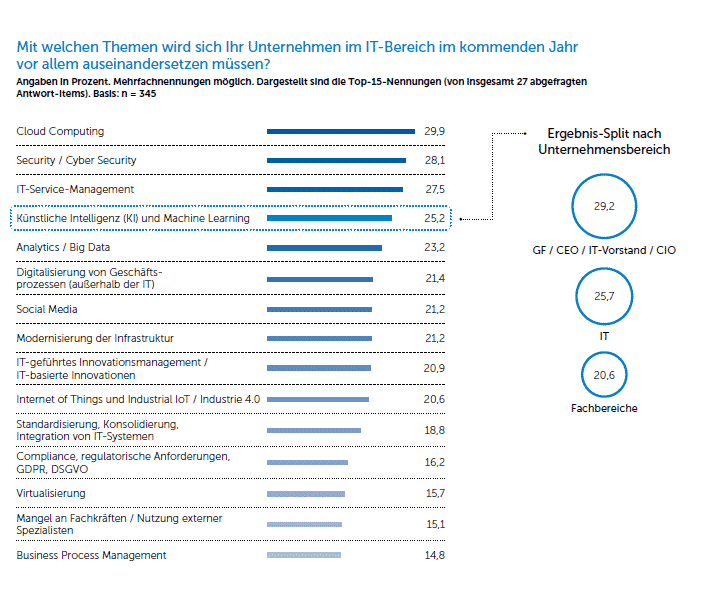

In unserer Machine-Learning-Studie, die wir gemeinsam mit der Computerwoche durchgeführt haben, kommen wir zu einem ähnlichen Ergebnis. Bei unserer Umfrage, bei der auch Mehrfachnennungen möglich waren, landete Big Data auf Platz 5.

Inhaltsverzeichnis

Was ist Big Data?

Eine der einfachsten Definitionen lautet: Big Data sind alle Daten, die größer als eine Excel-Tabelle sind – also mehr als 1.048.576 Zeilen und 16.384 Spalten. In den letzten Jahren hat es sich dann eingebürgert von den verschiedenen „V’s“ zu sprechen, die Big Data definieren. V steht beispielsweise für Velocity, Variety, Volume, Value, Veracity oder Visualization. Die Anzahl der Vs erhöhte sich kontinuierlich von 4, 5, 6 über 10 und 12 bis hin zu 42. Aber was macht Big Data tatsächlich aus? Eine stark vereinfachte Definition von ist: Big Data bedeutet das groß angelegte Erheben, Speichern und Analysieren von Daten.

Viele der Begriffe und Konzepte, die Eingang in die Definition gefunden haben, sind eher Bestandteile von Datenprojekten ganz allgemein. Datenvisualisierungen sind zwar bei Big-Data-Analysen ein wichtiger Aspekt beispielsweise im Rahmen der Visual Data Exploration – spielen aber auch bei Datenprojekten ohne Big Data eine entscheidende Rolle. Insofern müssen alle Definitionsversuche mit einer gewissen Vorsicht betrachtet werden.

Die charakteristischen Merkmale

Einige andere Kennzeichen dienen jedoch ganz klar zur Abgrenzung von Big Data. Beispielsweise spielt der einzelne Datensatz bei Big Data eine untergeordnete Rolle. Vielmehr geht es um Muster und Strukturen, die in den Daten zu finden sind. Big Data besteht in der Regel auch aus unterschiedlichen Datentypen und unstrukturierten Daten. Die aus unserer Sicht wesentlich vier charakteristischen Merkmale sind folgende:

- Die Datenmenge: Wie es das Wort nahe legt, handelt es sich bei zunächst um eine „große“ Menge an Daten(„Volume“). Da Daten einen kleinen Ausschnitt aus der Realität repräsentieren gilt in der Regel: Je mehr Daten zur Verfügung stehen, desto vollständiger ist das Bild, das wir uns damit von der Wirklichkeit machen können.

- Die Datenvarietät: Big Data besteht in den meisten Fällen aus unterschiedlichsten Datentypen und äußerst komplexen Datensätzen („Variety“) – dadurch werden Zusammenhänge und Muster erkennbar. Die Herausforderung besteht darum oft darin, die Daten miteinander in eine sinnvolle Beziehung zu bringen.

- Die Verarbeitungsgeschwindigkeit: Neben der Datenmenge und der Datenvielfalt wird die schnelle Verfügbarkeit von Ergebnissen immer wichtiger. Mit einer entsprechenden Verarbeitungsgeschwindigkeit („Velocity“), die durch viele hundert parallel arbeitende Prozessoren gewährleistet wird, liegen Ergebnisse zum Teil in Echtzeit vor. Wären lediglich herkömmliche Computer am Werk, würde es Tage oder sogar Wochen dauern, bis Ergebnisse von Analysen vorliegen. Die Erkenntnisse wären dann zum großen Teil nutzlos.

- Daten müssen veränderlich sein: Daten werden zum Teil extrem schnell erzeugt – die Turbine eines Windkraftwerks oder eines Flugzeugs, das von Sensoren überwacht wird, liefert pro Stunde bis zu 15 Terabyte an Roh- und Sensordaten. Die Relevanz der Informationen, die aus diesen Daten abgeleitet werden können, verfällt allerdings mit der Zeit („Variability“). Daten müssen darum veränderlich sein bzw. immer wieder neu erhoben werden, um weiterhin relevant zu sein.

Big Data in Datenprojekten

Am Ende des Tages müssen Daten interpretiert und in sinnvolle Handlungskonzepte übersetzt werden. Eine ansprechende, übersichtliche und verständnisfördernde Datenvisualisierung ist dabei ein zentraler Erfolgsfaktor für Data Science Projekte ganz allgemein. Wichtig ist auch das Zusammenspiel der verschiedenen Teilaspekte entscheidend: also wie die Daten kombiniert, ausgewertet und visualisiert werden. Gerade, weil der einzelne Datensatz eine untergeordnete Rolle kommt der Visualisierung zwar eine wichtige Bedeutung zu. Wichtiger sind Visualisierungen aber aus einem anderen Grund.

Die Entscheidung, welche Handlung aus dem Ergebnis von Datenanalysen folgt, trifft in der Regel nicht der Data Scientist. Darum müssen Daten entsprechend in einer für die Entscheider verständlichen Form dargestellt sein. Erst dann entsteht ein Zeit- und Wissensvorteil, aus dem sich ein Handlungsspielraum ergibt: Der Betreiber weiß frühzeitig von einem sich anbahnenden Schaden und kann noch vor dem tatsächlichen Ausfall Gegenmaßnahmen ergreifen.

Unterschiedliche Perspektive

In der Praxis spielen theoretische Versuche der Definition eine untergeordnete Rolle. Viel wichtiger ist die Frage, wer mit Big Data umgeht. Wenn es darum geht, aus Daten einen Mehrwert zu erzeugen, sind die Data Skills und Data Roles ausschlaggebend. Für den Data Engineer sind nur bestimmte, einzelne Aspekte interessant – diese muss er jedoch beherrschen, damit die Daten zur Analyse bereitstehen. Vor allem die Datenqualität steht hier im Zentrum des Interesses.

Für einen Data Scientist ist Big Data ein wichtiger Gegenstand seiner Arbeit. Er untersucht große Datenmengen mit Methoden aus der Mathematik, Statistik und Informatik auf eine bestimmte Fragestellung hin. Das Ziel besteht in der Regel darin, am Ende der Analyse ein Ergebnis zu bekommen, auf das eine Handlungsempfehlung folgt. Diese kann entweder automatisiert ablaufen oder auch eine Entscheidungsgrundlage für Geschäftsentscheidungen sein. Aus der Perspektive der Entscheider wie dem CTO wird wiederum eher aus einem Kosten-Nutzen-Kalkül betrachtet.

Nicht zuletzt gibt es auch noch eine Datenschutz-Perspektive. Die neue DSGVO kennt den Begriff zwar nicht, bestimmte Projekte sind trotzdem davon betroffen. Entscheidend ist hier die Frage, ob ausschließlich Maschinendaten oder auch personenbezogene Daten verarbeitet werden. Eng mit dem Thema Datenschutz verknüpft ist auch die Datensicherheit. Diese Aspekte fallen insgesamt in den Bereich der Data Governance und entscheiden viel eher über den Projekterfolg als eine umfassende Definition des Begriffs Big Data.

Die Erfolgsfaktoren von Big-Data-Projekten

Wir konnten im Rahmen von über 500 erfolgreich durchgeführten Datenprojekten zahlreiche Erfahrungen mit dem Umgang von Big Data sammeln. Dabei konnten wir feststellen, dass es im Wesentlichen vier Faktoren gab, die für das Scheitern von Big-Data-Projekten verantwortlich waren. Das bedeutet umgekehrt, dass auch die Erfolgsfaktoren in diesen vier Bereichen zu verorten sind.

- Data Skills: Eine mangelnde Datenkompetenz in Unternehmen.

- Data Governance: Eine fehlende Verteilung von Verantwortlichkeiten.

- Data Engineering: Unterschätzen des technischen Aufwands

- Data Science: Unrealistische Vorstellung von Möglichkeiten

Methoden, Tools und Technologien

Methoden wie Machine Learning, Supervised Learning, Unsupersived Learning und Deep Learning zählen zu den verbreitetsten und derzeit wichtigsten Methoden bei der Analyse. Die in einem Datenprojekt verwendete Methode hängt sehr stark von der jeweiligen Fragestellung ab. Letzteres ist der eigentliche Fokus, der hier nicht aus dem Blick geraten darf. Ziel bei einem Projekt ist es stets, eine bestimmte Frage zu lösen und nicht zwangsläufig etwas mit Big Data zu machen.

Ein wichtiger technischer Lösungsansatz bei Big-Data-Projekten ist unserer Erfahrung nach der Data Lake. Hier laufen Daten aus allen möglichen Quellen und Kontexten zusammen. Der Data Lake versammelt damit Daten in einer großen Menge und Vielfalt verfügbar. Auch Cloud-Lösungen können aus verschiedenen Gründen einen wichtigen Teilaspekt bei Big-Data-Lösungen darstellen – besonders dann, wenn es um Geschwindigkeit bei der Verfügbarkeit von Daten geht.

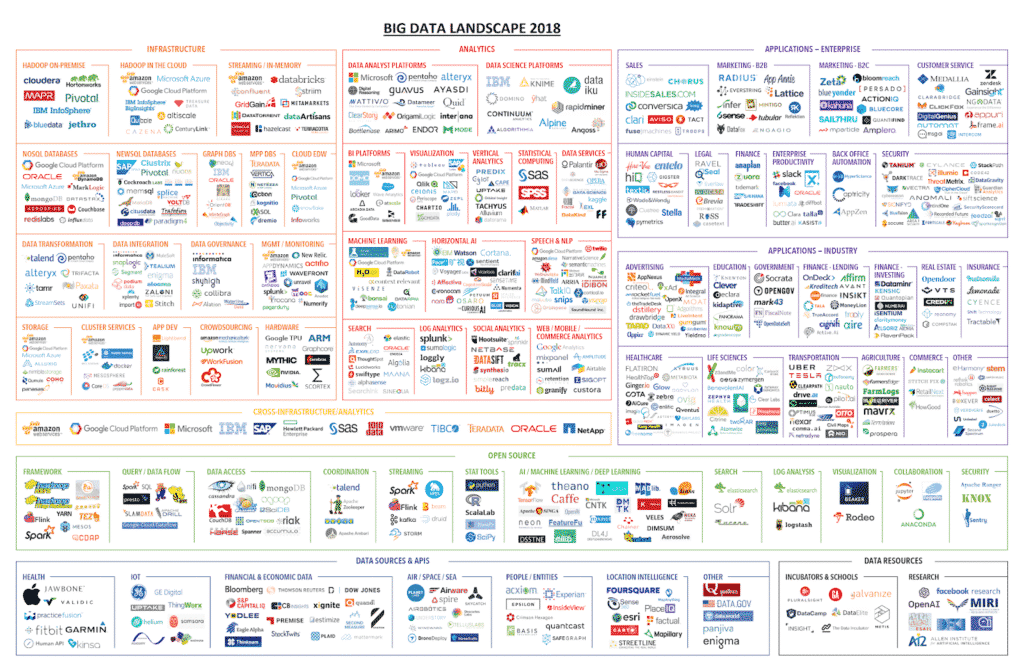

Wenn es jedoch um konkrete Tools und Technologien geht, ist in den letzten Jahren eine nahezu unübersichtliche Situation entstanden. Die folgende Grafik zeigt die Vielzahl an Big-Data-Lösungen, die in den unterschiedlichen Bereichen entstanden sind. Welche Technologie und welches Tool im Einzelfall zum Einsatz kommt, hängt von verschiedenen Faktoren und letztlich den Fähigkeiten und der Erfahrung der Data Scientists ab.

Vom Buzzword zum Standard

Die Entwicklung, die sich in den letzten Jahren vollzogen hat und sich in dieser Marktübersicht spiegelt, zeigt eindeutig, dass sich Big Data längst von der anfänglichen Hype-Phase emanzipiert hat. Vielmehr handelt es sich heute um einen neuen Industrie-Standard, der zu einem wesentlichen Bestandteil in der Wertschöpfungskette geworden ist. Angesichts des zum Teil hohen finanziellen Aufwandes, der mit dem Daten Management verbunden ist, ist es heute wichtiger denn je, aus Daten einen Mehrwert zu generieren. Wir nennen das: Data2Value.

0 Kommentare