Deep Learning: Kompakt erklärt

- Veröffentlicht:

- Autor: [at] Redaktion

- Kategorie: Grundlagen

Inhaltsverzeichnis

Künstliche Intelligenz (KI) hat in den letzten Jahren einen deutlichen Popularitätsschub erlebt. Doch hinter diesem Hype steckt – zumindest zum Teil – eine besonders leistungsfähige Form des maschinellen Lernens: das sogenannte Deep Learning.

In diesem Artikel geben wir Ihnen einen Einblick in diesen Teilbereich des maschinellen Lernens: Wir erklären, was Deep Learning ist, welche grundlegenden Modelle und Architekturen dahinterstehen und wofür es eingesetzt wird.

Was ist Deep Learning?

Deep Learning ist ein Teilbereich des Machine Learning, bei der künstliche neuronale Netze verwendet werden, um Modelle zu erstellen und komplexe Muster in Daten zu erkennen.

Im Gegensatz zum traditionellen Machine Learning, bei dem oft komplizierte Feature Engineering-Verfahren erforderlich sind, ist Deep Learning viel besser darin, Merkmale automatisch zu lernen und Muster in Rohdaten zu finden. Dadurch eignet sich Deep Learning besonders für Aufgaben, bei denen große Mengen unstrukturierter Daten wie Text, Audio und Bilder vorliegen.

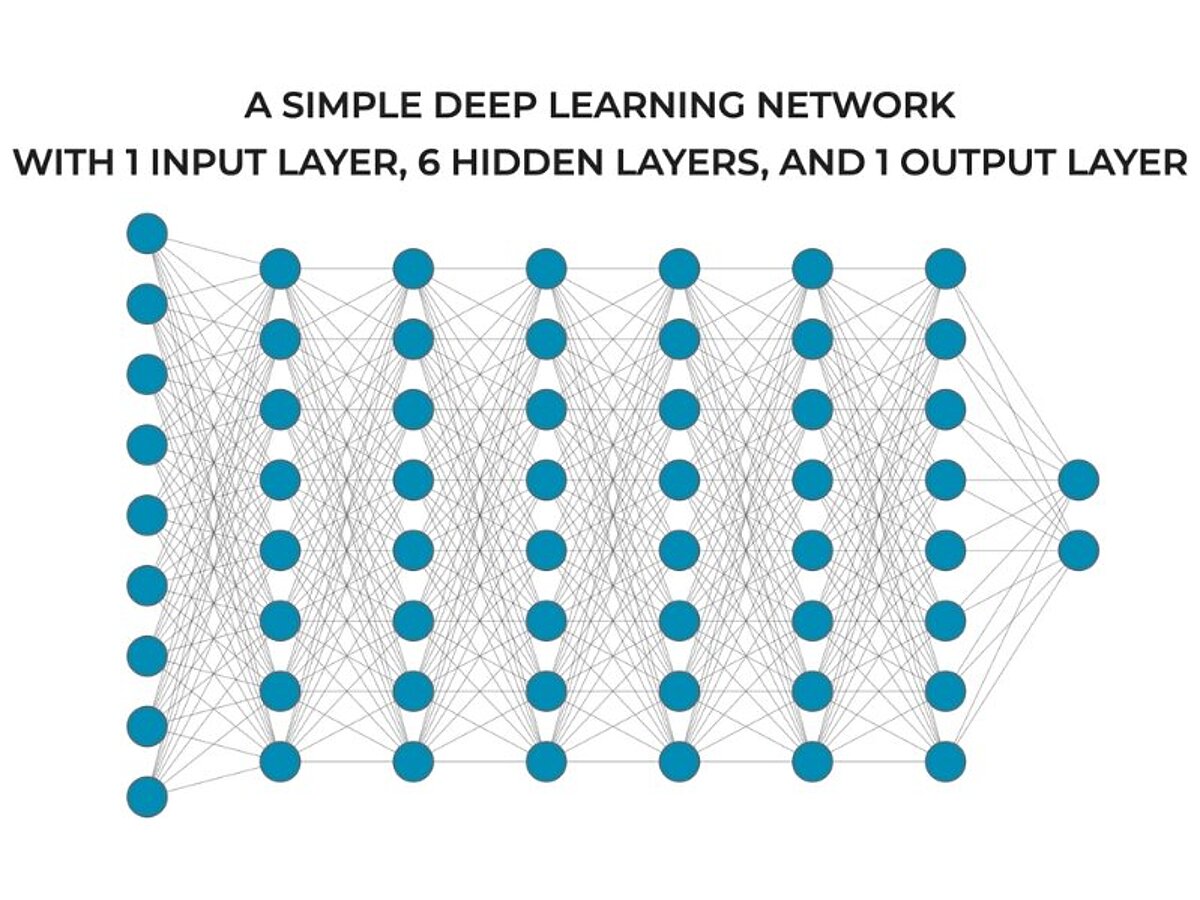

Der Kern des Deep Learning besteht darin, künstliche Neuronen, auch Knoten genannt, zu großen Netzwerken mit vielen Schichten zu verbinden, wobei jede Schicht viele Knoten hat. Diese Struktur aus mehreren Schichten mit mehreren künstlichen Neuronen ermöglicht es tiefen neuronalen Netzwerken, Daten hierarchisch zu verarbeiten, wobei die unteren Schichten allgemeinere Muster in den Daten lernen und die oberen Schichten nuancierte und abstraktere Muster lernen.

Diese hierarchische Datenverarbeitung ermöglicht es tiefen neuronalen Netzwerken, viel komplexere Muster in großen Datensätzen zu lernen. Und tatsächlich gilt: Je mehr Schichten ein tiefes Netzwerk hat, desto komplexere Muster kann es entdecken. Daher stammt auch das Wort „deep“ im Namen: Sie sind „tief“, weil sie aus vielen Schichten bestehen. Tiefe neuronale Netze zeichnen sich in einer Vielzahl von Bereichen wie der Verarbeitung natürlicher Sprache (NLP), dem maschinellen Sehen und autonomen Systemen aus. Tatsächlich bildet Deep Learning die Grundlage vieler moderner KI-Systeme wie ChatGPT und ähnlicher generativer Textsysteme sowie autonomer Fahrzeuge.

Doch trotz der Leistungsfähigkeit dieser Technik gibt es auch Herausforderungen. Deep Learning erfordert in der Regel sehr große Datensätze während des Trainings sowie enorme Rechenressourcen. Diese Daten- und Rechenanforderungen sind oft sehr kostspielig.

Unterschiede von Deep Learning, künstlicher Intelligenz und Machine Learning

Künstliche Intelligenz (KI) ist der Oberbegriff für alle Systeme, die versuchen, menschliche Intelligenz nachzubilden – etwa beim Lernen, Schlussfolgern oder Problemlösen.

Machine Learning (ML) ist ein Teilbereich davon: Hier lernen Systeme, indem sie mit Daten trainiert werden und so ihre Leistung bei bestimmten Aufgaben verbessern.

Deep Learning (DL) ist wiederum ein spezieller Ansatz innerhalb des Machine Learning. Er nutzt tiefe neuronale Netze, um sehr komplexe Muster in großen, meist unstrukturierten Datenmengen zu erkennen – z. B. bei Sprachverarbeitung oder autonomem Fahren.

Im Vergleich zu traditionellen ML-Verfahren kann Deep Learning solche hochkomplexen Aufgaben deutlich besser bewältigen – vorausgesetzt, es stehen genug Daten und Rechenleistung zur Verfügung.

Unterschiede von Deep Learning und Reinforcement Learning

Deep Learning und Reinforcement Learning sind zwei verschiedene Werkzeuge im Machine-Learning-Ökosystem. Wie oben erwähnt, verwendet Deep Learning eine Architektur aus tiefen Neuronen-Stacks, die es Deep-Learning-Modellen letztendlich ermöglicht, komplexe Muster in großen Datensätzen zu lernen.

Reinforcement Learning hingegen ist eine Technik, mit der wir Machine-Learning-Systeme anhand von Rückmeldungen aus einer Umgebung (z. B. einer realen Umgebung, einer digitalen „Umgebung“ usw.) trainieren. Beim Reinforcement Learning lernt das System im Laufe der Zeit, bessere Vorhersagen zu treffen, indem es durch einen Prozess von Versuch und Irrtum, der Interaktion mit der Umgebung, Belohnungen und Strafen erhält.

Während Deep Learning also am besten als Machine-Learning-Architektur verstanden wird, lässt sich Reinforcement Learning am besten als Trainingsparadigma verstehen. Allerdings gibt es eine Art des maschinellen Lernens, das als „Deep Reinforcement Learning“ bezeichnet wird und diese beiden Methoden kombiniert.

Deep-Learning-Modelle und -Architekturen

Obwohl Deep Neural Networks im weitesten Sinne Netzwerke aus künstlichen Neuronen sind, die in einer hierarchischen Struktur organisiert sind, gibt es tatsächlich eine Vielzahl spezifischer Architekturen für Deep Networks. Und diese unterschiedlichen Architekturen haben unterschiedliche Funktionen.

Die vier wichtigsten Architekturen sind:

- Vanilla Deep Feedforward Networks

- Convolutional Neural Networks

- Recurrent Neural Networks

- Transformatoren

Vanilla Deep Feedforward Networks

Ein Vanilla Deep Feedforward Network ist das traditionellste tiefe neuronale Netzwerk. Diese Netzwerke bestehen aus mehreren Schichten von Neuronen, und in dieser Architektur fließen die Informationen nur in eine Richtung: von den unteren Schichten zu den oberen Schichten.

In einem Vanilla Deep Network ist jedes Neuron einer Schicht auch mit jedem Neuron der nächsten Schicht verbunden, sodass diese Netzwerke „vollständig verbunden“ sind. Vanilla Deep Networks sind äußerst vielseitig und können mit wenigen Modifikationen eine Vielzahl von Aufgaben wie Klassifizierung, Regression, Anomalieerkennung und Feature Extraction ausführen.

Wichtig ist, dass Vanilla-Deep-Feedforward-Netzwerke, wenn sie allein verwendet werden, in der Regel mit strukturierten Daten (d. h. tabellarischen Daten) arbeiten, aber wir können sie auch als Komponenten in anderen Architekturen (wie der unten beschriebenen Transformer-Architektur) verwenden.

Convolutional Neural Networks

Convolutional Neural Networks (CNNs) verwenden Schichten von Neuronen, um räumliche Muster zu erkennen, typischerweise in gitterartigen Daten wie Bildern.

Die ersten Schichten eines CNN identifizieren in der Regel einfache Muster wie Linien mit einer bestimmten Ausrichtung, Ecken und andere räumliche Merkmale. Wenn wir die Schichten jedoch in Stapeln organisieren, sind Convolutional Neural Networks in der Lage, komplexere Muster zu erkennen.

Aufgrund ihrer Nützlichkeit bei Bilddaten verwenden wir CNNs häufig für Aufgaben wie Bildklassifizierung, medizinische Bildgebung und Objekterkennungssysteme.

Rekursive neuronale Netze

Wir verwenden rekurrenten neuronalen Netze (RNNs) für sequenzielle Daten wie Zeitreihendaten und Textdaten. Bei dieser Art von Daten ist die Reihenfolge (d. h. die Sequenz) der Daten von Bedeutung, und Daten an einem bestimmten Punkt können stark von Daten an einem früheren Punkt in der Sequenz abhängen (wiederum wie bei Textdaten).

Um diese Art von sequenziellen Daten mit zeitlichen Abhängigkeiten zu verarbeiten, enthalten rekurrenten neuronalen Netzen rekurrenten Verbindungen rückwärts zu vorherigen Schritten im Netzwerk und andere Arten von Rückkopplungsschleifen. Diese Rückkopplungsverbindungen ermöglichen es dem Modell, Abhängigkeiten und Beziehungen zwischen sequenziellen Datenbeispielen zu lernen.

Spezielle RNN-Varianten wie Long Short-Term Memory-Netzwerke (LSTM) und Gated Recurrent Units (GRU) sind so strukturiert, dass sie Probleme in einfachen rekurrenten neuronalen Netzen, wie z. B. verschwindende Gradienten, beheben.

Die Fähigkeit von RNNs, Abhängigkeiten in sequenziellen Daten zu modellieren – die sich aus der rekurrenten Struktur ergeben – macht sie sehr nützlich für Aufgaben wie die Verarbeitung natürlicher Sprache und die Finanzmodellierung.

Transformatoren

Die Transformer-Architektur ist zum Zeitpunkt der Erstellung dieses Artikels eine der wichtigsten Architekturen im Machine Learning, da Transformers die Grundlage für GPT-Systeme und moderne generative Textmodelle bilden.

Wie RNNs funktionieren Transformers besonders gut mit sequenziellen Daten, insbesondere mit Textdaten. Transformers ersetzen jedoch die rekurrenten Strukturen von RNNs durch eine spezielle Architektureinheit, die sogenannte Attention Unit.

Die Attention-Einheit (auch bekannt als Attention-Mechanismus) von Transformern ist auf das Lernen kontextueller Beziehungen zwischen Elementen in einer Sequenz spezialisiert. Wenn sie in einer größeren Transformer-Architektur (die auch andere Einheiten wie Deep Feedforward Networks umfasst) organisiert und mit sehr großen Datenmengen trainiert werden, ermöglicht Self-Attention Transformern das Erlernen komplexer grammatikalischer Beziehungen in Textdaten, wodurch Transformers wiederum menschliche Sprache verstehen und generieren können.

Daher eignen sich Transformers besonders gut für Aufgaben der natürlichen Sprachverarbeitung (Natural Language Processing, NLP) wie Frage-Antwort-Spiele, Textzusammenfassungen, Textgenerierung und Übersetzungen.

Andere Architekturen

Obwohl die oben beschriebenen Architekturen zu den wichtigsten Deep-Learning-Architekturen zählen, gibt es viele andere Architekturen, die tiefe Netzwerke verwenden, darunter generative gegnerische Netzwerke, grafische neuronale Netzwerke, Kapselnetzwerke und viele mehr.

Vorteile und Herausforderungen

Deep Learning ist ein leistungsstarkes Werkzeug zur Lösung einer Vielzahl von Aufgaben, aber obwohl es gegenüber anderen Techniken eine Reihe von Vorteilen bietet, hat es auch Schwächen.

Vorteile von Deep Learning

Schauen wir uns zuerst an, was Deep Learning so leistungsfähig, und in vielen Fällen anderen Ansätzen überlegen, macht.

Automatisierte Feature Extraction

Deep-Learning-Modelle sind in der Lage, komplexe Merkmale automatisch aus rohen Eingabedaten zu lernen.

Dadurch kann manuelles Feature Engineering entfallen, was besonders bei unstrukturierten Datentypen wie Text, Audiodateien und Bilddaten von Vorteil ist.

Hohe Leistung bei komplexen Aufgaben

Deep-Learning-Modelle erzielen oft eine hohe Leistung bei komplizierten oder schwierigen Aufgaben wie Bilderkennung, Spielen und NLP.

Diese hohe Leistung bei schwierigen Aufgaben ergibt sich aus der Fähigkeit von Deep-Learning-Modellen, komplexe oder nicht lineare Beziehungen in Eingabedatensätzen zu modellieren.

Skalierbarkeit mit großen Datensätzen

Deep-Learning-Systeme verbessern oft ihre Leistung, wenn sie die Größe des Datensatzes erhöhen (d. h. mehr Beispiele). Dies macht sie besonders nützlich in Bereichen mit hohen Datenmengen.

Darüber hinaus wird diese Skalierbarkeit durch Fortschritte in der Rechenhardware, wie TPU- und GPU-Prozessoren, weiter unterstützt.

Vielseitigkeit in verschiedenen Bereichen

Deep Learning ist vielseitig einsetzbar und kann in einer Vielzahl von Bereichen wie Gesundheitswesen, Robotik, Linguistik, Unterhaltung und Finanzen eingesetzt werden.

Diese Vielseitigkeit wird durch spezialisierte Architekturen für bestimmte Arten von Aufgaben und Datentypen noch erweitert, wie oben erwähnt, beispielsweise durch Convolutional Neural Networks für Bilddaten.

Herausforderungen des Deep Learning

Doch obwohl Deep Learning viele Stärken hat, bringt es auch einige inhärente Herausforderungen und Schwächen mit sich.

Hohe Rechenanforderungen

Das Training von Deep-Learning-Systemen erfordert oft erhebliche Rechenleistung, Speicherplatz und andere Hardware. Beispielsweise erfordert das Training tiefer neuronaler Netze oft teure GPUs und viel RAM.

Die Kosten für einen Teil dieser Hardware (insbesondere jetzt, wo generative KI immer beliebter wird) können für Unternehmen mit begrenzten finanziellen Ressourcen eine Hürde darstellen.

Bedarf an großen Datensätzen

Obwohl Deep-Learning-Systeme komplexe Beziehungen in Eingabemerkmalen lernen können, sind dafür in der Regel große, beschriftete Datensätze während des Trainingsprozesses erforderlich.

Diese großen Datensätze können schwer zu beschaffen sein, und die Beschriftung dieser Datensätze stellt oft eine zusätzliche Herausforderung dar.

Das Training tiefer neuronaler Netze mit kleinen Datensätzen kann zu Überanpassung und schlechter Leistung bei den Modellmetriken führen.

Schwierig zu interpretieren

Es ist oft schwierig, wenn nicht sogar unmöglich, genau zu wissen, wie Deep-Learning-Systeme ihre Eingabedaten verarbeiten; sie werden in der Regel als „Black Boxes“ betrachtet. Dies steht im Gegensatz zu Systemen, die leicht zu interpretieren sind (wie Entscheidungsbäume).

Die Schwierigkeit, diese Systeme zu interpretieren, kann in Situationen, in denen es wichtig ist, die Funktionsweise des Systems erklären zu können, zu Herausforderungen führen. Dies kann sogar zu rechtlichen Problemen führen, wenn unklar ist, ob das Modell Daten in einer Weise verarbeitet, die gegen bestimmte Gesetze verstößt (z. B. Gesetze gegen finanzielle Diskriminierung in den USA).

Risiko der Überanpassung

Die Fähigkeit, komplexe Muster zu lernen, birgt naturgemäß ein Risiko.

Je höher die „Kapazität“ eines Modells (d. h. die Fähigkeit, komplexe Beziehungen zu modellieren), desto größer ist das Risiko einer Überanpassung.

Dieses Risiko steigt, wenn Sie Deep-Learning-Systeme mit kleinen Datensätzen oder unausgewogenen Daten trainieren. Aufgrund dieses Risikos der Überanpassung müssen Deep-Learning-Anwender diese Modelle oft mit großer Sorgfalt trainieren und häufig Regularisierungstechniken sowie eine sorgfältige Modellvalidierung einsetzen.

Anwendungen und Einsatzmöglichkeiten von Deep Learning

Deep Learning ist eine leistungsstarke Machine-Learning-Technik mit einem breiten Spektrum an Einsatzmöglichkeiten und Anwendungen.

Computer Vision

Deep Learning hat eine Revolution in einer Vielzahl von Aufgaben der Computer Vision ausgelöst, darunter Gesichtserkennung, Objekterkennung und Bildklassifizierung.

Insbesondere Convolutional Neural Networks (oben beschrieben) sind in der Lage, Bilder mit sehr hoher Genauigkeit zu verarbeiten und zu klassifizieren, was komplexere Anwendungen wie medizinische Bildgebung und Diagnostik sowie autonome Fahrzeuge ermöglicht.

Natürliche Sprachverarbeitung (NLP)

Tiefe neuronale Netze haben auch die Verarbeitung natürlicher Sprache revolutioniert, da tiefe Netze das Rückgrat der meisten modernen NLP-Systeme bilden.

Diese auf Deep Learning basierenden NLP-Systeme (einschließlich BERT und der Transformer-Architektur) sind in der Lage, komplexe Aufgaben wie Sprachübersetzung, Textgenerierung, Sentimentanalyse und vieles mehr zu übernehmen.

Die Leistungsfähigkeit dieser neuen Deep-Learning-basierten NLP-Systeme ermöglicht wiederum eine Vielzahl von Anwendungen höherer Ordnung wie Chatbots, virtuelle Assistenten, KI-Agenten und verbesserte Suchfunktionen.

Autonome Systeme

Neue Drohnensysteme und autonome Fahrzeuge nutzen häufig Deep Learning, um die Daten von Bordsensoren zu verarbeiten und so in Echtzeit Entscheidungen über den Betrieb zu treffen.

Diese Systeme nutzen Deep Learning auf vielfältige Weise, beispielsweise für Computer Vision, Objektverfolgung und Bahnvorhersagen. Dadurch können autonome Systeme in komplexen Umgebungen navigieren und Entscheidungen treffen.

Darüber hinaus finden diese autonomen Systeme in Branchen wie Transport, Landwirtschaft und Logistik Anwendung.

Predictive Analytics und Empfehlungssysteme

In den Bereichen Wirtschaft, Unterhaltung und Gesundheitswesen können Deep-Learning-basierte Systeme Benutzerdaten verarbeiten und hochgradig personalisierte Empfehlungen geben.

Beispielsweise verwenden Plattformen wie Amazon, Netflix und Spotify Deep-Learning-basierte Systeme, um die besten Inhalte für ihre Nutzer zu empfehlen. Dies wiederum erhöht die Nutzerinteraktion und steigert den Umsatz.

Weitere Anwendungen

Deep Learning hat eine Vielzahl weiterer Anwendungsmöglichkeiten in Bereichen wie Finanzen (Betrugserkennung), generative KI für Unterhaltung, Spracherkennung und -synthese und vielen anderen Bereichen.

Darüber hinaus handelt es sich um ein sich ständig weiterentwickelndes Gebiet, in dem regelmäßig neue Anwendungsmöglichkeiten entdeckt und geschaffen werden.

Fazit

Deep Learning hat das maschinelle Lernen in vielerlei Hinsicht auf ein neues Level gehoben – vor allem dort, wo es um komplexe Muster in großen, unstrukturierten Datensätzen geht. Die Technologie steckt hinter vielen der derzeit fortschrittlichsten KI-Systeme, etwa in der Sprachverarbeitung oder bei generativer KI.

Trotz beeindruckender Leistungen bleibt Deep Learning aber kein Allheilmittel: Der Aufwand für Daten, Rechenleistung und Modellpflege ist hoch – und die Risiken, etwa durch Überanpassung, real. Die Methode ist also stark, aber nicht ohne Herausforderungen.

Diesen Beitrag teilen: