Im Jahr 2022 feiern wir das 10-jährige Jubiläum von [at] – Alexander Thamm.

2012 waren wir die erste Beratung im deutschsprachigen Raum, die sich Data & AI auf die Fahne geschrieben hat. Heute lässt sich sagen, künstliche Intelligenz (KI) hat das Potential, einen wichtigen Beitrag bei einigen der großen wirtschaftlichen und gesellschaftlichen Herausforderungen unserer Zeit zu leisten. KI spielt eine Rolle bei der Energiewende und bei der Reaktion auf den Klimawandel, beim autonomen Fahren, bei der Erkennung und Behandlung von Krankheiten oder der Pandemiebekämpfung. KI steigert die Effizienz von Produktionsprozessen und erhöht die Anpassungsfähigkeit von Unternehmen auf Marktveränderungen durch Echtzeitinformationen sowie Vorhersagen.

Die wirtschaftliche Bedeutung der Technologie steigt rasant an. Mittlerweile nutzen mehr als zwei Drittel der deutschen Unternehmen künstliche Intelligenz und Machine Learning (ML).

Mit unseren #AITOP10 zeigen wir euch, was gerade im Bereich Data & AI angesagt ist. Unsere TOP10-Listen präsentieren Podcast-Highlights, industriespezifische KI-Trends, KI-Experten, Tool-Empfehlung und vieles mehr. Hier bekommt ihr einen breiten Querschnitt über das Data & AI-Universum, das uns seit nunmehr 10 Jahren antreibt.

Inhaltsverzeichnis

Unsere Top 10 ML-Algorithmen – Part 1

Recommender, Clustering, Regression, Text Analytics, Anomaly Detection… Machine Learning kann heute für vielfältige Problemstellungen eingesetzt werden und ist dabei schneller und genauer denn je. Aber was hat es mit den Algorithmen dahinter auf sich? Wir schauen hinter die Kulissen und zeigen euch, welche Algorithmen beim Machine Learning wirklich zum Einsatz kommen.

Platz 10 – Lineare Regression

Lineare Regression ist eine der einfachsten Machine Learning (ML) Algorithmen und kinderleicht zu verstehen. Beispiel: Wer einen Baum pflanzt, tut was Gutes für die Umwelt. Leider dauert es eine Weile, bis aus einem kleinen Samen ein ausgewachsener Baum wird. Um das zu dokumentieren, wird in unserem Beispiel jeden Monat die Baumhöhe gemessen. Das funktioniert zwar in den ersten zwei Jahren gut, irgendwann kommt aber selbst der Größte nicht mehr mit dem Maßband an die Baumspitze. Hier kommt die lineare Regression ins Spiel: Da wir die bereits gemessenen Höhen in ein Diagramm eingetragen haben, können wir die zukünftige Höhe des Baumes zu jedem Zeitpunkt relativ genau schätzen. Haben wir die Höhe das letzte Mal vor einem Monat messen können, ziehen wir durch alle bisher gemessenen Punkte eine Gerade und verlängern diese noch ein Stück weiter. Nun lässt sich je nach durchschnittlicher Abweichung ziemlich genau die aktuelle Baumhöhe für diesen Monat bestimmen.

Lineare Regression zeigt den Zusammenhang zwischen einer unabhängigen Variable (in diesem Fall der Zeit) und einer abhängigen Variable (der Höhe des Baumes). Oft sind aber mehrere unabhängige Variablen vorhanden, mithilfe derer eine Vorhersage getroffen werden soll. Dazu eignet sich die multiple lineare Regression. Das Funktionsprinzip bleibt gleich, jedoch werden mehrere Dimensionen verwendet, um eine Vorhersage zu treffen. In unserem Beispiel wären das beispielsweise zusätzlich zur Zeit die Temperatur. Steigt die Temperatur, wächst der Baum schneller, sinkt sie, wächst er langsamer.

Wichtig dabei ist aber, dass ein linearer Zusammenhang zwischen den unabhängigen Variablen (Zeit, Temperatur) und der abhängigen Variable (Höhe des Baumes) gibt. Besteht der Zusammenhang nicht, macht lineare Regression keinen Sinn und wir ermitteln hier Zufallszahlen. Die Fehlerrate der Werte sollte annähernd normalverteilt sein. Sind die Werte kreuz und quer verstreut, wird das Festlegen einer passgenauen Regressionslinie (Ausgleichsgerade) schwierig. Zuletzt sollte die unabhängigen Werte nicht voneinander abhängig sein. Die Sonnenstunden sind beispielsweise von der variable Temperatur abhängig und eignen sich daher nicht für die multiple lineare Regression.

Sinnvoll ist der Einsatz von (multipler) linearer Regression beispielweise beim Forecasting von Markttrends, Preisentwicklungen sowie der Risikobewertung in der Finanz- und Versicherungsbranche.

Platz 9 – Logistische Regression

Nicht immer muss ein konkreter Zahlenwert vorhergesagt werden, oft geht es auch um die Klassifizierung von Daten. Damit gemeint ist die Vorhersage der Kategorie einer Variable mithilfe von gegebenen unabhängigen Variablen. Beispiel: Ernährung, Sport und Gesundheit spielen heute eine große Rolle. Wer sich gesund ernährt und viel Sport treibt, dem wird ein längeres Leben, gute Gesundheit und ein niedrigeres Risiko einen Herzinfarkt zu erleiden. Aber stimmt das wirklich?

Möchte ich vorhersagen, ob ich innerhalb der nächsten 10 Jahre einen Herzinfarkt erleiden werde, kann ich mehrere Werte für die Vorhersage nutzen: Was ist mein BMI (Body-Mass-Index)? Habe ich Vorerkrankungen? Wie ist mein Blutdruck? Alles Werte, durch die ich mehr oder weniger genau meinen Gesundheitsstatus beschreiben kann. Durch logistische Regression kann man eine Vorhersage treffen, ob in den nächsten 10 Jahren einen Herzinfarkt wahrscheinlich ist. Aber wie?

Zunächst benötigt man einen Datensatz, in dem all diese Daten vorhanden sind (BMI, Blutdruck, Alter, Vorerkrankungen, Blutdruckwerte). Um ein ML-Modell zu trainieren, muss außerdem in den Trainingsdaten die Information enthalten sein, ob innerhalb der nächsten 10 Jahre ein Herzinfarkt eintrat. Beim Training wird eine Kurve ermittelt, die bestimmt, in welche Kategorie Daten eingeordnet werden können. Im Gegensatz zu linearer Regression sagt die logistische Regression also keine Zahlenwerte vorher, sondern klassifiziert Datensätze in 2 Kategorien: Ja und Nein, Herzinfarkt oder kein Herzinfarkt. Sind Werte wie Blutdruck, BMI oder Cholesterin über oder unter einem bestimmten Level, behauptet das Modell, dass der Patient in den nächsten 10 Jahren einen Herzinfarkt erleidet. Aber wie genau ist diese Vorhersage?

Das gute an logistischer Regression ist, dass eine Aussage über die Genauigkeit der Vorhersage getroffen werden kann. So bestimmt die bereits erwähnte Kurve die Grenze: Herzinfarkt/kein Herzinfarkt. Zusätzlich ermittelt das Modell die Wahrscheinlichkeit der Vorhersage. Liegen die Werte beispielsweise nah an der Grenze, ist die Wahrscheinlichkeit lediglich knapp über oder unter 50%. Andersherum liegt sie je nach Genauigkeit des Modells bei knapp über 0% oder knapp unter 100%.

Daher liefert die logistische Regression niemals eindeutige Werte, lediglich probabilistische Werte. Das bedeutet in der Praxis: Eine Person mit einem BMI von 50 wird zu 84% einen Herzinfarkt innerhalb der nächsten 10 Jahre erleiden. Nicht zu verwechseln ist dieser Wert mit der Accuracy des gesamten Modells. Diese kann durch Einbeziehung weiterer für die Ausgangsgröße wichtige Werte oder Anpassung des Modells erhöht werden.

Genutzt wird der Algorithmus im Credit Scoring, in der Medizinforschung und Erkrankungsvorhersage oder auch für die Betrugserkennung in der Finanz- und Versicherungsbranche. Insgesamt ist logistische Regression ein effektiver Algorithmus für ganz unterschiedliche Fälle von Klassifizierung.

Platz 8 – Entscheidungsbäume

Was hat Machine Learning mit Bäumen zu tun? Mehr als man denkt! Um beim Beispiel zu bleiben: Wie kann man vorhersagen, ob ein Baum Früchte trägt? Mit einem Entscheidungsbaum.

Hat man eine Tabelle gefüllt mit verschiedenen Attributen von Bäumen, kann man daraus einen Entscheidungsbaum erstellen. Angefangen bei der Wurzel, fragt man bei jeder Gabelung nach dem Wert eines Baums-Attributs und geht dann zur nächsten Gabelung. Am Ende gibt einem der Baum jeweils die Antwort 0 oder 1, ja oder nein. An der ersten Gabelung steht beispielsweise die Frage “Ist der Baum tot?”. Ist das Attribut der Spalte “lebendig” (= nein), ist die Vorhersage beendet: Der Baum wird keine Früchte tragen. Andersrum geht es weiter: „Wie groß ist der Baum?“. Ist die Größe des Baums unter einem bestimmten Schwellwert, trägt er keine Früchte und die Antwort ist wiederum “nein”. Falls doch, geht der Entscheidungsbaum immer eine Gabelung weiter, bis das Ende des letzten Astes und damit die abschließende Vorhersage “ja” oder “nein” getroffen wird.

Entscheidungsbäume werden in der Kundenaquise zur Identifizierung potenzieller Kunden oder zur Bestimmung der Kreditwürdigkeit in der Finanzbranche verwendet. Sie sind einfach zu lesen und zu interpretieren und können auf nicht-lineare Daten angewendet werden. Ein weiterer Vorteil ist, dass die Daten meist wenig Vorbereitung und Bereinigung benötigen, weil Ausreißer und fehlende Daten einen geringen Einfluss auf die Vorhersagegenauigkeit haben. Dafür sind sie weniger effektiv in der Vorhersage von kontinuierlichen Variablen, weil durch das Kategorisieren eine Variable Informationen verloren gehen.

Platz 7 – Random Forest

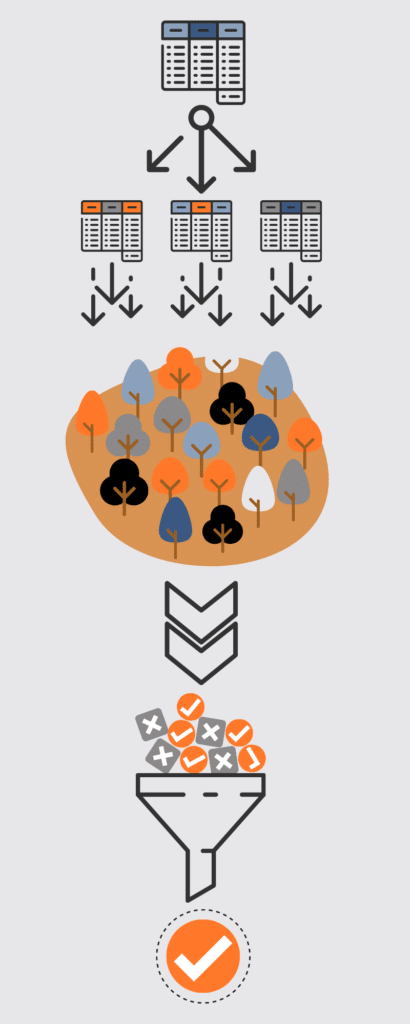

Gerade wenn man wichtige Entscheidungen trifft, fragt man oft seine Freunde, Verwandte oder Kollegen um Rat. Dabei beschränkt man sich selten auf eine Person, sondern fragt mehrere, um diverse und vielleicht auch unterschiedliche Antworten zu bekommen. Ganz ähnlich funktioniert der Random Forest Algorithmus. Dabei nutzt der Random Forest Algorithmus Entscheidungsbäume – nicht nur einen, sondern gleich einen ganzen Wald.

Wie auch bei einer wichtigen persönlichen Entscheidung, kennen sich unterschiedliche Vertrauenspersonen mit unterschiedlichen Aspekten der Entscheidung aus. Beim Random Forest Algorithmus werden analog dazu Entscheidungsbäume mit unterschiedlichen, neu zusammengefügten Teilen des Datensatzes generiert. Das nennt man Bagging oder auch Bootstrap Aggregation. Wichtig ist, dass sich dadurch kein Entscheidungsbaum doppelt, sondern jeweils einen anderen Teil des gesamten Datensatzes repräsentiert.

Zuletzt kommt man nach Rücksprache auf einen Konsens: Beim Random Forest Algorithmus passiert das ganz demokratisch. Die Vorhersage wird aufgrund des Votings aller Entscheidungsbäume generiert. Stimmen 3 mit “ja” und 2 mit “nein”, lautet die Entscheidung also “ja”. Wenn das Ziel der Vorhersage keine Klassifikation, also ein Wahrheitswert, sondern ein Zahlenwert sein werden soll, wird der Durchschnittswert aller Bäume genommen.

Der Algorithmus findet Anwendung in den verschiedensten Feldern: Im Finanzsektor kann Random Forest zur Identifizierung von Zahlungsbetrug oder zum Kredit-Scoring verwendet werden; in der Medizin zur Identifizierung von Krankheiten aufgrund der Krankenakte oder Vorhersage der Arzneimittelempfindlichkeit. Der Algorithmus kann also für vielfältige Klassifikations- und Regressionsprobleme benutzt werden.

Platz 6 – K-Means

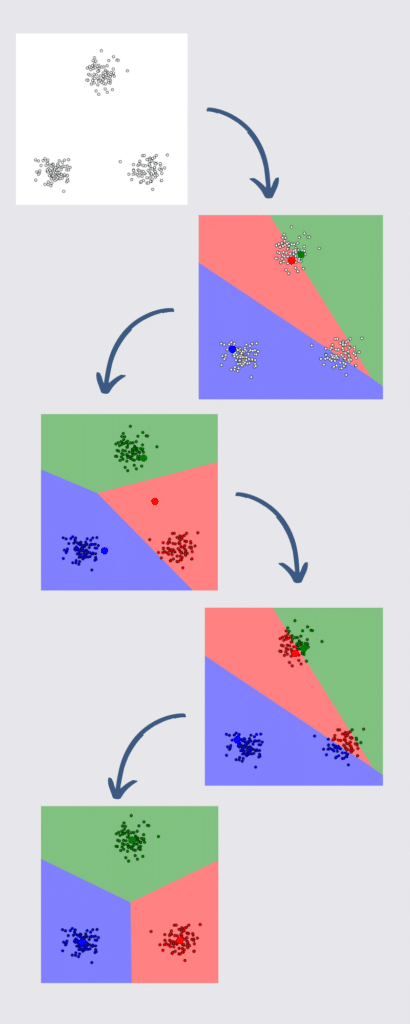

Wer eine neue Filiale seiner Pizzeria aufmachen möchte, muss sich zunächst überlegen wo. Dafür eignet sich der Clustering-Algorithmus K-Means hervorragend. Möchte man beispielsweise in ein neues Stadtviertel expandieren und dort 2 Filialen eröffnen, so kann man dafür die bestehenden Daten über die Orte der Bestellungen aus diesem Viertel nutzen. Das minimiert die Lieferwege und ermöglicht später Vorhersagen darüber, zu welchem der beiden Restaurants ein möglicher Kunde nach Standort geht.

Zunächst zeichnet man auf einer Karte alle Datenpunkte auf und platziert zusätzlich dazu 2 (für k=2 bzw. 2 Fililalen) sogenannte Zentroide auf zwei zufällige Punkte der Karte. Jetzt werden alle Punkte dem jeweilig nächsten Zentroid zugeordnet und dementsprechend in eine Klasse eingeordnet. Die Zentroide werden anschließend wieder gelöscht. Nun wird anhand des “Massenschwerpunkts” die Mitte aller Punkte einer Klasse ermittelt und so die neuen Zentroiden bestimmt. Jetzt geht es wieder von vorne los: Die Punkte werden dem näheren Zentroid zugeordnet, klassifiziert und die Zentroiden werden wieder gelöscht. Das passiert so lange, bis die Position der Zentroiden sich nicht mehr verändern.

So können 2 optimale Standorte für die neuen Filialen bestimmt werden. Das gleiche kann mit den Herkunftsdaten der Kunden gemacht werden, nachdem die Filialen eröffnet wurden. Dadurch kann eine Vorhersage getroffen werden, bei welcher Filiale ein Kunde bestellen wird.

K-Means kann beispielsweise zum Clustering von kriminellen Aktivitäten genutzt werden. Auf einer Stadtkarte können so kriminelle Hotspots gefunden und nach der Art der häufigsten Straftaten untersucht werden. Weiterführend ist der Algorithmus hilfreich bei der Identifizierung von betrügerischen Finanzaktivitäten oder der Anomalie-Erkennung in Netzwerken.

Das war noch lange nicht alles: Was ist Boosting und wie gewinnt man mithilfe von ML Erkenntnisse aus Text und Bilder? Mehr dazu auf den Plätzen 5 bis 1 unserer Top10 ML-Algorithmen in der nächsten Woche.

0 Kommentare