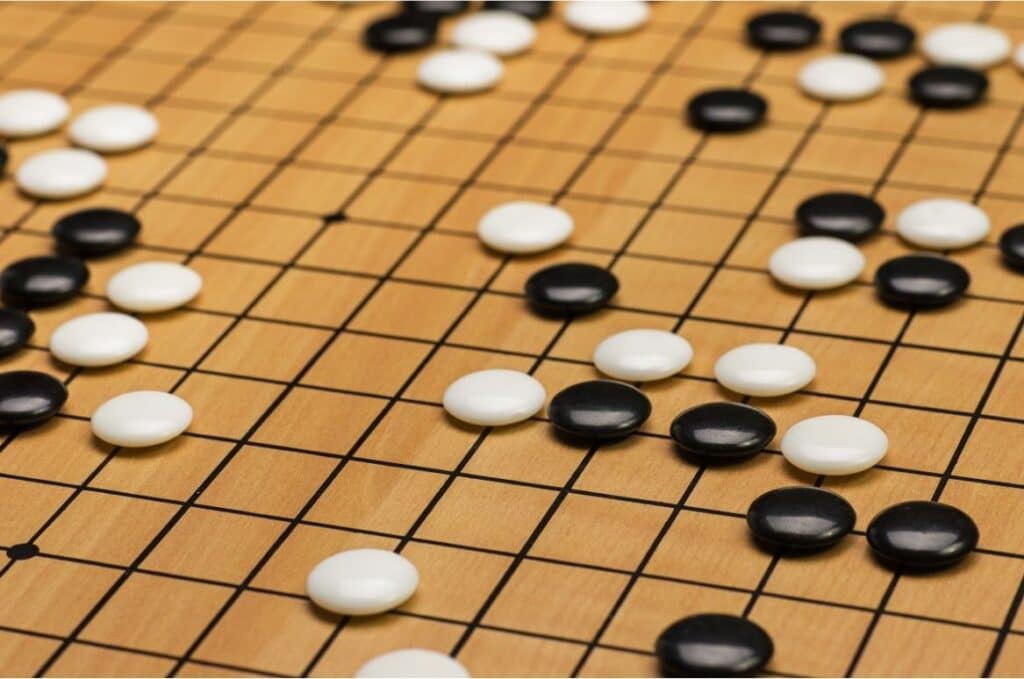

Was ist AlphaGo?

AlphaGo ist ein Computerprogramm, welches das japanische Brettspiel Go beherrscht. Dafür kombiniert es maschinelles Lernen und neuronale Netze miteinander. Entwickelt wurde es 2015 von Google DeepMind, mit dem Ziel, dass eine Künstliche Intelligenz das Go-Spiel meistert.

AlphaGo bildet die Grundlage für AlphaGo Zero, welches wiederum als Basis für AlphaZero dient.

Die Signifikanz von AlphaGo

Die Herausforderungen für die Entwicklung von AlphaGo war die Komplexität des Spieles Go an sich. Bereits 1997 ist es dem IBM-Programm Deep Blue gelungen, den damaligen Schachweltmeister Garri Kasparow unter Turnierbedingungen zu schlagen. Als Nächstes sollte eine KI das Go-Spiel meistern. Doch während es im Schach in einer Spielsituation durchschnittlich 35 mögliche Züge gibt, sind es bei Go 250. Insgesamt gibt es bei Go 10 hoch 170 mögliche Spielkonstellationen auf dem 19×19 Brett, was mit der bis dahin angewendeten Alpha-Beta-Suche nicht zu bewältigen ist. Go-Programme in den 1990er Jahren erreichen damit nur das Niveau von Amateurspielern.

2006 nutzten Go-Programme wie Zen und Crazy Stone den Monte-Carlo-Algorithmus (randomisierter Algorithmus, der mit zufälligen Zwischenergebnissen zu einer Entscheidung gelangt) und waren damit in der Lage, sehr gute Amateure zu besiegen. DeepMind ging noch einen Schritt weiter und nutzte zusätzlich neuronale Netze. Damit hat es 2015 den Europameister Fan Hui mit 5 zu 0 besiegt und war die erste KI, die einen menschlichen Profispieler in Go geschlagen hat.

Wie funktioniert der Algorithmus?

Der entscheidende Unterschied von AlphaGo zu allen bis dahin entwickelten Go-Programmen ist die Nutzung des Monte-Carlo-Algorithmus in Kombination mit zwei Arten von neuronalen Netzen.

Das „policy network“ bestimmt den bestmöglichen nächsten Zug. Das „value network“ berechnet währenddessen, wer der Gewinner der Partie sein wird und gibt auf dieser Grundlage Einschätzungen zum nächsten Zug. Somit muss der Algorithmus nur die wahrscheinlichsten Züge in Betracht ziehen und diese simulieren, um zu einem Entschluss zu kommen.

Die Grundlage für den Erfolg von AlphaGo ist die Anwendung von maschinellen Lernen, im Speziellen das überwachte Lernen (supervised learning) und verstärkendes Lernen (reinforcement learning). Trainiert wurde das Programm zuerst mit einer Datenbank aus zahlreichen Amateurspielen, um ein Verständnis für das menschliche Spiel zu gewinnen. Danach spielte es mehrere Tausend Spiele gegen sich selbst, um aus seinen eigenen Fehlern zu lernen und seine Spielstärke weiter zu steigern.

AlphaGo gegen Lee Sedol

Vom 9. bis 15. März 2016 kam es zum Wettkampf von AlphaGo gegen Lee Sedol, einem der besten Go-Spieler weltweit. Sedol hatte 18 internationale Titel gewonnen und mit dem 9. Dan den höchstmöglichen Rang inne. Zum Zeitpunkt des Wettkampfs betrug seine Elo-Zahl 3533, womit er auf Platz 4 der Weltrangliste stand.

Die Go-Fachwelt und auch Sedol selbst waren sich einig, dass AlphaGo nicht gegen ihn gewinnen könne. Doch nachdem die Künstliche Intelligenz die erste Partie für sich entschieden hatte, kamen erste Zweifel. Sedol sagte nach dem Turnier selbst, dass er überrascht war, wie kreativ AlphaGo seine Züge ausführt. Und auch, dass er sich von der KI sehr unter Druck gesetzt fühlte. Am Ende gewann AlphaGo 4 der 5 Partien. DeepMind hat damit unter Beweis gestellt, wozu eine Künstliche Intelligenz imstande ist.

Über die Bedeutung des Sieges von AlphaGo gegen Lee Sedol entstand 2017 auch ein Dokumentarfilm. Mit AlphaGo – der Film, thematisiert der Regisseur Greg Kohs die Entwicklungsgeschichte durch das DeepMind-Team und natürlich das Turnier mit Sedol. Außerdem wirft er einen Blick auf die Frage, was uns Künstliche Intelligenz über Menschlichkeit lehren kann.

AlphaGo Zero

Alpha Go Zero ist die Weiterentwicklung von AlphaGo durch das Team von DeepMind. Während AlphaGo durch menschliche Spiele Go erlernt, überspringt Zero diesen Schritt. Es kennt nur die Spielregeln und Spielbedingungen und lernt ausschließlich durch das Spielen gegen sich selbst, mithilfe des verstärkenden Lernens.

Zudem sind Software und Hardware etwas verändert worden, um AlphaGo Zero effizienter zu machen. Beispielsweise wurden die beiden neuronalen Netze in einem kombiniert und auch der Algorithmus wurde überarbeitet.

Bereits nach drei Tagen war Zero stärker als die Version von AlphaGo, welche Lee Sedol besiegen konnte. Und nach 40 Tagen Training hat Zero auch AlphaGo Master, die vormals letzte und stärkste Ausbaustufe von AlphaGo, geschlagen.

AlphaGo Zero wurde später die Grundlage für AlphaZero, welches die drei Spiele Go, Schach und Shogi ebenfalls nur durch das Spielen gegen sich selbst meisterte.