Aktuellste Machine Learning Modelle, wie sie beispielsweise in ChatGPT eingesetzt werden, haben aufgrund ihrer erstaunlichen Ergebnisse für Furore gesorgt. Generell haben große Sprachmodelle (Large Language Models – LLMs) einen immer stärkeren Einfluss auf die tägliche Arbeit und werden in einer Vielzahl an verschiedenen Tätigkeitsbereichen eingesetzt. Die verbesserten Ergebnisse in Hinblick auf die Qualität der Antworten ist neben dem 2017 eingeführten Transformer Modell (Quelle: Attention is all you need) insbesondere auf den Einsatz von Reinforcement Learning from Human Feedback (RLHF) zurückzuführen. Dieser Artikel beschäftigt sich daher mit RLHF im Bereich von Large Language Modellen. Diese Technik wird hierbei für ein verbessertes Finetuning von großen Sprachmodellen verwendet. Es wird an dieser Stelle bewusst auf den mathematischen Hintergrund von Reinforcement Learning Trainingsprozessen verzichtet, da diese Informationen ausführlich in unserem Beitrag „Reinforcement Framework und Anwendungsbeispiele“ zu finden sind.

Inhaltsverzeichnis

Large Language Models (LLMs): Eine Einleitung

LLMs sind keine Neuheit und kommen bereits seit längerer Zeit in verschiedensten Anwendungen zum Einsatz. Sprachassistenzsysteme wie Alexa, Siri greifen darauf zurück, Sucheingaben bei Google werden unter anderem darüber verarbeitet und spätestens seit ChatGPT ist der regelmäßige Einsatz in der Breite der Gesellschaft angekommen. Doch was verbirgt sich hinter großen Sprachmodellen und warum erhalten sie gerade jetzt so große Aufmerksamkeit, wo sie doch seit langer Zeit im Einsatz sind?

LLMs sind große neuronale Netze, die darauf trainiert sind, menschliche Sprache zu verstehen und zu generieren (bspw. GPT-4, LaMDA, LLaMA etc.). Diese Modelle können für verschiedene Anwendungen wie Spracherkennung, Übersetzung, Zusammenfassung und Chatbots eingesetzt werden, wodurch sie in vielen Arbeits- aber auch privaten Bereichen das Leben erleichtern.

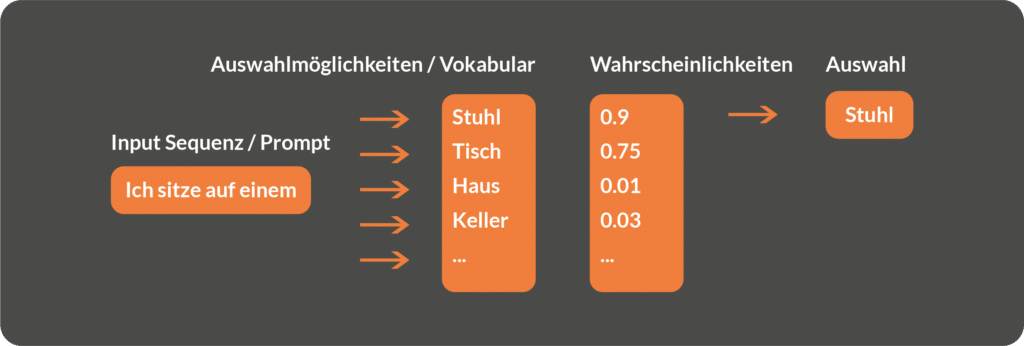

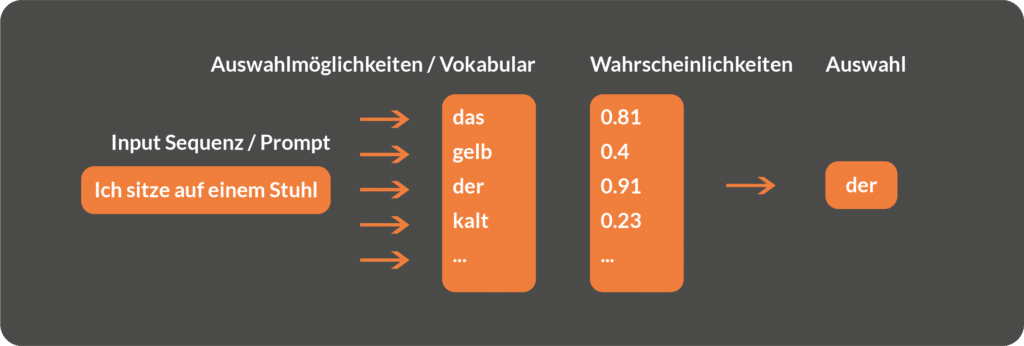

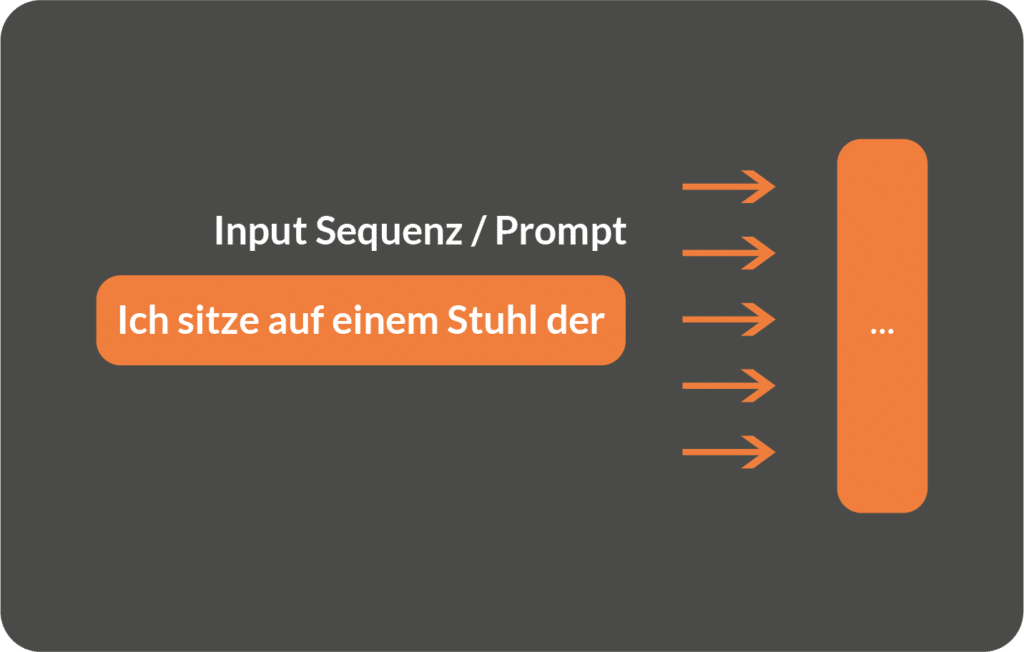

Damit LLMs ein „Sprachverständnis“ entwickeln können, müssen sie auf einer großen Menge von textuellen Inhalten trainiert werden. In der Regel werden diese Textdaten durch sogenanntes Scrapen von Internetinhalten gesammelt. Beim Scrapen besucht ein automatisiertes Programm eine Vielzahl an Webseiten und extrahiert alle Texte. Während der Trainingsphase lernen die Sprachmodelle kontextuelle Zusammenhänge innerhalb der Textdaten zu erkennen und bilden diese in einem komplexen probabilistischen Modell ab. Vereinfacht gesagt, wird während der Trainingsphase gelernt zu prognostizieren, welches Wort in einer Sequenz mit hoher Wahrscheinlichkeit als nächstes kommen wird:

Trainingsprozess visualisiert

Iteration 2:

Iteration 3

Das Training auf ungefilterten Internetinhalten und ohne Kontrolle der Textausgabe birgt jedoch die Gefahr, dass das Modell lernt Falschinformationen (Fake News), bösartige Inhalte oder Vorurteile (biases) zu reproduzieren. Um die Gefahr zu reduzieren, dass Sprachmodelle diese negativen Inhalte übernehmen und beim Generieren der Textausgabe wiedergeben, werden während des Trainingsprozesses verschiedene Verfahren angewendet. Einerseits werden vorverarbeitende Schritte angewendet, um aus den Textinhalten unerwünschte Passagen regelbasiert herauszufiltern, andererseits werden mit Hilfe von menschlichem Feedback zusätzliche Machine Learning Modelle trainiert, die in der Kombination mit dem Sprachmodell das Risiko minimieren sollen bösartige Inhalte zu produzieren. Darüber hinaus bietet dieses mehrstufige Trainingsverfahren die Möglichkeit die Ausgaben des Sprachmodells besser auf die Instruktionen und Intentionen der menschlichen Eingaben abzustimmen. Ein zentraler Bestandteil dieses Trainingsprozess ist das sogenannte „Reinforcement Learning fom Human Feedback (RLHF)“, welches im folgenden Abschnitt näher beleuchtet wird.

Eine vertiefende technische Einführung zur Reinforcement Learning, die Ihnen ein grundlegendes Verständnis von Reinforcement Learning (RL) anhand eines praktischen Beispiels gibt, erhalten Sie in unserem Blogbeitrag:

Reinforcement Learning from Human Feedback (RLHF)

Um den Trainingsprozess und die Ausgaben von großen Sprachmodellen besser steuern zu können, wird in vielen Fällen Reinforcement Learning from Human Feedback während des Trainingsprozesses angewendet. Dabei wird, zusätzlich zum automatisierten Lernen von Sprachmustern auf Basis von Textdaten, menschliches Feedback in den Lernprozess mit einbezogen. Die Idee hinter RLHF ist, dass ein Mensch dem Sprachmodell Feedback gibt, indem er mitteilt, ob das, was das Modell generiert hat, mit der Instruktion bzw. der Intention hinter der Eingabe übereinstimmt und keine ungewünschten Inhalte enthält. Mit Hilfe dieses Feedbacks kann das Sprachmodell während des Lernprozesses die Ausgaben stetig verbessern.

Der technische Prozess von Reinforcement Learning from Human Feedback besteht aus insgesamt drei Bausteinen:

1. Supervised Finetuning

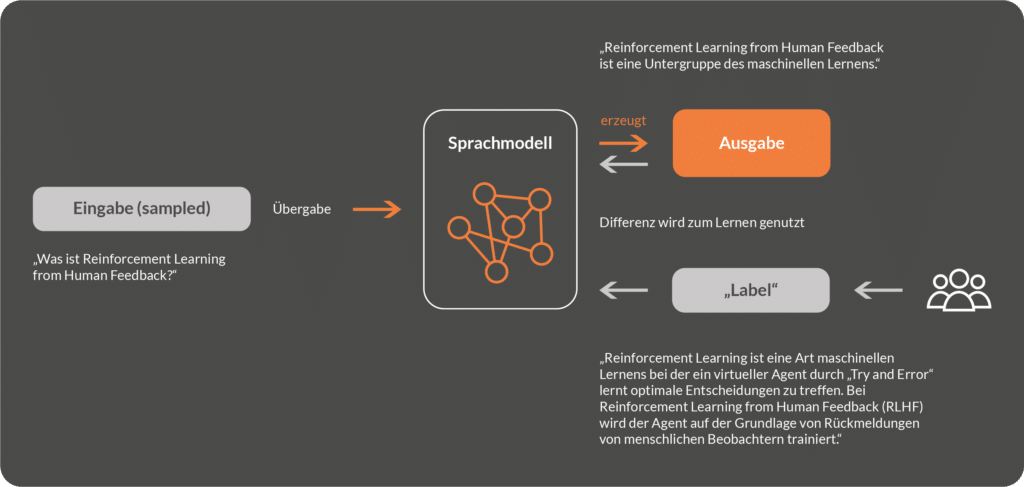

Der erste Schritt ist das sogenannte „Supervised Finetuning“ wobei die Technik des Supervised Machine Learning zur Optimierung des Modells genutzt wird. Supervised Machine Learning ist ein Ansatz im Bereich des maschinellen Lernens, bei dem ein Algorithmus aus einem Trainingsdatensatz lernt, Vorhersagen oder Entscheidungen für neue, unbekannte Daten zu treffen.

Im Supervised Finetuning Schritt von Reinforcement Learning from Human Feedback besteht der Input aus einer zufällig ausgewählten Texteingabe, bspw. „Was ist Reinforcement Learning from Human Feedback?“. Das Sprachmodell generiert auf Basis dieser Eingabe eine Ausgabe, bspw. „Reinforcement Learning from Human Feedback ist eine Untergruppe des maschinellen Lernens.“. Gleichzeitig schreibt eine menschliche Person zu demselben Input ein „optimale“ Antwort (Label), d.h. eine Antwort, die sich die menschliche Person auf den gegebenen Input gewünscht hätte. Anschließend wird die vom Modell generierte – und die vom Menschen generierte Antwort miteinander verglichen und die Differenz (der Fehler) genutzt, um die Modellparameter anzupassen. Die Anpassung der Modellparameter erfolgt automatisch mittels Backpropagation, wodurch das Modell lernt Antworten zu generieren, die sich stark an den „optimalen“ menschlichen Antworten orientieren.

Sobald die gewünschte Übereinstimmung zwischen menschlich generierten – und Modell generierten Antworten besteht bzw. der Fehler zwischen Ein- und Ausgabe minimiert wurde, wird das „Supervised Finetuned Model“ genutzt, um ein sogenanntes „Reward Modell“ zu trainieren.

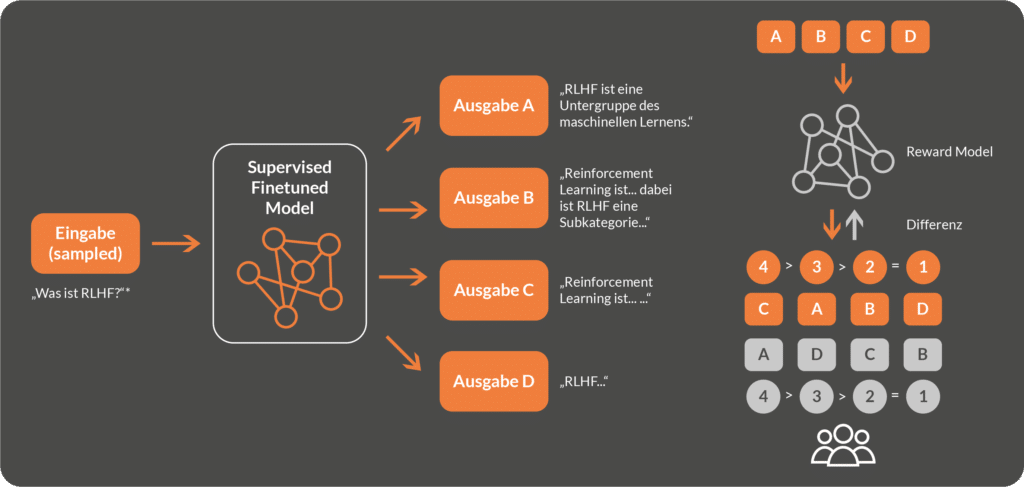

2. Training eines Reward Modells

Im zweiten Schritt von Reinforcement Learning from Human Feedback wird ein sogenanntes Reward Modell trainiert. Ebenso wie beim Supervised Finetuning wird menschliches Feedback genutzt, um die Textausgaben zu weiter zu optimieren. Dafür wird eine (neue) Texteingabe ausgewählt und an das in Schritt 1 optimierte Sprachmodell übergeben. Dieses generiert daraufhin eine Vielzahl an Outputs, die sich bis zu einem gewissen Grad voneinander unterscheiden – ein sogenanntes Kandidaten Set. Analog zu Schritt 1 wird dieses Kandidaten Set von Menschen bewertet bzw. ebenfalls geranked. Gleichzeitig wird ein neues neuronales Netz, das „Reward Modell“, erstellt, dass das Ziel haben soll, für jeden der Textausgabe-Kandidaten einen Ranking Score zu berechnen, der der menschlichen Einschätzung möglichst nahe kommt.

Das Training des Reward Modells erfolgt, indem die Differenz zwischen dem Ranking-Score des Reward Modells und dem menschlichen Ranking zunehmend minimiert wird.

Nach Abschluss der Trainingsphase hat das Reward Modell gelernt die vom Sprachmodell generierten Antworten zu bewerten und mit einem Ranking Score zu versehen. Das menschliche Feedback dient in diesem Fall dazu, dass das Reward Modell lernt die Nützlichkeit der Antworten für den Menschen zu approximieren.

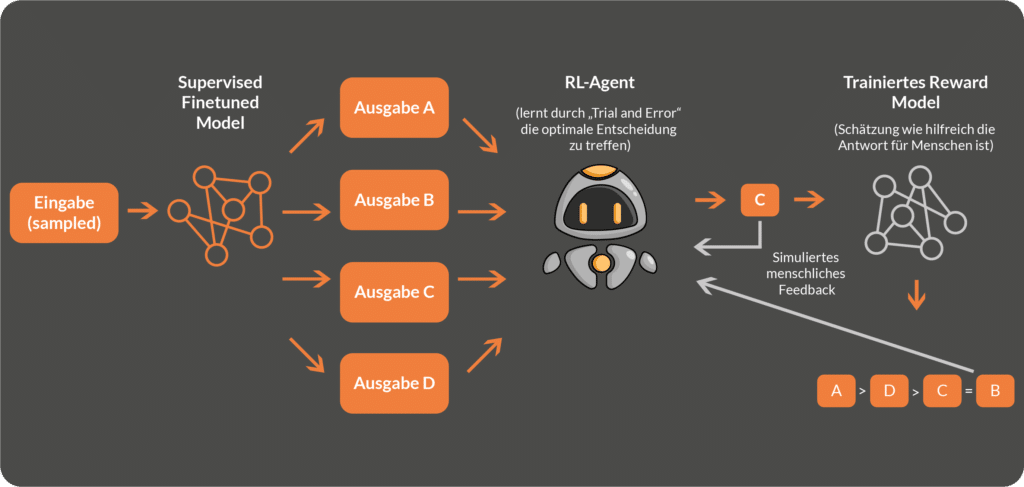

3. Training des Reinforcement Learning Agenten mit Proximal Policy Optimization (PPO)

Das Reward Modell aus Schritt 2 generiert ein Ranking aus einer Menge an Antworten, die vom optimierten Sprachmodell aus Schritt 1 generiert wurden. Nun könnte angenommen werden, dass die Antwort mit dem höchsten Ranking als finale Antwort an den Enduser ausgegeben wird, was jedoch ein Trugschluss ist, da so eine statische Auswahl zu folgenden Problemen in der Praxis führen könnte:

- Fehlende Exploration: Im Reinforcement Learning (RL) ist es wichtig, sowohl die Exploration neuer Strategien als auch die Exploitation bekannter, guter Strategien auszubalancieren. Wenn einfach die Antwort mit dem höchsten Ranking ausgewählt wird, kann dies dazu führen, dass der Agent in einer suboptimalen Lösung stecken bleibt, ohne eine Chance bessere oder innovative Lösungen zu finden. RL-Algorithmen ermöglichen eine gewisse Exploration, um neue Strategien zu entdecken und die Leistung des Agenten weiter zu optimieren (siehe RL-Terminologie Artikel).

- Unsicherheit des Reward Modells: Das Reward Modell kann ungenau oder unvollständig sein, insbesondere wenn es auf menschlichem Feedback basiert, das subjektiv und inkonsistent sein kann. Durch die Verwendung eines RL-Ansatzes wie PPO kann der Agent nicht nur auf Grundlage der aktuellen Belohnungsschätzung lernen, sondern auch in Betracht ziehen, wie sich seine policy (siehe RL-Terminologie Artikel) im Laufe der Zeit anpassen sollte, um potenzielle Unsicherheiten in den Belohnungsschätzungen zu berücksichtigen.

- Stochastische Umgebungen: In vielen realen Situationen sind die Umgebungen, in denen der Agent agiert, stochastisch und unvorhersehbar. In solchen Fällen kann eine einfache Auswahl der Antwort mit dem höchsten Ranking möglicherweise zu nicht optimalen Ergebnissen führen. Ein RL-Ansatz wie PPO kann dem Agenten helfen, besser auf Umgebungsunsicherheiten zu reagieren und seine Strategie entsprechend anzupassen.

- Langfristige Optimierung: Das Ziel von Reinforcement Learning besteht darin, die kumulative Belohnung über die Zeit zu maximieren, und nicht nur die sofortige Belohnung zu berücksichtigen. Eine einfache Auswahl der Antwort mit dem höchsten Ranking konzentriert sich auf die sofortige Belohnung und ignoriert möglicherweise langfristige Auswirkungen und optimale Strategien. Mit anderen Worten: bei der langfristigen Optimierung werden Antworten in Betracht gezogen, die im Laufe des Dialoges bspw. mit ChatGPT einen größeren Mehrwert dem User liefern. RL-Ansätze wie PPO zielen darauf ab, langfristige Entscheidungsfindung und optimale Strategien zu berücksichtigen, um die Gesamtleistung des Agenten im Dialog zu verbessern.

- Lernen und Anpassen: In vielen Fällen ändert sich die Umgebung oder die Problemstellung im Laufe der Zeit. Beispielsweise wird die bei der Nutzung von ChatGPT im Laufe der Konversation neue Fakten als zusätzlicher Kontext dem Modell mitgeliefert oder der/die User:in möchte die Tonalität der Textausgabe ändern. Durch die Verwendung eines RL-Ansatzes kann der Agent von seinen Erfahrungen lernen und seine Strategie an neue Situationen anpassen. Eine einfache Auswahl der Antwort mit dem höchsten Ranking bietet möglicherweise keine solche Anpassungs- und Lernfähigkeit.

Eine kompakte Einleitung in die Definition und Begrifflichkeiten hinter Reinforcement Learning erhalten Sie in unserem Grundlagenartikel zur Methodik:

Daher wird nach dem Training des Reward Modells ein weiterer, dritter Trainingsschritt in Reinforcement Learning from Human Feedback durchgeführt, indem ein Reinforcement Learning Agent mit Hilfe von Proximal Policy Optimization (PPO) lernt in jeder (Gesprächs-) Situation die bestmögliche Entscheidung zu treffen. Dieser Schritt soll dazu dienen, dass die oben genannten Probleme minimiert werden. Proximal Policy Optimization (PPO) ist eine moderne Methode im Bereich des Reinforcement Learning, die darauf abzielt, die Trainingsstabilität und Leistung von Policy-Gradienten-Ansätzen zu verbessern. PPO optimiert die sogenannte „policy“ (Richtlinie bzw. den Aktionsplan) des Agenten, um die erwartete kumulative Belohnung zu maximieren. PPO hat sich in vielen RL-Aufgaben als effektiv erwiesen und ist bekannt für seine Robustheit und gute Leistung bei einer Vielzahl von Anwendungen. Ausführliche Informationen zur Funktionsweise von RL-Agenten sind im hier verlinkten Beitrag zu finden: RL-Terminologie Artikel.

Der Zusammenhang zwischen dem Reward-Modell und dem PPO-Modell in Reinforcement Learning from Human Feedback besteht darin, dass das Reward-Modell dazu verwendet wird, dem Agenten Feedback über die Qualität seiner Aktionen zu geben, während der PPO-Algorithmus dieses Feedback nutzt, um die policy des Agenten effizient zu aktualisieren. Das Hauptziel dieser Zusammenarbeit besteht darin, den Agenten dazu zu bringen, menschenähnliche Entscheidungen (vom Reward Modell approximiert) zu treffen, wenn er komplexe Aufgaben löst oder in Umgebungen agiert, in denen die optimale Lösung nicht leicht zugänglich ist. Durch die Kombination von menschlichem Feedback und effektiven RL-Algorithmen wie PPO kann der Agent von menschlicher Expertise profitieren und seine Lernfähigkeit erweitern, um anspruchsvollere Probleme zu bewältigen und sich besser an verschiedene Situationen anzupassen.

Es ist zu beachten, dass die hier beschriebene Art von Reinforcement Learning from Human Feedback eine von verschiedenen Möglichkeiten ist RLFH in das Modelltraining zu integrieren. Es ist beispielsweise auch möglich das LLM selbst als Reinforcement Learning Agent zu nutzen und dadurch die Antworten nicht nur durch eine Auswahl aus n Kandidaten, sondern direkt die Generierung der LLMs durch das Lernen aus Rewards verbessert werden können.

Insgesamt kann die Verwendung eines Reinforcement-Learning-Ansatzes mit PPO anstelle einer einfachen Auswahl der Antwort mit dem höchsten Ranking des Reward Modells dem Agenten dabei helfen, besser auf Unsicherheiten, Umgebungsveränderungen und langfristige Auswirkungen zu reagieren, und ermöglicht eine bessere Exploration und Anpassung an neue Situationen. Obwohl eine einfache Auswahl der höchstbewerteten Antwort in einigen Szenarien ausreichend sein kann, bieten Reinforcement-Learning-Methoden im Allgemeinen eine flexiblere und leistungsfähigere Lösung für komplexe Probleme und dynamische Umgebungen.

Vertiefen Sie Ihr Verständnis für das Konzept der „Tödlichen Triade“ im Reinforcement Learning, seine Auswirkungen und Lösungsansätze. Dieser Deep Dive versorgt Sie mit einem Überblick über RL-Konzepte, Vorstellung der „Tödlichen Triade“ und deren Bewältigungsstrategien.

Fazit

Reinforcement Learning from Human Feedback ist ein Ansatz, mit dem einerseits das Risiko von Falschinformationen minimiert werden und gleichzeitig die Qualität der Antworten von großen Sprachmodellen gesteigert werden kann, indem der Trainingsprozess durch menschliches Feedback beeinflusst wird. Durch die Kombination von menschlichem Wissen und effektiven RL-Algorithmen wie PPO können Agenten komplexe Aufgaben meistern und menschenähnliche Leistungen erreichen oder sogar übertreffen.

Die Verwendung von menschlichen Feedback im Reward-Modell ermöglicht es dem Agenten, von der Intuition und Erfahrung realen Menschen zu profitieren, während gleichzeitig die Anpassungs- und Lernfähigkeit des Agenten durch Reinforcement Learning gewährleistet wird. Dieser Ansatz trägt zur Verbesserung der Exploration und Exploitation von Strategien, der Anpassung an Umgebungsunsicherheiten und der Berücksichtigung langfristiger Auswirkungen bei, was zu einer insgesamt besseren Leistung führt.

Insgesamt bietet Reinforcement Learning from Human Feedback eine Möglichkeit, Künstliche Intelligenz weiterzuentwickeln und auf eine breite Palette von Anwendungen und Herausforderungen anzuwenden. Dieser Ansatz eröffnet neue Wege für die Zusammenarbeit zwischen Menschen und Maschinen und ermöglicht die Grenzen der KI zu erweitern und innovative Lösungen für komplexe Probleme zu entwickeln.

0 Kommentare