Inhaltsverzeichnis

Einführung

Künstliche Intelligenz (KI) revolutioniert viele Facetten unseres täglichen Lebens und ist ein wichtiger Treiber für die aktuellen Entwicklungen in Unternehmen und der Industrie. Heute lösen KI-gestützte Algorithmen langwierige Probleme und Use Cases auf intelligente und effiziente Weise und übertreffen dabei oft die menschliche Leistung in einer Vielzahl von Bereichen. Das Gebiet des Reinforcement Learning (RL) ist ein zentraler Pfeiler moderner KI-Anwendungen. Es reicht von RL-Agenten, die menschliche Spieler in komplexen Spielen wie Go oder Schach schlagen, bis hin zu hochmodernen Sprachmodellen wie ChatGPT. Es ist nicht überraschend, dass RL auch in der Industrie zunehmend auf Interesse stößt. Ziel dieses Artikels ist es, einen Überblick über die Anwendung von RL in der Industrie zu geben und das große Potential von RL als Optimierungswerkzeug für verschiedene Geschäftsprobleme zu diskutieren.

Es gibt verschiedene Algorithmen für Maschinelles Lernen (ML), die in der Industrie eingesetzt werden. Beim Supervised Learning (überwachten Lernen) wird versucht, spezifische Vorhersagen auf der Grundlage vordefinierter Kennzeichnungen zu treffen. Ein klassisches Beispiel ist die Objekterkennung, bei der die Aufgabe darin besteht, zu klassifizieren, ob ein bestimmtes Bild Objekte wie Fußgänger oder Ampeln enthält. Das Training erfolgt durch die Bereitstellung gelabelter Beispiele (Bilder) und die Suche nach Mustern, die zur Klassifizierung ungesehener Beispiele verwendet werden können.

Beim Unsupervised Learning (unüberwachten Lernen) wird versucht, eine Struktur in den Daten zu finden, ohne dass Beispiele dafür vorhanden sind. Wir müssen zum Beispiel herausfinden, welche Bilder ähnliche Situationen enthalten, und diese gruppieren.

Während beim überwachten und unüberwachten Lernen das Verstehen einer Situation im Vordergrund steht, geht es bei verschiedenen Problemen (z. B. bei selbstfahrenden Autos) nicht nur um das Verstehen, sondern auch darum, herauszufinden, wie man auf eine Situation reagieren kann (beschleunigen, bremsen, lenken usw.). Solche Optimierungs- und Steuerungsprobleme, bei denen geeignete Handlungen auf bestimmte Situationen abgebildet werden, sind das Markenzeichen des Reinforcement Learning. Eine allgemeinere Einführung in den theoretischen Hintergrund des Reinforcement Learning und seine Schlüsselkonzepte finden Sie in unserem Beitrag zum RL-Framework.

Eine vertiefende technische Einführung zur Reinforcement Learning, die Ihnen ein grundlegendes Verständnis von Reinforcement Learning (RL) anhand eines praktischen Beispiels gibt, erhalten Sie in unserem Blogbeitrag:

Reinforcement Learning im Unternehmen: Wo wird RL eingesetzt?

Welche Arten von Geschäftsproblemen können mit Reinforcement Learning gelöst werden? Wie bereits erwähnt, ist RL ein leistungsfähiges Optimierungsinstrument, was bedeutet, dass RL besonders für Probleme geeignet ist, bei denen wir die Struktur und den gewünschten Zielzustand kennen, aber nicht wissen, wie wir diesen gewünschten Zustand am besten erreichen können. Wichtig ist, dass wir im Gegensatz zu anderen Techniken wie dem Supervised Learning bei RL keine „Grundwahrheit“ darüber kennen müssen, wie ein Problem zu lösen ist.

Stellen Sie sich einen Roboter vor, der lernen muss, wie er von einem bestimmten Startpunkt zu einem Ziel navigiert und dabei bestimmte Hindernisse umgeht. Eine Möglichkeit wäre, anhand von Beispielpfaden zu lernen, die den Weg vom Start zum Ziel definieren (drei Schritte geradeaus gehen, dann rechts abbiegen, dann wieder geradeaus, …), wie beim Supervised Learning. Dies würde bedeuten, dass der Roboter nicht lernt, selbst optimale Abläufe zu finden, sondern dass wir dem Roboter spezifische Anweisungen geben, wie er sich an verschiedenen Orten verhalten soll. Das mag zunächst nach einer vernünftigen Idee klingen, ist aber in der Praxis höchst unpraktisch. Oft kennen wir unseren Startpunkt und unser Ziel, können aber den genauen (oder optimalen) Weg vom Start zum Ziel nicht angeben – wir benötigen einen Agenten, der lernen kann, selbst einen optimalen Weg zu finden. Und selbst wenn wir die richtige Lösung wüssten, ist es unwahrscheinlich, dass unser Roboter sein Wissen auf andere ähnliche Situationen übertragen kann, so dass selbst eine winzige Veränderung der Umgebung den Roboter unflexibel und funktionsunfähig macht.

Im Allgemeinen bieten solche Supervised Learning Techniken einen leistungsfähigen Rahmen für Probleme wie Computer Vision, sind aber bei flexibleren sequenziellen Optimierungsaufgaben unzureichend. Stattdessen muss unser Roboter die Umgebung erkunden und durch trial-and-error lernen, basierend auf Rückmeldungen über gute und schlechte Bewegungen. Daher müssen wir keine gelösten Beispiele als Trainingsdaten bereitstellen und stattdessen unseren Roboter mit einem flexiblen Mechanismus für kontinuierliches Lernen ausstatten: Wenn sich die Umgebung ändert, spiegelt sich dies in den veränderten Rückmeldungen wider, die unser Roboter erhält, und veranlasst ihn, den Weg vom Start zum Ziel neu zu erlernen. Dieser Ansatz entspricht dem Reinforcement Learning, das ein leistungsstarkes und allgemeines Framework für die Lösung von Problemen in der realen Welt bietet.

Eine kompakte Einleitung in die Definition und Begrifflichkeiten hinter Reinforcement Learning erhalten Sie in unserem Grundlagenartikel zur Methodik:

Reinforcement Learning Use Cases in der Industrie

Nur, abgesehen davon, dass man Robotern sagt, wie sie Ziele erreichen sollen, wie kann Reinforcement Learning in realistischen industriellen Anwendungsfällen eingesetzt werden? Es gibt viele Beispiele für Reinforcement-Learning-Use Cases in der Industrie, von denen wir einige beschreiben werden.

Da Reinforcement Learning einen leistungsstarken und allgemeinen Optimierungsrahmen bietet, hat es ein großes Potenzial zur Lösung von Problemen mit vielen beweglichen und interagierenden Teilen, wie zum Beispiel im Energiesektor. Hier kann RL zur Optimierung von Prozessen sowohl aus der Perspektive eines Anbieters als auch eines Verbrauchers eingesetzt werden. Als Anbieter kann RL nützlich sein, um zu lernen, wie man sich an den erwarteten zukünftigen Energiebedarf anpasst, und um Reaktionsprogramme zu optimieren, die Kunden zum Energiesparen anregen. Auf der Verbraucherseite ist RL ein hochmodernes Instrument zur Optimierung des Energieverbrauchs, indem das richtige Gleichgewicht zwischen Kostenminimierung und Bereitstellung ausreichender Energie für Prozesse wie Heizung oder Beleuchtung gefunden wird. Es kann auch verwendet werden, um zu lernen, wie Windturbinen oder Solarpaneele optimal eingestellt werden können, um die Energieproduktion zu maximieren, oder um das ideale Gleichgewicht zwischen der Minimierung der Kosten für das Aufladen oder die Speicherung von Energie und der Bereitstellung ausreichender Energie, beispielsweise in Batterien, zu finden.

Use Case #1: Reduzierung des Enerbieverbrauchs in Rechenzentren

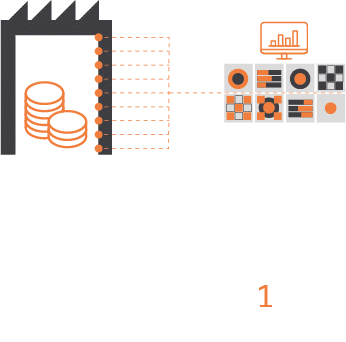

Ein besonders überzeugendes Anwendungsbeispiel für den Einsatz von RL im Energiebereich ist die Reduzierung des Energieverbrauchs in Rechenzentren. Derzeit machen Rechenzentren etwa 2 % des weltweiten Energiebedarfs aus, könnten aber bis 2030 für etwa 8 % des weltweiten Energieverbrauchs verantwortlich sein (und etwa 21 %, wenn wir andere Bereiche der Informations- und Kommunikationstechnologie einbeziehen, siehe nutanix.com und www.nature.com). Um dieses Problem anzugehen, hat Google DeepMind ein auf RL basierendes System zur Senkung des Energieverbrauchs von Rechenzentren entwickelt. Wie in Abbildung 1 dargestellt, besteht dieses System aus drei Hauptschritten: Ein Cloud-basiertes System liest Informationen aus dem Kühlsystem des Rechenzentrums aus, um eine komplexe Zustandsdarstellung zu erstellen. Auf der Grundlage dieser Zustandsdarstellung sagt ein tiefes neuronales Netz die künftige Energieeffizienz und Temperatur auf der Grundlage der vorgeschlagenen Maßnahmen (d. h. Änderungen im Kühlsystem) voraus, wobei der Wert der verschiedenen Maßnahmen berücksichtigt wird. Auf der Grundlage dieser berechneten Werte wählt das RL-System die beste Maßnahme aus, die die Energieeffizienz optimiert und gleichzeitig die Sicherheitsvorgaben erfüllt. Auf der Grundlage dieses RL-Systems konnte der Energiebedarf von Rechenzentren um 30 % gesenkt werden (vgl. Safety-first AI for autonomous data centre cooling and industrial control (deepmind.com) und der Anteil der für die Kühlung verbrauchten Energie konnte um 40 % reduziert werden (vgl. DeepMind AI Reduces Google Data Centre Cooling Bill by 40%).

Alle fünf Minuten erstellt das Cloud-basierte System eine Momentaufnahme des Kühlsystems des Rechenzentrums (Zustand s) aus Tausenden von physikalischen Sensoren

Informationen (Zustand s) werden in ein tiefes neuronales Netz eingespeist, das die zukünftige Energieeffizienz und Temperatur auf der Grundlage der vorgeschlagenen Maßnahmen (Q-Werte) vorhersagt.

Auswahl von Maßnahmen (policy), die den Beschränkungen entsprechen und den Energieverbrauch minimieren

Optimale Aktionen werden an das Datenzentrum zurückgeschickt, das lokale System überprüft sie anhand der eigenen Sicherheitsvorgaben

Abbildung 1: Ein RL-basiertes System zur Optimierung des Energiebedarfs in Rechenzentren, entwickelt von Google Deepmind (Safety-first AI for autonomous data centre cooling and industrial control)

Darüber hinaus hat Google DeepMind in jüngerer Zeit RL-basierte Algorithmen entwickelt, um die Ressourcennutzung der Google-Rechenzentren zu optimieren und die Effizienz der Softwareentwicklung zu steigern (Optimierung von Computersystemen mit allgemeineren KI-Tools).

Use Case #2: Optimierungen im Bereich Verkehr & Logistik

Wir haben gesehen, dass RL ein leistungsfähiger Rahmen für die Lösung von Use Cases im Energiesektor ist und eine zentrale Rolle dabei spielen wird, unser digitales Zeitalter nachhaltiger zu gestalten. RL ist auch in anderen Bereichen, in denen sequenzielle Optimierungsprobleme vorherrschen, von entscheidender Bedeutung. RL ist beispielsweise ein leistungsfähiges Werkzeug für die Lösung von Problemen im Bereich Verkehr und Logistik. Unternehmen können RL nutzen, um die Verkehrssteuerung im öffentlichen Verkehr zu optimieren, indem sie sequenzielle Aktionen finden, die Verspätungen minimieren oder die Kundenerfahrung verbessern, z. B. im Zusammenhang mit dem Management von Verspätungen, der Reduzierung von erforderlichen Zugwechseln oder der Steuerung von Ampelschaltungen. In der Logistik wird RL eingesetzt, um die Kosten der Lieferkette zu optimieren, neue optimale Lieferrouten zu finden und die Bestände in Lagern zu verwalten. Hier geht es darum, die Verfügbarkeit von Produkten zu gewährleisten und gleichzeitig die Lager- und Lieferzeiten zu verkürzen.

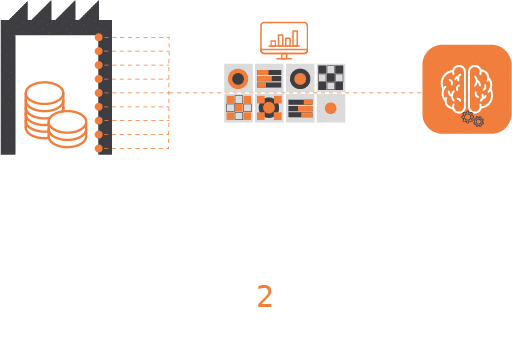

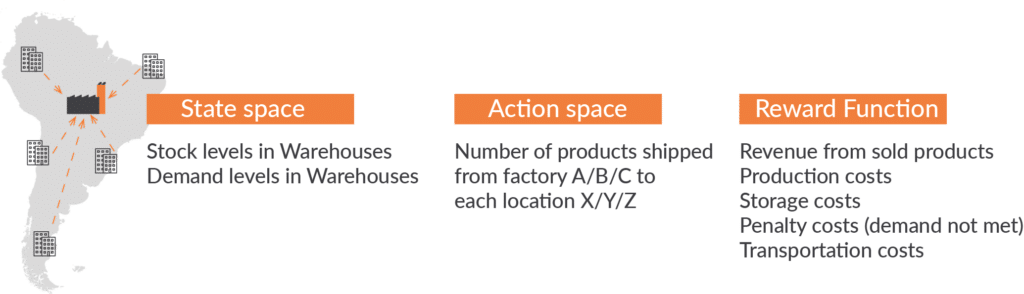

RL ist ein gängiges Framework für die Optimierung der Lieferketten, das von Unternehmen wie Amazon verwendet wird. Der Grundgedanke besteht darin, RL zu nutzen, um die beste Verteilung der Produkte auf die Lagerhäuser und (falls erforderlich) die richtige Menge an Waren in den Fabriken zu finden (Optimierung des Lieferkettennetzwerks – Schneiden durch die Komplexität zur Maximierung der Effizienz). In diesem Fall besteht der Zustandsraum aus den Lagerbeständen und der Nachfrage in den verschiedenen Lagern, und die Aktionen spiegeln die Verteilung und Bewegung der Produkte zwischen den Lagern oder von den Produktionsstätten zu den Lagern wider. RL wird dann eingesetzt, um Aktionen zu finden, die eine Belohnungsfunktion optimieren, die häufig ein Gleichgewicht zwischen den Einnahmen aus verkauften Produkten und verschiedenen Kostenarten darstellt wie Produktions-, Lager- oder Transportkosten sowie (hohen) Strafkosten für die Nichtbefriedigung der Kundennachfrage (Reinforcement learning for supply chain optimization). Abbildung 2 gibt einen Überblick über diese Spezifikation (adaptiert von Reinforcement learning for supply chain optimization). RL ist sehr erfolgreich bei der Lösung solcher Optimierungsaufgaben in der Lieferkette und ein Gebiet, das in jüngster Zeit von großem Forschungsinteresse ist (A Reinforcement Learning Approach for Supply Chain Management, A review on reinforcement learning algorithms and applications in supply chain management).

Abbildung 2. Ein RL-basiertes System zur Optimierung der Lieferkette (vgl. Reinforcement learning for supply chain optimization)

Use Case #3: Finanz- und Bankenwesen

Neben den Bereichen Energie, Transport und Logistik wird Reinforcement Learning auch im Finanzwesen häufig eingesetzt. Hier bietet RL einen leistungsstarken Rahmen für den Aktienhandel und die Vermögensverwaltung. Die Vorhersage zukünftiger Umsätze oder Aktienkurse ist ein Schlüsselelement von Prognoseanalysen im Finanzwesen. Prognosemodelle, wie z. B. auf Supervised Learning basierende Methoden, sagen uns jedoch nicht, wie wir handeln müssen, um den Umsatz zu steigern oder die Gewinnspanne zu maximieren. RL-Modelle hingegen können lernen, wie das Verhalten optimiert werden kann, um ein bestimmtes Ziel in schwankenden Märkten zu erreichen. Ein Paradebeispiel für den Einsatz von Reinforcement Learning ist der automatisierte Aktienhandel (Blog JP Morgan). Wichtig ist, dass sich RL-Algorithmen nicht darauf beschränken, zu lernen, wie man den Gewinn maximiert und gleichzeitig die Risiken ignoriert. Was genau optimiert wird, hängt von der Definition der Zielfunktion in RL ab, die eine Mischung aus dem Ziel der Ertragsoptimierung und der Risikokontrolle sein kann. Dieser Ansatz steht im Mittelpunkt der RL-Anwendungen bei der Portfolio-Optimierung und bei Risikomanagementmodellen. Darüber hinaus wird RL häufig in Kreditbewertungsmodellen eingesetzt, die lernen können, Kreditlimits auf der Grundlage sich dynamisch verändernder Risiken anzupassen.

Use Case #4: Autonomes Fahren

RL ist auch ein unverzichtbares Werkzeug für das autonome Fahren, bei dem Autos (und andere Fahrzeuge) lernen können, bessere Entscheidungen im Verkehr zu treffen. Autonomes Fahren ist ein Paradebeispiel für state-of-the-art Anwendungen des Maschinellen Lernens und der KI, und RL ist ein zentraler Aspekt dieser Anwendung. Damit Autos durch den Verkehr navigieren können, müssen sie eine Vielzahl aufeinander folgender Entscheidungen treffen, z. B. die Spur wechseln, an einer Ampel anhalten, eine Kollision vermeiden oder einparken. Diese Entscheidungen beruhen auf erworbener Bewegungsplanung, Trajektorienoptimierung und szenariobasierten Fahrstrategien, die alle mit RL erlernt werden können. Aber der Einsatz von RL im Automobilsektor geht über das autonome Fahren hinaus. RL ist ebenso relevant für die Optimierung von Fahrzeugsteuerungsassistenzsystemen und stellt auch ein wesentliches Werkzeug für die vorausschauende Wartung und Qualitätskontrolle in der Automobilproduktion dar.

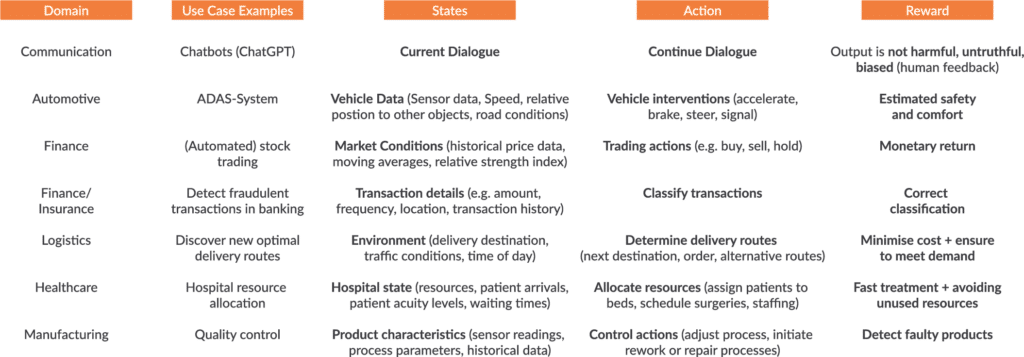

Abbildung 3 gibt einen Überblick über verschiedene Domänen und Anwendungsbeispiele von RL in der Industrie.

In unserem Deep Dive beleuchten wir die Wechselwirkungen zwischen Geschäftsmethoden, Neurowissenschaften und dem Reinforcement Learning in künstlicher und biologischer Intelligenz.

Technische und Praktische Ansätze und aktuelle Entwicklungen

Aber was braucht man, um Reinforcement Learning in einem industriellen Use Case einzusetzen? Um ein Problem mit Reinforcement Learning zu lösen, ist es im Allgemeinen wichtig, die Schlüsselkomponenten der Umgebung in einer simulierten RL-Umgebung zu quantifizieren. Zunächst muss man den Zustandsraum spezifizieren, d.h. alle möglichen Umstände, in denen sich der Agent befinden kann. Um auf unser ursprüngliches Beispiel eines Roboters zurückzukommen, der lernt zu navigieren, würde der Zustandsraum alle möglichen Orte quantifizieren, an denen sich der Roboter befinden könnte. Ein „Zustand“ kann auch abstrakter sein, wie z. B. eine bestimmte Finanzmarktkonfiguration oder ein Lagerbestandsstatus. Darüber hinaus ist es wichtig, den Aktionsraum des Agenten zu spezifizieren, z. B. die Bewegung nach oben, unten, links oder rechts. Dieser Aktionsraum bestimmt, was der Agent tun kann, um mit einem bestimmten System zu interagieren. Das grundlegende Ziel besteht darin, die besten Aktionen in diesem System zu finden, um ein bestimmtes Problem zu lösen. Gute“ und „schlechte“ Aktionen werden durch eine Belohnungsfunktion bestimmt, die dem Agenten sagt, welche Ergebnisse gut oder schlecht sind. Häufig wird davon ausgegangen, dass Agenten eine große positive Belohnung für das Erreichen eines Ziels erhalten, eine große negative Belohnung für das Scheitern oder riskantes Verhalten (z. B. Sturz von einer Klippe oder Energiemangel) und eine kleine negative Belohnung für die Zeit, die sie mit der Suche nach dem Ziel verbringen.

Ein wichtiger Aspekt bei der Anwendung von RL auf reale Probleme in der Industrie ist die Verwendung sogenannter digitaler Zwillinge. Digitale Zwillinge sind künstliche Umgebungen, die ein physisches System nachbilden, um dessen Verhalten zu simulieren und zu analysieren. Wir können digitale Zwillinge verwenden, um RL-Agenten in einer sicheren und kontrollierten Umgebung zu trainieren – um zu lernen, dass ein Sturz von einer Klippe schwerwiegende Folgen hat, ist es besser, diese Erfahrung virtuell und nicht im wirklichen Leben zu machen. Die Arbeit mit digitalen Zwillingen ermöglicht es uns, verschiedene und potenziell seltene Szenarien für unsere RL-Agenten zu simulieren und ihnen zu ermöglichen, angemessene Lösungen zu finden, ohne das Risiko eines tatsächlichen Schadens für das System einzugehen. Durch die Verwendung digitaler Zwillinge werden nicht nur mögliche negative Folgen von Risikoverhalten während des Lernens vermieden, sondern auch die Trainingsleistung verbessert.

Auch bei der Anwendung von RL auf industrielle Probleme gibt es wichtige Herausforderungen zu bewältigen. Wie bereits erwähnt, ist es auch entscheidend, die Belohnungsfunktion (auch Zielfunktion genannt) eines RL-Agenten richtig zu gestalten. Wenn wir einen Agenten entwerfen, der sich ausschließlich um Belohnungsmaximierung kümmert, z. B. um das Erreichen eines bestimmten Ziels oder die Maximierung einer Gewinnspanne, könnte der Agent ein riskantes Verhalten an den Tag legen, z. B. „Optimismus im Angesicht der Unsicherheit“. Als Entwickler ist es daher unerlässlich, eine Zielfunktion zu definieren, die nicht nur die positiven Gewinne eines Problems berücksichtigt, sondern auch die negativen Ergebnisse, z. B. durch Festlegung einer hohen negativen Belohnung für unerwünschtes und riskantes Verhalten. An dieser Stelle wird der Einsatz von digitalen Zwillingen besonders relevant.

Die aktuelle Forschung befasst sich auch mit Fragen der Erklärbarkeit und Interpretierbarkeit von RL-Systemen. Wie bei jedem anderen maschinellen Lernalgorithmus ist es nicht nur wichtig, eine bestimmte Aufgabe zu lösen, sondern auch zu verstehen, wie sie gelöst wird. Im Fall von RL wollen wir nicht nur einen Agenten finden, der Entscheidungen trifft, die ein bestimmtes Problem lösen, sondern auch verstehen, warum er diese spezifischen Entscheidungen getroffen hat. Diese Frage unterstreicht die wichtige Verbindung zwischen der RL-Forschung und erklärbaren KI-Systemen, einem Gebiet, das in jüngster Zeit auf großes Interesse stößt.

Erfahren Sie, wie großen Sprachmodellen wie ChatGPT durch den Einsatz von Reinforcement Learning from Human Feedback (RLHF) verbessert werden.

Reinforcement Learning from Human Feedback im Bereich von großen Sprachmodellen

Fazit

Zusammenfassend lässt sich sagen, dass die Theorie des Reinforcement Learning viel spannendes Potenzial für die Lösung von sequentiellen Optimierungsproblemen in der Industrie bietet. Die Theorie des Reinforcement Learning, die vor über 120 Jahren aus der Verhaltenswissenschaft hervorging, hat sich zu einem dominanten Rahmenwerk in so unterschiedlichen Disziplinen wie Informatik, Robotik, Neurowissenschaften und Business Analytics entwickelt. Wie oben dargelegt, erfordert die Umsetzung eines industriellen Anwendungsfalls in ein RL-Framework sorgfältige Überlegungen darüber, wie das Problem quantitativ spezifiziert werden kann und wie der RL-Agent am besten trainiert werden kann. Sobald diese sorgfältige Überlegung stattgefunden hat, bietet das RL-Framework ein leistungsfähiges Werkzeug zur Lösung vieler verschiedener Probleme in der Industrie und wird wahrscheinlich als Algorithmus der Wahl in so unterschiedlichen Geschäftsbereichen wie Fertigung, Automatisierung, Finanzen, Transport, Logistik, Predictive Maintence oder Gesundheitswesen immer dominanter werden.

0 Kommentare